В фильме о человеке, который сожалеет о своем великом технологическом открытии, потому что не учел его последствий, действительно можно увидеть некоторые параллели с нашим временем.

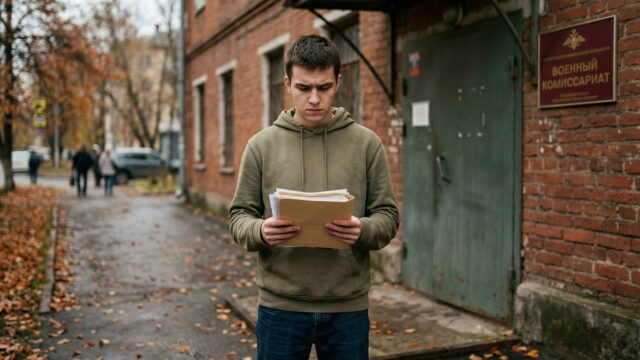

Когда Роберт Оппенгеймер узнал, что США атаковали Хиросиму, он начал сожалеть о своей роли в создании этой бомбы. Однажды, встретившись с президентом Гарри Трумэном, Оппенгеймер заплакал и выразил своё сожаление. Трумэн назвал его плаксой и сказал, что больше не хочет видеть его. Кристофер Нолан надеется, что когда зрители его фильма «Оппенгеймер» (выходит 21 июля) из Силиконовой Долины увидят его интерпретацию всех этих событий, они узнают себя в этой истории.

Нолан поделился мнением на недавнем предпремьерном показе «Оппенгеймера», который завершился встречей с физиками-ядерщиками и Каем Бердом — одним из авторов книги «Американский Прометей», которая легла в основу фильма.

Когда у Нолана спросили, надеется ли он, что Силиконовая Долина сможет извлечь что-то из его фильма, он ответил: «Я бы хотел, чтобы они поняли концепцию ответственности».

Затем он уточнил: «Когда вы изобретаете что-то инновационное, вы должны использовать это ответственно». Он имел в виду, что компании в Силиконовой Долине придумали и внедрили множество технологий, и теперь отказываются признавать вред, который эти технологии причинили. «За последние 15 лет появилось множество компаний, использующих различные алгоритмы, при этом не не желая брать на себя ответственность за то, что эти алгоритмы делают».

Он продолжил: «Искусственный интеллект — и вовсе ужасающая вещь. Не в последнюю очередь потому, что по мере внедрения систем искусственного интеллекта в оборонную инфраструктуру, в конечном счете они будут ответственны за ядерное оружие. А если человек перестанет быть ответственным за ядерное оружие, мы обречены. Мы должны сами отвечать за свои технологии».

Хотя Нолан не упомянул ни одну конкретную компанию, нетрудно понять, о ком он говорит. Google, Meta и даже Netflix в значительной степени зависят от алгоритмов для привлечения и удержания аудитории. Зачастую это приводит к непредвиденным, а порой и вовсе отвратительным последствиям. Наиболее заметный и поистине ужасный пример — вклад Meta в геноцид в Мьянме.

Конечно, компании извиняются, если алгоритм причинил кому-то вред. И, тем не менее, все продолжают использовать алгоритмы. На их основе работают даже только что запущенные сервисы. Иногда компании дают возможность отключить алгоритм, как это сделал Facebook, но это скорее исключение из правил. При этом все любят говорить о плюсах алгоритмов и очень редко говорят об их минусах.

«Когда я разговариваю с ведущими исследователями в области искусственного интеллекта, они называют наше время их моментом Оппенгеймера», — сказал Нолан. «Им интересна его история, потому что они хотят определить, какова ответственность ученых, разрабатывающих новые технологии, которые могут иметь непредвиденные последствия. И это полезно. Здорово, что это по крайней мере обсуждается. Я не говорю, что история Оппенгеймера даёт простые ответы на эти вопросы. Но она по крайней мере служит предостережением».