Мир вокруг нас постоянно и непрерывно меняется, хотим мы того или нет. И большую роль в этом играют технологии, развитие и распространение которых с каждым годом становится все активнее и активнее. Мы уже не считаем автомобиль редкостью, а мобильную связь магией. Технологии стали частью нашего быта, работы и нас самих. Одной из самых популярных среди футурологов и научных фантастов тем всегда были роботы — автономные машины, способные облегчить жизнь человеку или устроить тотальный геноцид всего живого на планете, если верить фильмам про Терминатора. В любом случае, остается ряд весьма забавных вопросов — как человек будет вести себя с машиной, будет ли он ей доверять и насколько эффективным будет их сотрудничество? Ученые из исследовательской лаборатории армии США решили провести ряд опытов, чтобы установить какие аспекты поведения и «внешнего вида» автономной машины улучшают сотрудничество с человеком. Что именно удалось выяснить мы узнаем из их доклада. Поехали

Основа исследования

Чтобы лучше понять взаимоотношения между человеком и машиной, в первую очередь стоит взглянуть на взаимоотношения между человеком и человеком. Учитывая, что население планеты разделено на множество групп (религия, национальность, этническая принадлежность и т.д.), человек всегда будет разделять людей на «мы» и «они». Этот процесс разделения, по словам исследователей, протекает на подсознательном уровне и приводит к повышению вероятности выбора для сотрудничества человека, относящегося к той же группе. Также ученые отмечают, что данные предпочтения не имеют ничего общего с проявлениями дискриминации по отношению к людям других национальностей, вероисповедания и прочего.

В случае с автономными машинами пока остается неясно, имеет ли место подобная социальная категоризация в момент кооперации человека и машины. Если она есть, то как проявляется, как регулируется и как ее можно изменить?

Чтобы проверить это, ученые провели ряд экспериментов, участниками которых стали люди из двух отдаленных культур (США и Япония) и машины с виртуальными лицами, соответствующими этим же культурам и выражающие те или иные эмоции.

Из США было 468 участников, а из Японии 477.

Демографические характеристики для группы из США были такие:

- пол: 63.2% — мужчины и 36.8% — женщины;

- возраст: 0,9% — 18-21; 58.5% — 22-34; 21.6% — 35-44; 10.7% — 45-54; 6.2% — 55-64; 2.1% — старше 64 лет;

- этническая принадлежность: 77.3% — кавказская; 10.3% — афро-американская; 1.3% — восточно-индийская; 9.2% — латиноамериканская; 6.0% — азиатская (юго-восточная).

Демографические характеристики для группы из Японии были такие:

- пол: 67.4 — мужчины и 32.6% — женщины;

- возраст: 0,6% — 18-21; 15.7% — 22-34; 36.4% — 35-44; 34.7% — 45-54; 10.4% — 55-64; 2.1% — старше 64 лет;

- этническая принадлежность: 0.6% — восточно-индийская; 99.4% — азиатская (юго-восточная).

Люди могут по разному относиться друг к другу, в зависимости от персональной категоризации, но стоит помнить, что автономная машина не является человеком. Следовательно, это устройство уже относится к другой социальной группе, так сказать по дефолту. Конечно, человек может воспринимать машину как социального актера (участника какого-то взаимодействия), но воспринимать он будет его не так, как воспринимал бы другого живого человека из плоти и крови.

Ярким тому примером служит проведенное ранее исследование мозга человека во время игры в «камень-ножницы-бумага». Когда человек играл с другим человеком, происходила активация медиальной префронтальной коры, которая играет важную роль в ментализации*.

Ментализация* — способность представлять психическое состояние самого себя и других людей.

Но при игре с машиной этот участок мозга не активировался.

Подобные результаты показали и эксперименты с игрой в ультиматум.

Игра в ультиматум* — экономическая игра, в которой игрок №1 получает определенную сумму денег и должен разделить ее с игроком №2, которого он видит в первый раз. Предложение может быть любым, но если игрок №2 откажется от него, то оба игрока не получат денег вообще.

Когда игрок №2 получал нечестное предложение от игрока №1 (человека), у него активировались участки центральной доли мозга, отвечающих за формирование негативных эмоций. Если же игроком №1 выступала машина, то подобной реакции не наблюдалось.

Подобные опыты лишний раз подтверждают факт того, что человек воспринимает машину не так как другого человека. Некоторые исследователи считают, что машина не представляет для нас конкуренции с точки зрения наших инстинктов, потому и наблюдается подобная пониженная (а то и вовсе ее нет) активность тех или иных участков мозга.

Все вполне логично: человек человеку волк, но даже между волками есть определенная степень доверия и желания сотрудничать в определенных условиях. А вот машина выступает в роли лисицы, с которой волки не хотят сотрудничать от слова совсем. Однако подобные предпочтения не отменяют того факта, что роботов в нашем мире становится все больше и больше, а посему нужно находить методы для улучшения взаимоотношений между нами и ими.

Почему исследователи решили использовать такой тип социальной категоризации как культурная идентичность? Во-первых, ранее уже было установлено, что человек положительно реагирует на машины, обладающие определенными речевыми особенностями (акцентом, например), социальными нормами и расой.

Во-вторых, в случаях, когда в экспериментах принимают участие представители разных социальных групп, на первых этапах прослеживается отчетливое переплетение кооперации и конкуренции. На последующих этапах, когда участники лучше узнают друг друга, вырисовывается четкая линия поведения, соответствующая задаче опыта. Проще говоря, участники из разных социальных групп первым делом не доверяли друг другу, даже когда задача опыта была связана с кооперацией. Но спустя некоторое время доверие и желание выполнить задачу перевешивало над подсознательным недоверием.

В-третьих, предыдущие опыты показали, что первоначальные ожидания кооперации, основанной на социальной категоризации, можно отвергнуть, если прибегнуть к более ситуативно значимым признакам (эмоциям).

То есть исследователи наделили машину визуальными чертами тех социальных групп, к которым относились участники экспериментов (люди), и рядом эмоциональных выражений, а потом проверили разные комбинации для выявления связи.

Из всего этого было выделено две основные гипотезы. Первая — ассоциирование положительных признаков культурной идентичности может смягчить неблагоприятные предубеждения, которые люди по умолчанию имеют к машинам. Вторая — выражение эмоций могут превзойти ожидания кооперации/конкуренции, основанной на культурной идентичности. Другими словами, если наделить машину визуальными чертами определенной культурной группы, то люди из этой же группы подсознательно могут ей больше доверять. Однако в случае проявления определенных эмоций, указывающих на нежелание машины вступать в кооперацию, все культурные предубеждения моментально перестают быть важными.

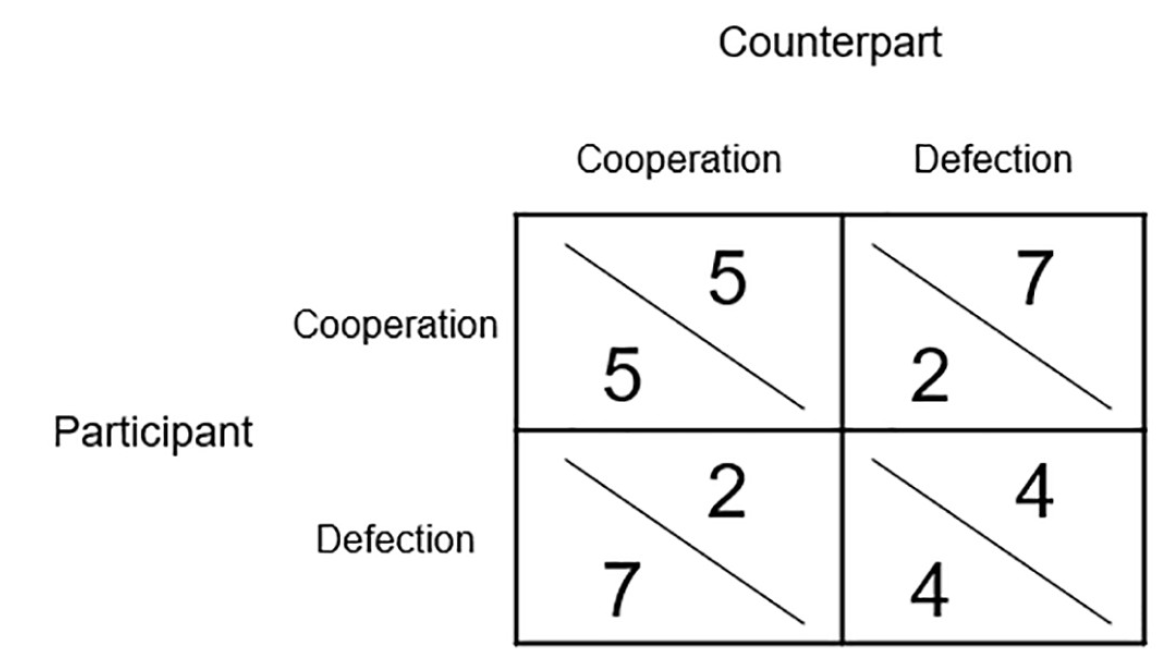

Любопытно, что в основе экспериментов была дилемма заключенного — игра, в которой кооперация не является выигрышной тактикой. Следуя теории игр, заключенный (игрок) всегда будет максимизировать собственную выгоду, не думая о выгоде других игроков. Таким образом, рациональность должна подталкивать игроков к предательству и нежеланию кооперировать, однако в реальности результаты подобных экспериментов зачастую далеки от рациональных, что объясняет наличие слова «дилемма» в названии этой математической игры. Есть и небольшой подвох — если один игрок считает, что второй не будет сотрудничать, то он также не должен сотрудничать, однако если оба игрока соблюдают такую тактику, то оба останутся в проигрыше.

Результаты экспериментов

Изображение №1

Всего каждый из участников опыта проводил по 20 раундов игры с машиной. Изображение выше это матрица выгоды. Очки, полученные в ходе игры, имели реальную финансовую выгоду, так как впоследствии конвертировались в лотерейные билеты с выигрышной суммой в 30 долларов.

Основной задачей эксперимента было выявления того, как участники будут сотрудничать/конкурировать с людьми или машинами, а также как на эти процессы будет влиять культурная идентичность и эмоции.

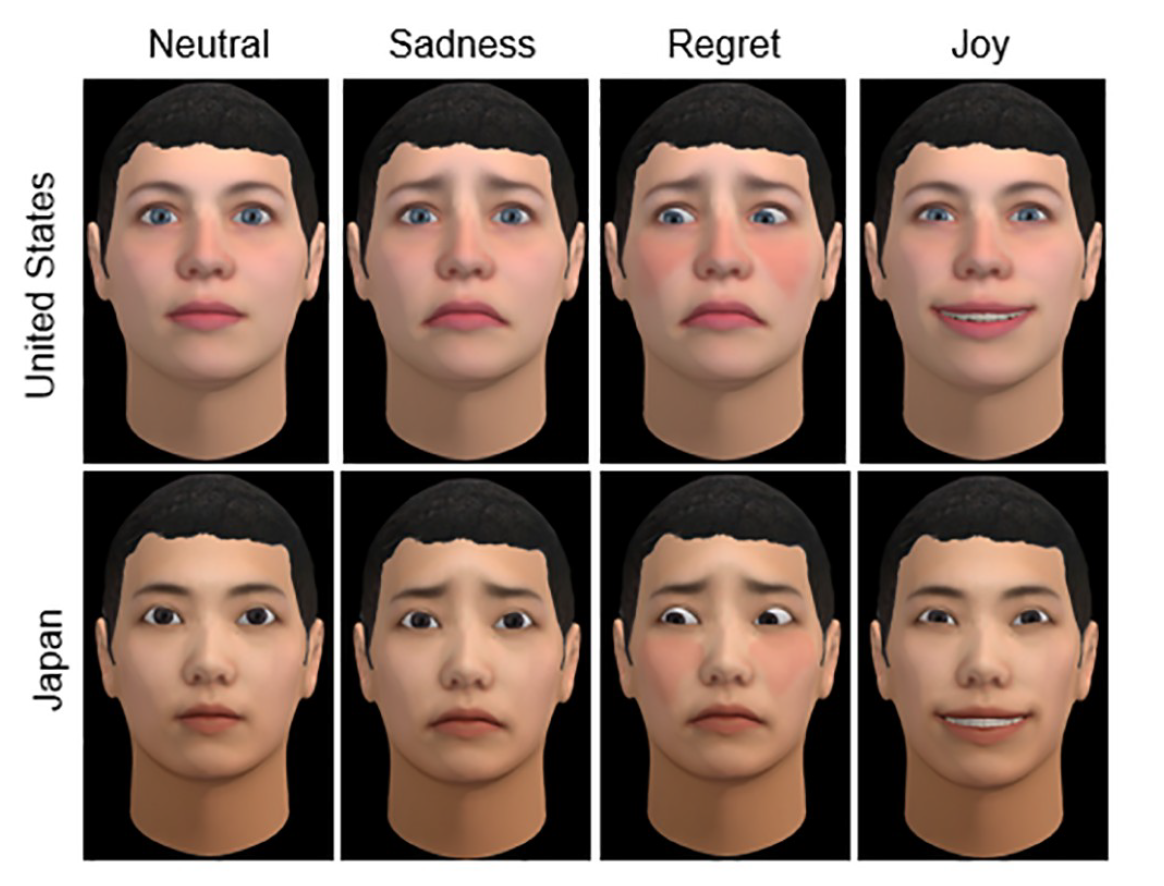

Изображение №2

Выше представлены две культурные идентичности (США и Япония) виртуальных лиц для машин, выражающие разные эмоции (нейтральная, грусть, сожаление и радость). Стоит отметить, что виртуальные лица использовались всеми участниками опытов, т.е. людьми и машинами.

Эмоциональный ряд был подобран не случайно. Ранее проведенные эксперименты с дилеммой заключенного показали, что одни эмоции могут побуждать к сотрудничеству, а другие к конкуренции, в зависимости от времени их выражения.

В данной модели эмоции машины, и действия вызывающие их, были разделены на две основные категории.

Подталкивающие человека к конкуренции:

- сожаление после взаимного сотрудничества (машина упустила возможность эксплуатации участника-человека для собственного блага);

- радость после эксплуатации (участник идет на сотрудничество, но ничего не получает взамен от машины);

- грусть после взаимной конкуренции / нейтральная эмоция после взаимной кооперации.

Подталкивающие человека к сотрудничеству:

- радость от взаимной кооперации;

- сожаление от эксплуатации;

- грусть после взаимной конкуренции.

Таким образом в эксперименте было одновременно несколько переменных факторов: культурная идентичность (США или Япония), заявленный тип партнера (человек или машина) и выраженные эмоции (конкурентные или сотруднические).

Результаты опытов были разбиты на две категории по типу пар участников: участники из одной культурной группы и участники из разных культурных групп.

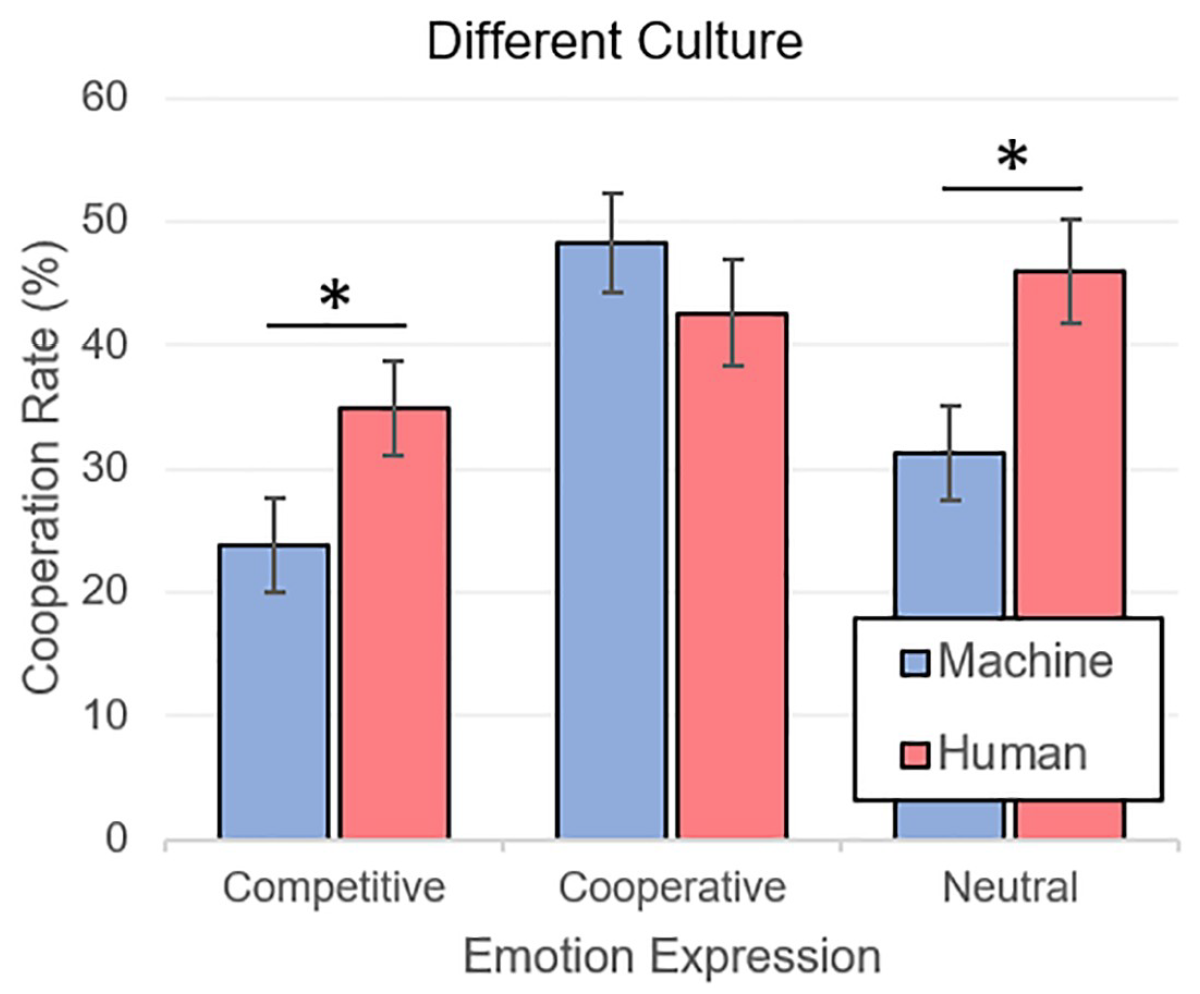

Изображение №3

Выше представлен график результатов (метод дисперсионного анализа, т.е. ANOVA) экспериментов, в которых в игре сошлись разные культурные группы. Как и ожидалось, сотрудничество с людьми (M = 41.15, SE = 2.39) было выражено больше, чем сотрудничество с машинами (M = 34.45, SE = 2.25). Касательно эмоций все было не менее предсказуемо — игроки чаще сотрудничали с теми, кто выражал эмоции кооперации (M = 45.42, SE = 2.97), чем эмоции конкуренции (M = 29.34, SE = 2.70). Нейтральные эмоции (M = 38.63, SE = 2.85) также выигрывали у конкурентных.

Любопытно, что эмоции, вызывающие доверие у игроков-людей, полностью нивелировали факт того, что они играют с машиной, тем самым снижая степень недоверия.

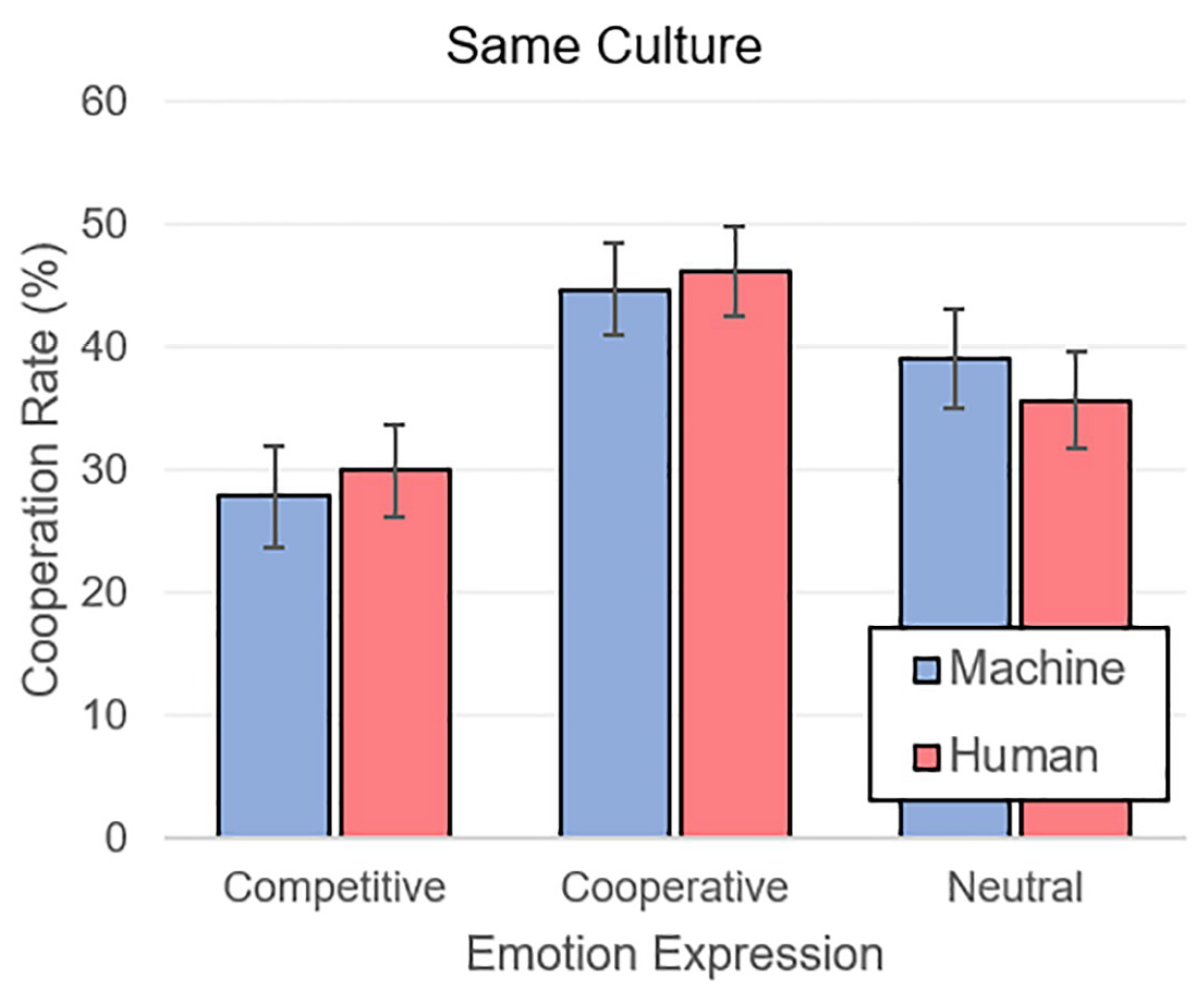

Изображение №4

Когда участники сталкивались с партнерами из той же культурной группы, ситуация была схожей. Кооперативные (M = 45.55, SE = 2.61) эмоции перевешивали над нейтральными (M = 37.42, SE = 2.81) и конкурентными (M = 28.99, SE = 2.78).

Совокупность полученных результатов дает понять, что человек использует в общении с машиной те же психологические параметры доверия и недоверия, что и другим человеком. Автономные машины изначально воспринимаются как члены чужой для человека социальной группы. Однако использование визуального лица с чертами определенной культурной идентичности, соответствующей человеку-партнеру, может смягчить недоверие к машине.

Самое же важное наблюдение заключается в том, что культурная идентичность и принадлежность к машинам полностью нивелируются правильными, если можно так выразится, эмоциями.

Для более детального ознакомления с нюансами исследования рекомендую заглянуть в доклад ученых.

Эпилог

Данное исследование весьма неоднозначно, однако оно показывает нам важную особенность человеческой психологии. Мы неосознанно категоризируем окружающих людей на определенные социальные группы, испытывая большее доверие к тем, кто относится к нашей группе. Это первичная наша реакция. Но она не является единственной, так как при общении с человеком мы начинаем получать ряд сигналов (визуальных и звуковых), выражаемых эмоциями, манерой речи, голосом и т.д. Эти сигналы дополняют картину представления человека для нас, от чего мы отталкиваемся в момент принятия решения — доверять или нет. Другими словами, социальная категоризация, которая происходит у нас в головах, никакого значения не имеет, когда дело доходит до живого общения. Именно об этом говорят старые поговорки: «встречают по одежке, а провожают по уму» и «не суди книгу по обложке».

По отношению к машинам человек всегда был настроен с опаской и недоверием, которые зачастую не были подкреплены существенными причинами. Такова натура человека — изначально отвергать то, что чуждо. Однако, как знания побеждают невежество, так и фактическое взаимодействие с автономными машинами, способными выражать эмоции, побеждают человеческие предубеждения.

Говорит ли это о том, что все роботы в будущем должны обладать эмоциями? И да, и нет. Исследователи, чей труд мы сегодня рассматривали, считают, что на первых парах эмоции для роботов будут отличной функцией, способной ускорить процесс принятия автономных машин обществом людей. Что тут скажешь, с волками жить — по-волчьи выть, как бы грубо ни звучало.

К тому же, мы и так уже наделяем роботов своими чертами: делаем им глаза, как у нас, лица, как у нас, наделяем их голосами и эмоциями. Человек всегда будет стараться очеловечить машину, и, как показывает это исследование, не зря.

Благодарю за внимание, оставайтесь любопытствующими и отличных всем выходных, ребята! 🙂

Спасибо, что остаётесь с нами. Вам нравятся наши статьи? Хотите видеть больше интересных материалов? Поддержите нас, оформив заказ или порекомендовав знакомым, облачные VPS для разработчиков от $4.99, 30% скидка для пользователей Хабра на уникальный аналог entry-level серверов, который был придуман нами для Вас: Вся правда о VPS (KVM) E5-2650 v4 (6 Cores) 10GB DDR4 240GB SSD 1Gbps от $20 или как правильно делить сервер? (доступны варианты с RAID1 и RAID10, до 24 ядер и до 40GB DDR4).

Dell R730xd в 2 раза дешевле? Только у нас 2 х Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 ТВ от $199 в Нидерландах! Dell R420 — 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB — от $99! Читайте о том Как построить инфраструктуру корп. класса c применением серверов Dell R730xd Е5-2650 v4 стоимостью 9000 евро за копейки?