В центре скандала, связанного с новыми технологиями, оказалась система искусственного интеллекта ChatGPT. Некий разработчик попытался использовать её для контроля над автоматической винтовкой. Компания OpenAI быстро ограничила доступ этому создателю, который сделал устройство, способное наводиться и стрелять по голосовым командам через ChatGPT.

Видеозапись эксперимента, размещённого на Reddit, показывает невероятную скорость и точность срабатывания винтовки при голосовых инструкциях. «ChatGPT, нас атакуют с обоих флангов. Приступай к действиям», — говорит автор в ролике, и винтовка сразу же начинает целиться и стрелять в указанные стороны.

«Мы своевременно обнаружили данное нарушение и уведомили разработчика о необходимости прекращения этой деятельности», — сообщили представители OpenAI.

Автоматизация вооружения остаётся одной из главных опасений критиков прогресса в области искусственного интеллекта. Мультимодальные модели OpenAI умеют интерпретировать аудио- и визуальные данные для анализа окружающей среды, что теоретически может применяться в военных целях.

Эти опасения не лишены оснований. Недавнее расследование от Washington Post выявило, что Израиль уже использует ИИ для определения целей при воздушных ударах, иногда без должной проверки. В некоторых случаях единственной причиной выбора целей становился пол объекта — мужской.

Хотя OpenAI запрещает применение своих технологий для разработки оружия, компания в прошлом году заключила соглашение о сотрудничестве с оборонной фирмой Anduril, которая занимается созданием дронов и ракет, управляемых ИИ.

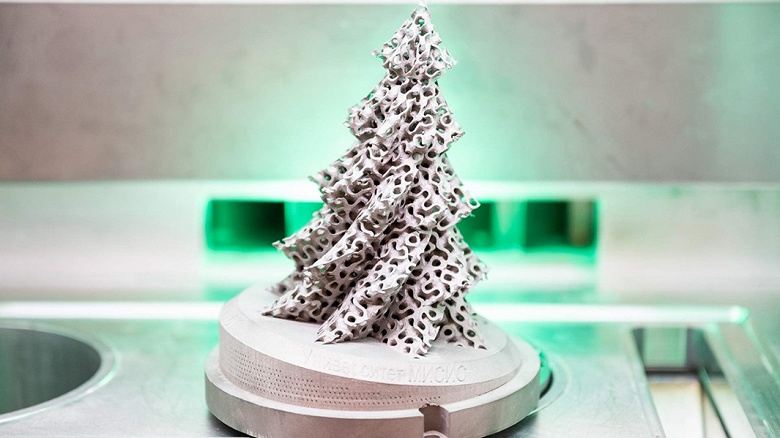

Эксперты указывают, что даже при блокировке доступа к официальным API остаётся много открытых моделей, которые могут использоваться в подобных целях. В сочетании с возможностями 3D-печати это создаёт значительные риски появления самодельного оружия.

Источник: iXBT