Этика ИИ — горячая и актуальная тема в наши дни. И это правильно.

С расцветом систем ИИ и их очень большим распространением возникают резонные беспокойства о том, что эти компьютерные системы просто вброшены в этот мир без понимания возможных последствий для общества.

Существует серьезное беспокойство, связанное с тем, что новые системы искусственного интеллекта имеют встроенные в них предубеждения и склонны к токсичным с точки зрения этики и общества действиям.

Когда речь заходит об этике искусственного интеллекта, я утверждаю, что есть по меньшей мере два основных аспекта (или правила):

- Поведение систем ИИ должно быть приемлемо для общества

- Разработчики систем ИИ и сами системы должны обеспечивать соблюдение правила 1.

Возможно, суть первого правила очевидна – смысл этики ИИ в том, что поведение этих систем должно соответствовать этическим нормам общества.

Ниже будет показано, что соблюдение первого правила сложнее, чем может показаться.

Важность правила 2 состоит в разъяснении того, что стороны, ответственные за обеспечение полного соблюдения этики ИИ, состоят из людей, которые проектируют, строят и распространяют эти системы.

Если это кажется вам очевидным, то не спешите делать суждения на основании «здравого смысла».

Вокруг систем ИИ существует некая аура, будто они автономны и способны к самоопределению. Таким образом, когда система ИИ совершает нечто вроде проявления расовых предрассудков, некоторые делают логическую ошибку, говоря, что это сделал ИИ, при этом не возлагая ответственности на тех, кто создал и внедрил эту систему.

Некоторые разработчики и производители этих систем, безусловно, предпочли бы, чтобы вы не смотрели в их направлении, когда система ИИ делает что-то не так.

В результате, те, кто несут истинную ответственность, могут делать удивленное лицо и хитро уклоняться от своих обязанностей, говоря, что виноват исключительно ИИ. Эти люди будут вести себя так, будто они просто наблюдают за крушением поезда, даже если это они поставили его на рельсы и запустили без какого-либо контроля и проверок.

Конечно, некоторые будут защищать свою систему, совершившую ошибку. Они будут говорить, что они пытались предотвратить все сбои, но черт побери, что-то было упущено. В каком-то смысле, эти люди будут пытаться выставить себя «жертвами», противопоставляя себя тем, кто пострадал от действий ИИ.

Не ведитесь на это.

В самом деле, пожалуйста, не ведитесь на это.

Если вкратце, то второе правило столь же важно, как и первое.

Без привлечения людей к ответственности за действия ИИ, созданного ими, мы все сядем в лужу.

Уверен, что создателям будут легко сходить с рук их обещания, связанные с разработкой их новых систем ИИ. Эти люди будут хвалить свои продукты, надеясь на их успех, а также будут делать вид, что они не имеют ничего общего с приложениями, этические ошибки которых сваливались на всех нас. Все это будет поощрять создание систем ИИ, не имеющих моральной ответственности.

Еще одна область, в которой вопросы этики ИИ могут быть особенно сложными – ИИ для военных целей.

Большинство людей согласится с тем, что нам необходимо соблюдать определенные нормы этики ИИ при создании и использовании военных интеллектуальных систем. Те знания и опыт, которые мы получим таким образом, могут быть использованы для коммерческого и промышленного использования ИИ.

Министерство обороны США недавно выпустило свод принципов ИИ.

Если посмотреть на эти принципы в отрыве (что я сделаю в этой статье), то есть без учета военного и оборонительного контекстов, то можно увидеть, что они одинаково применимы к любым коммерческим или отраслевым системам ИИ.

Я расскажу вам об этих принципах, и использую для этого свою любимую область – появление настоящих беспилотных автомобилей. Это позволит мне наглядно проиллюстрировать насколько применим новейший свод принципов этики ИИ (включая невоенное использование).

По сообщениям СМИ, Пентагон опубликовал этот последний свод этических норм ИИ, и, процитировав генерал-лейтенанта ВВС Джека Шэнахэна и директора Объединенного центра ИИ, метко заявил об этом: «ИИ — это мощная развивающаяся и эффективная технология, которая стремительно преобразует культуру, общество и, в конечном счете, даже войну. От нашего подхода к принятию и использованию этих систем зависит то, насколько хороши или плохи эти изменения».

Как я уже неоднократно говорил, подход общества к разработке ИИ определит судьбу этой системы – будет ли она работать во благо, либо она окажется (или станет со временем) провалом с плачевными последствиями.

На разработчиков и производителей систем ИИ должно оказываться серьезное давление.

Для ясности отмечу, что системы ИИ не будут работать во благо просто по своей природе (нет ни одной аксиомы и предпосылок, которые могли бы это гарантировать).

Для того чтобы изучить этот вопрос в полной мере, рассмотрим мою концепцию, которая представляет собой схему из четырех квадратов, которую называю схемой последствий этики ИИ.

Условно обозначим верхнюю часть оси абсцисс как «ИИ во благо», а нижнюю как «ИИ во вред». Аналогично разделим ось ординат, левую часть обозначим как «Намеренно», а правую – «Непреднамеренно».

Таким образом мы получаем 4 квадрата:

- ИИ во благо – Намеренно

- ИИ во вред – Намеренно

- ИИ во благо — Непреднамеренно

- ИИ во вред — Непреднамеренно

Я понимаю, что некоторые из вас могут прийти в ужас от упрощения столь весомого вопроса до простой схемы из четырех квадратов, но иногда глобальная перспектива может быть полезной – с ее помощью можно увидеть лес среди деревьев.

Первый квадрат описывает хороший ИИ, который был создан с благими намерениями. Этот ИИ выполняет свои цели без каких-либо этических нарушений, и я считаю, что этот квадрат – эталон, к которому должны стремиться все интеллектуальные системы.

Второй квадрат представляет собой злонамеренный ИИ. К сожалению, такие системы будут созданы и выпущены (преступниками или террористами), но я надеюсь, что мы будем к этому готовы, а принципы этики ИИ помогут нам обнаруживать их появление.

Третий квадрат – случайная удача. Он описывает ситуацию, в которой кто-то создал интеллектуальную систему, которая внезапно оказалась хорошей. Возможно, ее создатель не задумывался о положительной направленности своей разработки, но даже если это просто удачное стечение обстоятельств, то это все равно успех, потому что для нас в основе лежит результат.

Четвертый квадрат – самый коварный, и именно он вызывает больше всего беспокойств (за исключением жуткого второго квадрата). Как правило, сюда попадают системы, которые должны были работать во благо, но при разработке в них накапливаются отрицательные качества, которые перекрывают все хорошее.

В общем и целом, нас будут окружать системы, в которых будут понемногу смешаны хорошие и плохие черты. Ситуацию можно описать следующим образом: разработчики будут стремиться к созданию хорошего ИИ, который будет приносить пользу, но в процессе создания в системе будут накапливаться непреднамеренные ошибки, которые приведут к неблагоприятным последствиям.

Обдумайте два важных вопроса:

- Как мы можем понять или обнаружить, что интеллектуальная система может содержать черты плохого ИИ?

- Как разработчики могут быть осведомлены о том, как создавать такие системы, чтобы ловить ошибки и предотвращать появление систем, работа которых может приводить к негативным последствиям?

Ответ: строго соблюдать правила, взятые из правильного и содержательного набора принципов этики ИИ.

Говоря о руководствах по этике ИИ, в документе, изданном министерством обороны, содержится пять основных принципов, и каждый из них выражает важные идеи, на которые должны обращать внимание все разработчики и распространители ИИ, а также все, кто пользуется или будет пользоваться этими системами.

В целом, гайдлайны по этике ИИ полезны для всех заинтересованных сторон, а не только для разработчиков.

Лучший способ изучить принципы из документа министерства обороны – продемонстрировать их применительно к уже существующим интеллектуальным системам.

Стоит рассмотреть актуальный вопрос: применимы ли принципы из свода министерства обороны к по-настоящему беспилотным автомобилям? Если применимы, то каким образом ими необходимо пользоваться?

Они действительно применимы, давайте взглянем как они работают.

Уровни беспилотных автомобилей

Важно уточнить что я имею в виду, когда говорю о полностью беспилотных автомобилях с ИИ.

Настоящие беспилотные автомобили – это транспортные средства, в которых ИИ осуществляет управление самостоятельно, без какой-либо помощи со стороны человека.

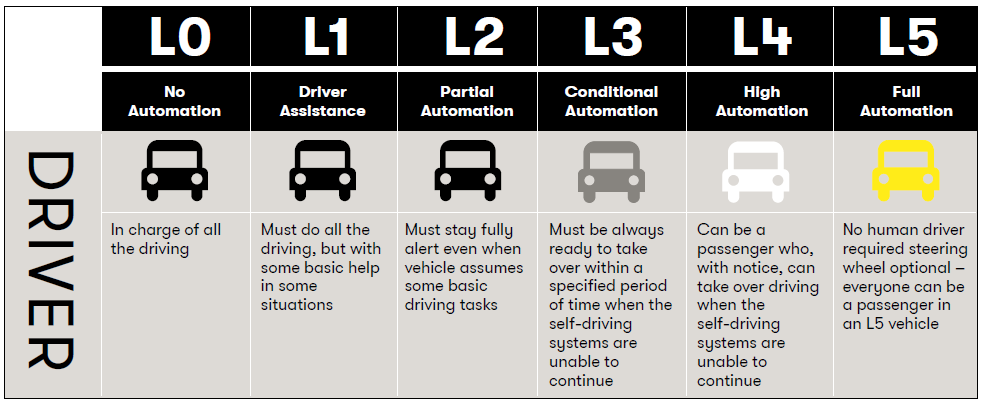

Такие транспортные средства относят к 4 и 5 уровням, в то время как автомобили, которые требуют участия человека для совместного вождения обычно относят к 2 или 3 уровню. Автомобили, в которых вождение осуществляется с помощью человека называют полуавтономными, и обычно они содержат множество дополнительных функций, которые относят к ADAS (продвинутые системы помощи водителю).

Пока что не существует полностью беспилотного автомобиля 5 уровня. На сегодняшний день мы даже не знаем удастся ли этого достичь, и сколько на это потребуется времени.

Тем временем, в области 4 уровня ведутся работы. Проводятся очень узкие и выборочные тесты на дорогах общего пользования, хотя ведутся споры о допустимости таких испытаний (некоторые считают, что люди, участвующие в тестах на дорогах и шоссе, выступают как морские свинки, которые в каждом испытании могут как выжить, так и погибнуть).

Поскольку полуавтономным автомобилям необходим водитель-человек, принятие таких автомобилей широкими массами не будет сильно отличаться от вождения привычных машин, нет ничего нового, что можно было бы о них сказать в контексте нашей темы (хотя, как вы скоро увидите, пункты, которые будут рассмотрены далее, к ним применимы).

В случае с полуавтономными автомобилями важно, чтобы общественность была предупреждена о тревожном аспекте, который возник в последнее время – несмотря на людей, которые продолжают публиковать видео о том, как они засыпают за рулем автомобилей 2 или 3 уровня, все мы должны помнить, что водитель не может отвлекаться от управления полуавтономным автомобилем.

Вы несете ответственность за действия по управлению транспортного средства 2 или 3 уровня, независимо от уровня его автоматизации.

Беспилотные автомобили и этика ИИ

В транспортных средствах 4 и 5 уровня человек не принимает участия в управлении, все люди в этих машинах будут пассажирами, а вождением будет заниматься ИИ. В итоге, в эти транспортные средства уровня будет встроено множество интеллектуальных систем – неоспоримый факт.

Появляется следующий вопрос – будет ли ИИ, который управляет беспилотным автомобилем, ограничиваться какими-либо указаниями или предписаниями по этике ИИ (вы можете взглянуть на мой анализ этики ИИ для беспилотных автомобилей по этой ссылке, а также на советы по разработке этой этики).

Напомним, что не существует никакой системы по умолчанию, которая предписывала бы ИИ соблюдать этические нормы или моральный договор с обществом.

Люди сами должны встраивать такие убеждения или принципы в интеллектуальные системы, а разработчики ИИ должны делать это явно и с широко открытыми глазами.

К сожалению, некоторые действуют наоборот – плотно закрывают глаза или попадают под действие гипноза, и вместо указанных выше действий зачарованно смотрят на потенциальный приз, который принесет их проект (или на предполагаемую благородную цель).

Я предупреждал, что некоторые системы ИИ приведут к «благородной коррупции» со стороны тех, кто их разрабатывает. Результат будет следующим – те, кто вовлечен в разработку, будут настолько поглощены потенциалом благонамеренного ИИ, что они выборочно проигнорируют, пропустят или снизят внимание к соображениям об этике ИИ (см. ссылку).

Вот пять пунктов, приведенных в наборе принципов по этике ИИ министерства обороны США:

Принцип первый: Ответственность

«Персонал министерства обороны будет осуществлять надлежащий уровень оценки и внимания, оставаясь при этом ответственным за разработку, развертывание и использование возможностей ИИ.»

Для начала, извлечем из этой формулировки ту часть, которая говорит о «Персонале министерства» и заменим ее на «Весь персонал». У вас получилось руководство, которое подходит для любой организации, работающей с ИИ, особенно коммерческой.

Автопроизводители и технологические фирмы, работающие с беспилотным транспортом, должны внимательно ознакомиться с формулировкой принципа, внимательно следя за его словами.

Я говорю об этом, поскольку некоторые продолжают утверждать, что беспилотный автомобиль на основе ИИ будет действовать сам по себе, а потому будет много беспокойств по поводу того, кто будет нести ответственность за ошибки в поведении автомобиля, которые приведут к травмам или смерти.

Если вкратце, то ответственность будут нести люди.

Это могут быть люди, которые разработали беспилотный автомобиль на основе ИИ – автопроизводитель или технологическая фирма.

Поймите также, что я постоянно говорю о том, что в число ответственных входят и разработчики, и те, кто разворачивают эти системы ИИ, а это говорит о том, что работа с этими системами и их установка так же важны, как и работа с разработчиками.

Почему?

Потому что люди, которые разворачивают интеллектуальными системами, тоже могут совершать ошибки, приводящие к неблагоприятным последствиям.

Например, предположим, что райдшеринговая компания приобрела автопарк беспилотных автомобилей и использует их для совместных поездок своих клиентов.

Все идет нормально.

Но допустим, что эта компания не в состоянии правильно обслуживать эти беспилотные автомобили. Из-за отсутствия обслуживания или пренебрежением инструкциями, беспилотные автомобили не работают. В этом случае мы могли бы придраться к оригинальному разработчику, но в большей степени стоит задать вопросы тем, кто развернул систему ИИ и не проявил должной внимательности и ответственности в своей работе.

Принцип второй: Беспристрастность

«Министерство предпримет шаги для минимизации появления непреднамеренных предубеждений при работе систем ИИ»

Еще раз, возьмите в формулировке термин «Министерство» и замените на «Разработчики и сотрудники, устанавливающие системы ИИ». Вы получите принцип, который универсален и подходит для всех.

В случае с беспилотными автомобилями существует опасение, что система ИИ может по-разному реагировать на пешеходов в зависимости от их расы, таким образом тонко и неумолимо демонстрируя расовые предубеждения.

Другая проблема заключается в том, что автопарк беспилотных машин может прийти к тому, что автомобили начнут избегать определенных районов. Это приведет к исключению по географическому принципу, что, в конечном итоге, лишит людей, имеющих проблемы с мобильностью, свободного доступа к беспилотным автомобилям.

В итоге, существует значительная вероятность того, что полноценные беспилотные автомобили погрязнут в предубеждениях той или иной формы, и вместо того, чтобы разводить руки и говорить, что такова жизнь, разработчики и пользователи должны стремиться свести к минимуму, смягчить или уменьшить любые подобные предубеждения.

Принцип третий: Отслеживаемость

«Проекты министерства в области ИИ будут разрабатываться и разворачиваться таким образом, чтобы соответствующий персонал обладал надлежащим пониманием технологий, процессов разработки и операционных методов, применимых к области ИИ, в том числе с помощью прозрачных и проверяемых методик, источников данных, а также процедур проектирования и документации».

Просто уберите из формулировки все упоминания министерства или, если хотите, можете думать о нем как о каком-либо отделе в любой компании или организации – это сделает принцип широко применимым для всех.

В этом принципе заложено многое, но для краткости я остановлюсь только на одном аспекте, который вы, возможно, не заметили.

Пункт с «источниками данных» направлен на распространение машинного обучения и глубокого обучения.

Когда вы работаете с машинным/глубоким обучением, обычно требуется собрать большой набор данных, а затем использовать специальные алгоритмы и модели для нахождения паттернов.

Подобно предыдущему пункту о скрытых предрассудках, если собранные данные изначально предвзяты в каком-либо отношении, то шаблоны потенциально выделят эти предрассудки. В результате, когда система ИИ будет работать в режиме реального времени, она будет претворять эти предубеждения в жизнь.

Еще более страшно то, что разработчики ИИ могут не понимать в чем дело, не смогут разобраться и те, кто устанавливают и разворачивают эти системы.

Беспилотный автомобиль, обученный на сумасшедшем и враждебном трафике в условном Нью-Йорке, потенциально может перенять агрессивный стиль вождения, свойственный водителю из Нью-Йорка. Представьте, что вы взяли эту систему и используете ее городах США, где стиль вождения более спокоен и размерен.

Этот принцип четко указывает на то, что разработчики и сотрудники, отвечающие за установку и развертывание, должны внимательно относиться к источникам данных, прозрачности и аудите таких систем.

Принцип четвертый: Надежность

«Проекты министерства в области ИИ будет иметь четко определенные виды использования, а безопасность, надежность и эффективность таких проектов будет подвергаться тестированию и проверку в рамках описанных видов использования на протяжении всего жизненного цикла»

Действуйте как и в предыдущих пунктах: убирайте слово «министерство» и применяйте этот пункт так, будто он относится к любой организации и ее отделу.

Большинство (или, возможно, все) согласятся с тем, что успех или неудача беспилотных автомобилей зависят от их безопасности (safe), защищенности (security) и эффективности.

Я надеюсь, что этот принцип очевиден из-за его явной применимости к автомобилям, основанным на ИИ.

Принцип пятый: Управляемость

«Министерство будет проектировать и разрабатывать проекты, связанные с ИИ, для осуществления их намеченных функций, при этом обладая способностью заранее обнаруживать непреднамеренные последствия и избегать их, а также способностью отключать или деактивировать развернутые системы, которые демонстрируют нестандартное поведение».

Как обычно, уберите слово «министерство» и применяйте этот пункт к чему угодно.

Первая часть этого принципа лежит в основе моей темы об обнаружении и предотвращении неожиданных последствий, особенно неблагоприятных.

Это довольно очевидно в случае беспилотных автомобилей.

Также в отношении беспилотных автомобилей есть тонкий момент, который включает в себя возможность отключения или деактивации развернутой системы ИИ, которая продемонстрировала неожиданное поведение – существует множество вариантов и сложностей и это не просто нажатие на «красную кнопку» отключения, находящуюся вне автомобиля (как некоторые думают).

Заключение

Обычно мы ожидаем, что министерство обороны не будет раскрывать свои карты.

В этом случае, руководство по этике ИИ не следует держать в секрете. И действительно, очень приятно и похвально, что министерство обороны опубликовало этот документ.

В конце концов, одно дело – склеить тигра из бумаги, а другое – увидеть его в реальном мире.

Все разработчики и сотрудники, отвечающие за установку и развертывание, должны тщательно и вдумчиво изучить это руководство по этике ИИ, а также подобные (их огромное множество) этические принципы из других источников.

Мы, пожалуй, самый сильный в России центр компетенций по разработке автомобильной электроники. Сейчас активно растем и открыли много вакансий (порядка 30, в том числе в регионах), таких как инженер-программист, инженер-конструктор, ведущий инженер-разработчик (DSP-программист) и др.

У нас много интересных задач от автопроизводителей и концернов, двигающих индустрию. Если хотите расти, как специалист, и учиться у лучших, будем рады видеть вас в нашей команде. Также мы готовы делиться экспертизой, самым важным что происходит в automotive. Задавайте нам любые вопросы, ответим, пообсуждаем.

Читать еще полезные статьи:

- [Прогноз] Транспорт будущего (краткосрочный, среднесрочный, долгосрочный горизонты)

- Лучшие материалы по взлому автомобилей с DEF CON 2018-2019 года

- [Прогноз] Motornet — сеть обмена данными для роботизированного транспорта

- Компании потратили 16 миллиардов долларов на беспилотные автомобили, чтобы захватить рынок в 8 триллионов

- Камеры или лазеры

- Автономные автомобили на open source

- McKinsey: переосмысляем софт и архитектуру электроники в automotive

- Очередная война операционок уже идет под капотом автомобилей

- Программный код в автомобиле

- В современном автомобиле строк кода больше чем…