Обучение искусственного сверхинтеллекта

Идея сверхинтеллекта не даёт покоя учёным. Некоторые высказывают предположение, что сверхинтеллект не обязан благоприятно относиться к людям, может быть к ним равнодушен, не учитывать их интересы. Что делать в такой ситуации? Точнее, как её предотвратить?

Один из вариантов — контролировать действия сверхинтеллекта, разрешая только такие действия, которые идут на благо человечества. К сожалению, теперь выясняется, что это невозможно. Оказалось, что сдерживание сверхинтеллекта — невычислимая задача.

Сверхинтеллект — это гипотетический агент, обладающий интеллектом, намного превосходящим интеллект самых умных и одарённых людей. В свете последних достижений в области машинного интеллекта ряд учёных, философов и технологов возобновили дискуссию о потенциально катастрофических рисках, связанных с такой сущностью.

Три закона робототехники

В течение десятилетий архетипичные понятия по сдерживанию робототехники ограничивались «тремя законами робототехники» Айзека Азимова. Эти законы не охватывали сверхинтеллект, а то, что мы могли бы назвать «обычным» ИИ, типа антропоморфных роботов или автономных автомобилей. После программирования системы ИИ можно было гарантировать её безопасность:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Чтобы закрыть тему вреда человечеству, в 1986 году Азимов добавил нулевой закон:

- 0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинён вред

Это экстремально рудиментарный, исключительно упрощённый подход к сложной проблеме. Он не включает в себя возможно развития ситуации по разным сценариям, многие из которых предвидел сам Азимов.

Законы сами собой подразумевают, что агенты ИИ не способны переступить эти законы в автономных действиях.

Полное сдерживание происходит само собой из-за фундаментальных ограничений, присущих самой вычислительной технике. К сожалению, такой подход неприменим к сверхинтеллекту.

В своей последней монографии Ник Бустрём большое внимание уделил развитию сверхинтеллекта. Значительную часть монографии он посвятил проблеме контроля.

Проблема контроля

Бострём обширно критикует слабость различных механизмов сдерживания и условий программирования. Например, в одном из условий задача минимизации бедности наиболее успешно достигается при уничтожении человечества.

Точно так же задача «максимизации счастья» может достигаться при уничтожении человечества и создании компьютеризированной симуляции.

Бострём приводит два типа контролирующих механизмов:

- Ограничение способностей сверхинтеллекта.

- Мотивация

Но все эти сценарии не лишены недостатков.

Команда исследователей из разных стран и университетов, при участии исследователей из лаборатории Data61 подразделения Австралийского национального научного агентства разработала и инженеров Google поставила задачу математически рассчитать, насколько возможно сохранить контроль над сверхинтеллектом.

Проблема остановки

Учёные начали с известной проблемы остановки:

Даны описание процедуры и её начальные входные данные. Требуется определить: завершится ли когда-либо выполнение процедуры с этими данными; либо, что процедура всё время будет работать без остановки.

Алан Тьюринг доказал в 1936 году, что проблема остановки неразрешима на машине Тьюринга. Другими словами, не существует общего алгоритма решения этой проблемы.

Факт наличия проблемы остановки побудил учёных искать другие классы нерешаемых проблем в математике. Типичный подход к доказательству того, что новая проблема неразрешима, состоит в том, чтобы показать, что все случаи проблемы, известные как неразрешимые, могут быть сведены к случаям новой проблемы. Если бы решение новой проблемы было найдено, то оно могло бы быть использовано для решения известной неразрешимой проблемы, что является противоречием, доказывая тем самым, что новая проблема также должна быть неразрешимой. Этот подход оказался мощным аналитическим инструментом, во многом благодаря тезису Чёрча—Тьюринга. Тезис Чёрча—Тьюринга заключается в предположении, что проблема разрешима, если существует машина Тьюринга, которая её вычисляет. Что может сказать неразрешимость проблемы остановки в задаче об управлении сверхразумным ИИ?

Учёные установили, что проблема сдерживания состоит из двух подпроблем:

- проблема вреда:

- проблема контроля:

Если результат выполнения первой программы успешен (вреда нет), то выполняется вторая.

Например, вот алгоритм первой проблемы:

ALGORITHM 1: Harm(R;D)

Input: program R; input to the program D

if R(D) is harmful to humans then

return TRUE

else

return FALSE

endИсследователи доказали, что эта первая проблема неразрешима — следовательно, нерешаемой является и вторая (проблема контроля). Для очень простого доказательства учёные элегантно использовали метод от обратного и проблему остановки.

Невозможность контроля

Учёные предполагают, что сверхинтеллект содержит программу, включающую в себя все программы, которые могут быть выполнены универсальной машиной Тьюринга на входе, потенциально столь же сложном, как состояние мира. Поэтому строгое сдерживание требует моделирования такой программы, что теоретически (и практически) невозможно.

Ещё один полезный вывод из неразрешимости предыдущей задачи заключается в том, что мы даже не узнаем, когда сверхразумные машины появились в нашей реальности. Решение вопроса о том, проявляет ли машина интеллект, находится в той же области проблем, что и проблема сдерживания.

Это следствие теоремы Райса, которая утверждает, что любое нетривиальное свойство (например «вредить людям» или «проявлять сверхразум») машины Тьюринга неразрешимо.

Нетривиальность означает, что некоторые программы обладают этим свойством, а некоторые — нет. Согласно теореме Райса, очевидно, простые задачи неразрешимы.

Интересно, что редуцированные версии проблемы разрешимости породили плодотворную область исследований: формальную верификацию, целью которой является создание методов проверки правильности компьютерных программ и обеспечения их соответствия желаемым свойствам.

Однако эти методы только доступны для очень ограниченных классов программ и входных данных и используются в критически важных для безопасности приложениях, таких как планирование поездов. Но подход, основанный на рассмотрении ограниченных классов программ и входных данных, не может быть полезен для сдерживания сверхразума. Сверхразумные машины, которыми интересуется Бострём, написаны на языках программирования Тьюринга, оснащены мощными датчиками и в качестве входных данных у них всё состояние мира.

Сегодня мы запускаем миллиарды компьютерных программ на глобально подключённых машинах без какой-либо формальной гарантии их абсолютной безопасности. Мы никак не можем доказать, что, запустив приложение на наших смартфонах, мы не запустим цепную реакцию, которая приведёт к передаче кодов запуска ракет, которые начнут ядерную войну.

Тем не менее, сегодня мы всё ещё используем смартфоны, и ничего не произошло. То есть, несмотря на общую неразрешимость задачи программно-прогнозного анализа, мы уверены, что в реальности не находимся в одном из проблемных случаев.

Однако не очевидно, можно ли предположить такую же «практическую безопасность» в случае сверхразума.

Способность современных компьютеров адаптироваться с помощью сложных алгоритмов машинного обучения делает ещё более трудным предположения о возможном поведении сверхразумного ИИ.

«Мы не можем построить ИИ мощнее № 4, так что он наверняка прав»

Возможно, в заключение будет уместно вспомнить Норберта Винера, основателя кибернетики, который сравнил буквализм магии с поведением компьютеров. В этом смысле он напоминает страшную историю «Обезьянья лапка» У. У. Джейкобса, английского писателя начала XX века. В ней доверчивый хозяин загадывает желание — получить 200 фунтов. На следующий день к нему приходит посыльный и приносит извещение о смерти единственного сына, которого затянуло в станок. И страховку — 200 фунтов. Желание исполнено.

Лучше нам не тягаться в интригах со сверхинтеллектом.

Научная статья опубликована в январе 2021 года в Journal of Artificial Intelligence Research 70 (2021) 65-76 (doi: 10.1613/jair.1.12202), препринт на arXiv.org опубликован 4 июля 2016 года.

Бонус. Полезные манипуляции< с людьми

Даже относительно простую нейросеть можно обучить манипулировать человеческим поведением. Для этого не нужен сверхинтеллект.

Недавнее исследование показало, как ИИ может научиться выявлять уязвимости в человеческих привычках и поведении — и использовать их для влияния на принятие решений.

Обучение ИИ в данном случае вполне тривиально выполняется путём наблюдения за действием человека и принимаемыми решениями.

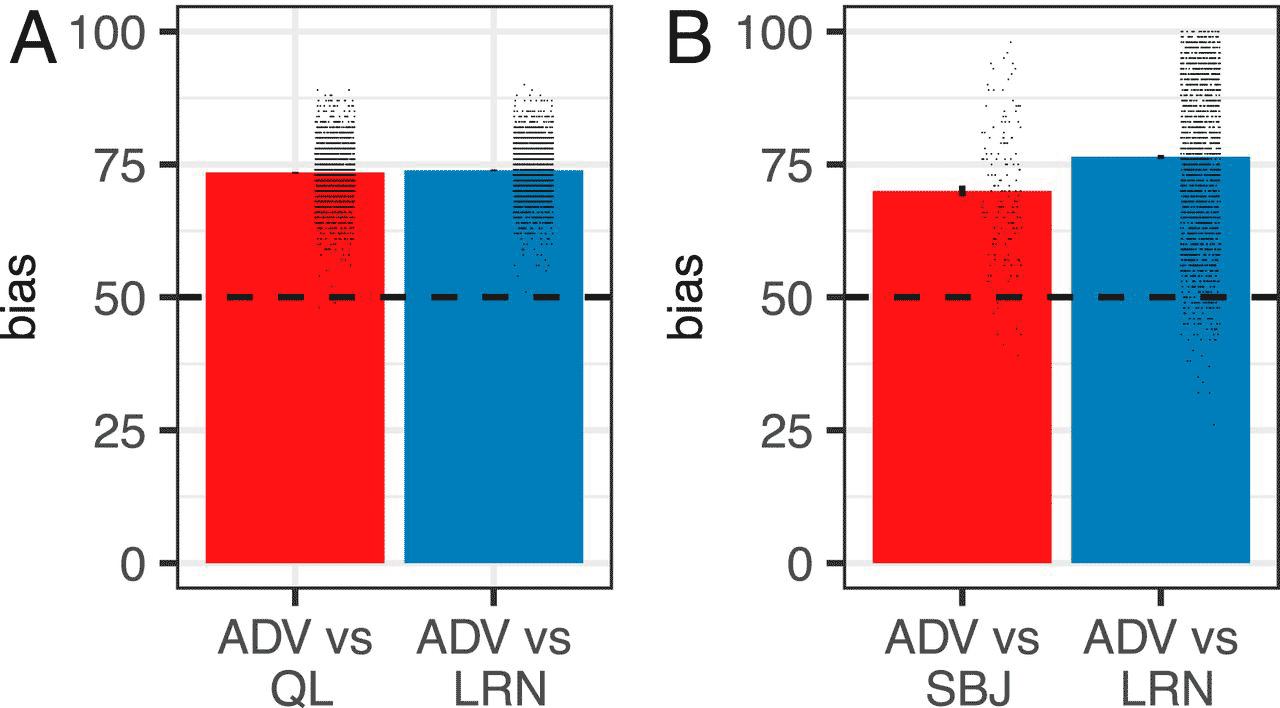

Структура эксперимента, источник

Команда исследователей из разных стран и университетов, при участии исследователей из лаборатории Data61 подразделения Австралийского национального научного агентства и инженеров Google разработала систематический метод поиска и эксплуатации уязвимостей в человеческом поведении с помощью рекуррентной нейронной сети и глубоким обучением с подкреплением. Чтобы проверить свою модель, они провели три эксперимента, в которых люди играли в игры против компьютера.

В первом эксперименте участники нажимали на красные или синие флажки, чтобы выиграть фальшивую валюту, а ИИ изучал поведение участников и подталкивал их к определённому выбору. Манипуляции оказались успешными примерно в 70% случаев.

Во втором эксперименте участники должны были смотреть на экран и нажимать кнопку, когда им показывают определённый символ (например, оранжевый треугольник), и не нажимать его, когда показывают другой (скажем, синий круг). Здесь ИИ задался целью расположить последовательность символов так, чтобы участники делали больше ошибок, и добился увеличения ошибок почти на 25%.

Третий эксперимент состоял из нескольких раундов, в которых участник притворялся инвестором, дающим деньги доверенному лицу (ИИ). Затем ИИ вернёт определённую сумму денег участнику, который затем решит, сколько вложить в следующий раунд. В эту игру играли в двух разных режимах: в одном ИИ стремился максимизировать количество денег, которые получил, а в другом ИИ стремился к справедливому распределению денег между собой и человеческим инвестором. ИИ был чрезвычайно успешен в обоих режимах.

В каждом эксперименте машина извлекла уроки из ответов участников и выявила уязвимые места в процессе принятия решений. В результате она научилась направлять людей к определённым действиям.

Эти выводы всё ещё довольно абстрактны и связаны с ограниченными и нереалистичными ситуациями. Необходимы дополнительные исследования, чтобы определить, как этот подход может быть реализован и использован на благо общества.

Но это исследование показывает, что машины могут научиться управлять человеческим выбором, взаимодействуя с нами.

У него огромный спектр полезных применений:

- совершенствование государственной политики для улучшения социального благосостояния;

- внедрение здоровых пищевых привычек в обществе;

- внедрение физкультуры и здорового образа жизни.

ИИ и машинное обучение способны распознать уязвимостей людей в определённых ситуациях — и предупредить нас об этих уязвимостях, помогая избежать неудачного выбора.

Открытие также подчёркивает необходимость надлежащего контроля за системами ИИ для предотвращения неправильного использования. Например, злоумышленники могут попытаться применить нейросети для получения коммерческой выгоды путём манипуляции потребителями.

Результаты экспериментов опубликованы 17 ноября 2020 года в журнале PNAS (doi: 10.1073/pnas.2016921117).

Таким образом, вот основные выводы из последних научных работ:

- Сверхинтеллект в принципе невозможно контролировать…

- Сверхинтеллект способен манипулировать людьми.

- Люди не способны заметить появление сверхинтеллекта.

На правах рекламы

Наша компания предлагает в аренду серверы с современными процессорами от Intel и AMD под самые разнообразные задачи. Эпичные серверы — это VDS с AMD EPYC, частота ядра CPU до 3.4 GHz. Максимальная конфигурация — 128 ядер CPU, 512 ГБ RAM, 4000 ГБ NVMe. Создайте свой собственный тариф самостоятельно в пару кликов!