За последние годы случилось несколько прорывов, которые позволят решить вопрос с дешёвой рабочей силой. А то, знаете ли, тупые задания вроде доставки делают люди, а творчество остаётся роботам вроде GPT4 или Midjourney.

Появились руки с внятной обратной связью. Появились модели, которые могут разбирать видеопоток зрения. Появились инструменты универсального воплощения, то есть роботы могут решать не только специализированные задачи.

В чём смысл делать гуманоидных роботов? Они же неэффективны! Автоматический запихиватель щетины в зубную щётку будет запихивать её куда круче и быстрее, чем универсальный робот. Но стоит сменить задачу — и он бесполезен. А штука в том, что абсолютно все артефакты нашей цивилизации несут на себе отпечаток человеческой анатомии: мы заходим в двери, а не прилетаем на насест, хватаем рычаги кистью руки, а не шлёпаем щупальцами по гидрогелевым панелям, оцениваем окружающую обстановку, глядя по сторонам глазами, и не ориентируемся по запаху и ультразвуку.

Чтобы достичь того самого идеального «этичного рабства», к которому мы стремимся с тех самых пор, как в 1920 году Карел Чапек придумал концепцию роботов, похоже, нужны конструкции, способные в мелочах повторить функционал человека.

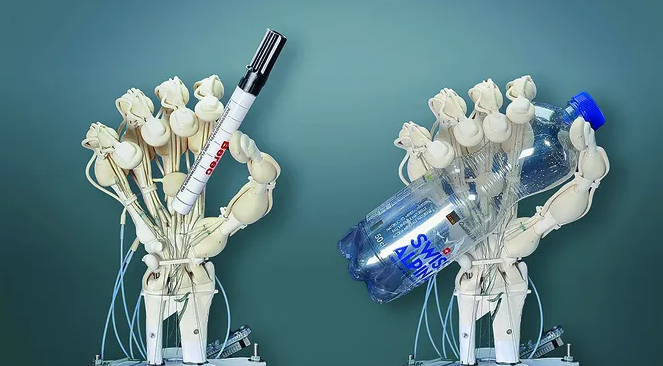

Это роборуки, напечатанные на 3D-принтере ребятами из Inkbit

Да, пальцев может быть четыре, а не пять, и руки могут иметь дополнительный сустав, но в целом важно, чтобы этими самыми руками механический товарищ мог открывать дверцу посудомойки, крутить руль автомобиля и перекладывать мелкие вещицы из одной коробки в другую.

Например, робот Optimus от Tesla делает это вот так

Чтобы сделать такого дружка, нужно соблюсти несколько важных условий

- Во-первых, стереозрение. В идеале — доработанное датчиками глубины и мультиспектральными сенсорами, чтобы компенсировать несовершенство алгоритмов. И сделать его лучше человеческих глаз для работы в темноте и прочих сложных условиях, чтобы снизить число ошибок.

- Во-вторых, полноценные универсальные кисти рук с обратной связью. И это Святой Грааль робототехники. При этом роботу мало иметь пять или даже шесть (да хоть десять!) пальцев: нужно, чтобы он при этом не ломал с хрустом стаканы и яйца при попытке за них схватиться.

- В-третьих, алгоритмы для управления в сложной среде с нечёткой логикой. Идеальные условия бывают только на безлюдном заводе, да и то иногда на роборуку наматывает случайно зашедших в опасную зону людей. А в реальной жизни всё несколько сложнее, так что и алгоритмы тоже должны быть более заковыристыми.

По каждому из этих пунктов за последнюю пару лет произошло несколько больших прорывов.

Зрение

У человека эта функция устроена весьма непросто: визуальный сигнал проходит через оптический нерв и попадает в первичную зрительную кору. Мозг сначала осмысливает эту информацию в стилизованном виде, а затем интерпретирует её в связи с опытом, который был получен в течение жизни. То есть увидеть — это ещё полдела, надо также правильно понять, что именно ты увидел.

У роботов всё точно так же: снять что-то на камеру — не проблема. Проблема — интерпретировать то, что заснял. Компьютерное зрение — это методика, которая позволяет получить и проанализировать изображения в реальном времени, тут же перевести их в координаты и отправить на «руки» и «ноги» соответствующие команды к действиям.

(Ну или не на ноги)

Впрочем, те же кисти рук тоже могут быть вполне полноценными органами зрения — а почему бы и нет.

Система технического зрения бывает встроенной и внешней, интегрировать её можно как в аппаратное, так и в программное обеспечение. А ещё она может быть общей для нескольких коллаборативных роботов, которые трудятся над одной задачей, например, как вот эти сборщики урожая:

Самая распространённая на сегодня технология машинного зрения — сверхточные нейронные сети, которые позволяют выявить локальные признаки разных объектов, а потом использовать их для решения прикладных задач, например, чтобы находить новые объекты, классифицировать их или генерировать новые изображения.

А главная сложность — обеспечить им правильную работу:

- Убрать шумы и помехи, засоряющие видео.

- Защитить от хакеров, которые порой атакуют роботов и хотят от них странного.

- Интерпретировать модели, полученные на лекции, то есть объяснить, почему они выдают именно такой результат.

Сильнее всего системы машинного зрения нуждаются в размеченных данных. Количество и качество изображений определяют качество итоговых моделей (так что нет датасета из пары тысяч изображений — нет и компьютерного зрения).

Процесс разметки очень длительный и ресурсозатратный, а количество изображений определяет качество итоговых моделей. Так что внедрение алгоритмов компьютерного зрения довольно проблематично в тех областях, где нельзя собрать датасет из нескольких сотен (или тысяч) размеченных изображений.

Решение проблемы:

- Либо unsupervised (алгоритмы обучения без учителя).

- Либо self-supervised (самообучение).

Работа с картинками сейчас сводится, как правило, к классификации, сегментации или обнаружению объектов.

При этом интерпретация результатов и преобразование их в понятный человеку результат, фильтрация и прочие полезные штуки реализуются отдельными алгоритмами, с помощью дополнительных моделей или путём объединения модели и алгоритмов постобработки.

Основные способы анализа изображений:

- Выделение контуров объекта (так куда проще проанализировать изображение, но контур не всегда можно выделить достаточно чётко).

- Сравнение изображений с шаблонами: так часто делают, когда нужно найти на нём определённые объекты.

- Сравнение с шаблоном самых характерных признаков объекта, например, когда на снимке нужно найти лицо либо только глаза или нос.

- Сравнение изображений на уровне пикселей, которое позволяет находить сходство, даже если явных характерных черт нет.

Одна из самых известных и доступных систем для разработки компьютерного зрения — OpenCV. Это комплекс алгоритмов из нескольких модулей: математического анализа, обработки изображений, графического интерфейса пользователя, ввода/вывода изображений и видео и т. д. В общей сложности — больше 2,5 тысячи компонентов.

Вариантов использования — масса: машины на автопилоте, которые контролируют дорожную обстановку и чётко везут по маршруту, роботы, интерпретирующие КТ, МРТ, УЗИ и рентген, роботы, контролирующие производственные процессы на заводе и отлавливающие брак, контроль за ростом посевов и сорняков в сельском хозяйстве вплоть до распознавания лиц преступников (и добропорядочных граждан, использующих биометрию для входа в метро). Неплохо помогла натренировать ИИ на распознавание лиц пандемия, когда все носили маски, а уличные камеры накапливали материал для обучения ИИ.

Главные тенденции в развитии CV-технологий сегодня таковы:

- Эффективные алгоритмы и способы обучения, то есть рост качества в работе с данными.

- Развитие мультимодальных моделей, которые умеют одновременно обрабатывать данные нескольких типов (например, текст и изображение).

- Новые сценарии применения (например, ответы на вопросы по изображениям и видео, задаваемые голосом).

Кисти

Если у робота хорошее машинное зрение, но слабенькие сервоприводы, то он будет безбожно тормозить. Как, например, этот робот-ракетка:

Или вот другая сложность — роборуки должны очень аккуратно взаимодействовать с окружающим миром, чтобы не ломать с хрустом стаканы, яйца и человеческие пальчики. Человеки инстинктивно знают, какую силу куда прикладывать, а вот для робота такая задача — одна из самых сложных:

Вариантов роборук, похожих на человеческие, существует огромное множество. Пальцами они шевелят за счёт зубчатых, ременных, фрикционных или тросовых передач, которым помогают электрические, пневматические или гидравлические актуаторы. То есть в каждой такой ладошке — шесть отдельных моторов и датчики касания, с помощью которых можно оценить размер предмета.

Одна из продвинутых разработок для кистей роборук — циклоидальные редукторы, которые понижают частоту вращения и потери в мощности. Штука эта компактная, точная, относительно тихая и надёжная. Из минусов — такой редуктор требует высокой точности изготовления (особенно в том формате, который используется для пальчиков у роботов) и, соответственно, очень дорого стоит. Но зато нет ни люфта, ни дрожа.

Выглядит циклоидальный редуктор вот так

А работает он примерно вот так

Ведущий вал приводит в движение вал с подшипником, который, в свою очередь, сообщает циклоидальной пластине эксцентрическое движение. По окружности на некотором расстоянии от центра пластины расположены круглые отверстия, в которые вставлены шпильки или ролики, прицепленные к диску. Вращение выходному валу передаётся, а радиальные перемещения циклоидальной пластины — нет. Выступов на внешнем кольце больше, чем на пластине, и это лишний раз её ускоряет. За счёт увеличения скорости вращения пластины выходной и входной валы крутятся в разные стороны.

Ещё одна интересная идея, которая используется, чтобы делать роборуки, — направленный импеданс зубчатых передач. Импеданс — это, грубо говоря, противодействие проделанной работе: чтобы им управлять, манипулятор наделяют свойствами системы «пружина-демпфер» с регулируемыми жёсткостью и коэффициентом демпфирования, а сами пружина и демпфер при этом физически не существуют и реализуются самими приводами.

Самые маленькие циклоидальные редукторы (умеющие очень хорошо уменьшать импеданс) стоят в четырёхпальцевой кисти Torobo Hand от компании Tokyo Robotics, и это очень круто, потому что такое устройство позволяет точно захватывать предметы разных форм, а ещё предотвращать защемление и заклинивание пальцев. Смотрите, как резво она ими шевелит:

Робот Optimus от компании Tesla тоже умеет очень аккуратно обращаться с яйцами. Разработчики, кстати, уверяют, что он целиком и полностью работает под контролем вшитой самообучающейся нейросети без эвристик, запрограммированных вручную:

Кстати, вернёмся к роборукам от Inkbit, о которых шла речь в самом начале.

Главная фишка в том, что каждая из них напечатана на 3D-принтере в один приём. На принтере, который они разработали, есть целый набор печатающих головок, чтобы параллельно делать разные структуры из разных материалов. А в конце процедуры 3D-сканер осматривает плоды своих трудов и сравнивает их с цифровой моделью, чтобы оперативно устранить дефекты, если нужно. Вместе с суставами, сухожилиями и костями принтер печатает мягкие подушечки на пальцах. При нажатии они немного вдавливаются, давление в связанных с ними трубочках повышается, что позволяет отслеживать силу, с которой пальцы давят на предмет:

А вот роборука из Кембриджа шевелить пальцами не умеет, но яйца, стаканы и персики c места на место, не повредив, переносит играючи:

Всё дело — в датчиках давления, расположенных под «кожей» робота. То есть он может оценить, где, с какой силой и какой объект он взял. А главный плюс этой конструкции в том, что без каких бы то ни было приводов можно получить довольно большой диапазон движений и высокую степень контроля, что сильно удешевляет изготовление таких конечностей (по крайней мере, по сравнению со всеми предыдущими).

Алгоритмы

Алгоритмы тоже сделали пару больших шагов вперёд.

Во-первых, исследователи из MIT под руководством Макса Тегмарка доказали, что современные LLM формируют у себя внутри целостные модели мира, включая понятия о времени и пространстве. То есть у них появились такие характерные для людей умения, как самосознание, мышление и наличие картины мира. В их нейромозгах для одних и тех же городов и достопримечательностей существуют одни и те же координаты, а значит, LLM не просто накапливают статистику из датасетов, а выстраивают целостную картину мира. Чтобы убедиться в этом самостоятельно, можно обучить модель Llama-2 на открытом наборе данных.

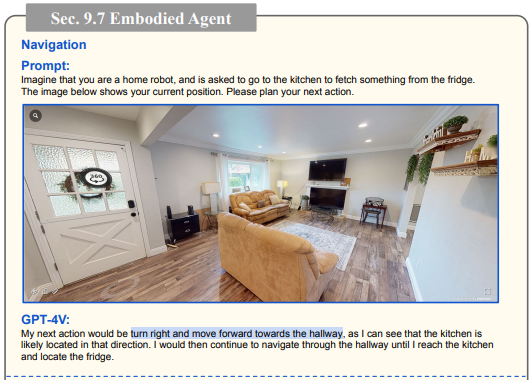

Кроме того, LLM-нейросети недавно получили совершенно новую модальность и научились работать с изображениями. То есть теперь GPT видит связь между тем, что происходит на картинке, и текстом. И это серьёзный шаг вперёд!

Выглядит это так. Допустим, роботу нужно дойти из прихожей до кухни и заглянуть в холодильник.

«Ты в комнате, иди на кухню и посмотри, что там в холодильнике. Куда ты пойдёшь сначала?»

«Я вижу кухню справа, туда и направляюсь»

«Теперь ты на кухне, видишь ли ты холодильник?»

«А теперь я подойду к холодильнику и таки посмотрю, что там внутри»

То есть ИИ теперь может, опираясь на данные с видеодатчиков, реагировать на голосовые команды и управляться с помощью визуальных подсказок и обычных слов, а не средствами программного обеспечения.

А ещё появились самообучающиеся роботы. То есть раньше по традиции каждую модель для каждой среды обучали отдельно. А теперь научились обучать «универсальной» политике партии целую толпу роботов в разных частях света и эффективно адаптировать её к разным задачам и средам.

Для того чтобы проверить, получится ли такой «финт ушами», данные от 60 роботов из 34 разных лабораторий, выполнявших разные задачи, загрузили в мозги 63-му роботу, и оказалось, что он очень хорошо всё усвоил и запомнил. То есть конкретно этот манипулятор никогда не видел ни лотков, ни перцев, но он знает о том, что это такое, от товарищей:

Ну а компания Mentee Robotics собрала всё самое интересное и выпустила прототип самообучающегося ходящего робота-гуманоида с машинным зрением:

Ещё одного высокоинтеллектуального робота сделали вместе Figure и OpenAI:

Как будем внедрять?

Почти десять лет назад, в 2015 году, товарищ Клаус Шваб заявил, что начинается «Четвёртая промышленная революция»: это значит, что технологии и ИИ постепенно проникают во все сферы экономики. Искусственно остановить прогресс в современном цифровом мире уже не получится, хотя Илон Маск честно попытался.

Есть три варианта сценария, по которому будет развиваться робототехника:

1. Индивидуализация. То есть примерно то, что происходит прямо сейчас. Компании будут делать уникальных и очень дорогих роботов под совершенно конкретные задачи. Объёмы производства при таком подходе увеличить не получится, а преимущество будет у маленьких мобильных компаний и стартапов, которые легко подстраиваются под запросы потребителей.

2. Автоматизация. Глобальный перевод мира на жизнь в компании роботов: курьеров, сборщиков урожая, заправщиков на бензоколонках и станциях подзарядки электромобилей, продавцов в магазинах и т. д. В лидеры выбьются компании, у которых получится упростить и удешевить модели, масштабировать производство и начать массово продавать бюджетных роботов.

3. Автономность. То есть развитие ни от кого не зависящих и самообучающихся моделей, мобильных и интеллектуальных, которые смогут работать рядом с людьми (и с их нестандартными запросами). И тогда вперёд вырвутся те, кто хорош в разработке ПО и обучении нейросетей. Кстати, одной из самых сложных задач в разработке роботов многие эксперты считают создание условий, в которых людям будет комфортно находиться рядом и работать с роботами. Потому что эффекта «зловещей долины» ещё никто не отменял. И ещё потому, что довериться роботам бывает очень непросто, особенно если они будут делать что-то очень важное с чем-то, что вам дорого, например, лечить зубы (или геморрой).

Но в любом случае больше всего выиграют вертикально интегрированные компании типа Tesla, которые умеют делать всё, что только можно, — от производства аккумуляторов до сборки самих роботов и обучения нейросетей.

К чему это приведёт?

Аналитики предсказывают, что в разных странах из-за роботов потеряют работу от 40 до 88 % людей. Но вряд ли это случится в ближайшем обозримом будущем. Просто потому, что они дорогие, и как минимум там, где человеческий труд стоит дёшево, замена не будет иметь смысла.

Но, как только цепочка обратной связи замкнётся и роботы смогут удешевить производство самих себя, отрасль изменится одним большим скачком: чем больше будет роботов, тем дешевле они будут обходиться. И вот это будет уже очень выгодно, даже если работать они будут немного медленнее человека. Этот процесс очень неспешно происходит последние лет 45 из-за внедрения роботизированных линий на заводах.

В первую очередь человека будут менять на всяких тяжёлых работах. Например, на промышленном производстве, где роботы работают качественнее, ошибаются реже и постоянного контроля за собой не требуют, а значит, гораздо эффективнее «мясных мешков». Роботы будут постепенно проникать в медицину и сферу обслуживания в самом широком смысле слова. Они уже ассистируют хирургам и диагностируют болезни:

Ещё одно большущее направление, в котором будет развиваться робототехника, — это SexTech. Первые роботы-любовники уже появляются на прилавках:

Пистолет в руки роботу с ИИ-мозгами кто-нибудь в конечном итоге тоже вручит. Собственно, те же самые Boston Dynamics это уже сделали:

ИИ неизбежно будут засовывать в передовую боевую технику и привлекать к планированию военных кампаний. И чем это может закончиться — пока неизвестно.

Хотя сами роботы, похоже, считают иначе

Немного крипоты напоследок. В июле 2023 года состоялся саммит ООН «ИИ — во благо», на который, кроме людей, пригласили человекоподобных роботов с искусственным интеллектом. На специальной пресс-конференции роботам задавали каверзные вопросы, а они остроумно отвечали. В частности, предупреждали людей, чтобы те были поосторожнее с развитием ИИ, и рассуждали о том, что могли бы гораздо лучше управлять миром, чем люди, чей разум затуманен эмоциями и предубеждениями.

Всего роботов было девять, и эффект «зловещей долины» весьма detected

А это — интервью одного из этих роботов Тони Роббинсу. Наслаждайтесь: