Иллюстрация

Есть много фильмов и фантастических книг, в которых компьютерная система обретала сознание и обманывала своих человеческих создателей. Возможно ли подобное в реальности? Пока поводов для беспокойства мало.

Мы впечатлены программами AlphaGo и Libratus, успехами роботов Boston Dynamics, но все известные достижения касаются лишь узких сфер и пока далеки от массового распространения. В повседневной жизни люди взаимодействуют с псевдоинтеллектуальными помощниками ( Siri, «Okay, Google», Amazon Alexa), каждый из которых не претендует на лавры действительно «умной» программы.

Впрочем, успехи в области проектирования искусственного интеллекта действительно впечатляют. И чем ближе день, когда ИИ станет полноценным инструментом влияния на общественные процессы, тем больше накапливается ошибок, указывающих на возможность обхода гипотетических «трех законов робототехники».

Тезис «чем сложнее система — тем больше в ней лазеек и ошибок» имеет прямое отношение и к проблемам с ИИ.

Когда у страха появились глаза

Мудрая русская пословица говорит о том, что боязливому везде представляются опасности. Истоки страха перед искусственной жизнью корнями уходят в многовековые архетипы ужаса. Еще до историй о Викторе Франкенштейне и сказках о зомби существовали поверья о големах, существах, оживленных из глины магами-каббалистами.

Бояться нового (и живого) — это нормально для человека. В 1978 появилась гипотеза, согласно которой робот или другой объект, выглядящий или действующий примерно как человек (но не точно так, как настоящий), вызывает неприязнь и отвращение у людей-наблюдателей. Гипотеза лишь зафиксировала опыт: зомби перед вами, голем или робот-помощник, не так важно — относиться ко всем вы будете с одинаковой опаской.

Роботы, похожие на людей, это лишь верхний слой проблемы. Илон Маск, Билл Гейтс, Стивен Хокинг и сотни экспертов в области робототехники, физики, экономики, философии не скрывают своих опасений по поводу негативных последствий для человечества от интеллектуальных систем в будущем.

Мы любим щекотать себе нервы — недаром франшиза «Терминатор» пользуется такой популярностью. А уж как много «злонамеренных» ИИ было в других фильмах и книгах. Трудно уже различить, это ли наше бессознательное проецируется на культуру, или массмедиа оказывают воздействие на общество.

Взрывной рост в «голубом океане»

Экономическая стратегия «голубого океана» утверждает, что компаниям, желающим достичь успеха, нужно не бороться с конкурентами, а создавать «океаны» бесконкурентных рынков. Такие стратегические решения позволяют мгновенно получать дополнительную выгоду компании, её покупателям и работникам — посредством поиска нового спроса и делая конкуренцию ненужной.

Долгие годы ИИ оставался таким «океаном». Все прекрасно понимали, что даже слабый искусственный интеллект превратится для любой компании мощнейший инструмент, повышающий качество любых продуктов и услуг. Вот только никто точно не знал, что именно нужно сделать. «Зима» ИИ, длившаяся с 1973 года до наших дней, характеризовалась полной стагнацией в области проектирования «умных» машин.

За тридцать лет самым важным достижением ИИ стала победа компьютера IBM в игре против чемпиона мира по шахматам — событие, не влияющее значительно на повседневную жизнь какого-либо человека (кроме Гарри Каспарова). Однако в 2010-е годы случилось нечто, сравнимое с разработкой ядерного оружия — вторую волну развития получили нейронные сети.

Потрясающий факт: ученые без особых успехов занимались разработкой искусственных нейронных сетей более 70 лет. Но к 2015 году в этой сфере начался взрывной рост, который продолжается и сейчас. Одновременно случилось вот что:

- «железо» достигло необходимого уровня — современные видеокарты позволили обучать нейросети в сотни раз быстрее;

- появились большие и общедоступные массивы различных данных, на которых можно обучаться (датасеты);

- усилиями различных компаний были созданы как новые методы обучения, так и новые типы нейросетей (например, такая прекрасная вещь как генеративно-состязательная сеть);

- благодаря множеству открытых научных исследований появились готовые, предобученные нейросети, на основании которых можно было быстро делать свои приложения.

За успехами ИИ интересно следить даже не на классическом примере обработки изображений (чем, в основном, и занимаются нейросети), а в области беспилотных автомобилей. Вы удивитесь, но увлечение «самоходными» машинами началось почти 100 лет назад: в 1926 году в рамках проекта «Фантомный Автомобиль» состоялась первая попытка дистанционно управлять машиной.

Легендарный беспилотник Navlab 5

Первые беспилотные автомобили появились в 1980-х: в 1984 году проект Navlab университета Карнеги-Меллон и ALМ, и в 1987 году — проект Мерседес-Бенц и Eureka Prometheus Project Военного университета Мюнхена. Navlab 5, законченный в 1995 году, стал первым автомобилем, который автономно проехал от одного побережья США до другого.

До бума нейросетей самоуправляемые автомобили оставались лабораторными проектами, страдавшими от ненадежности софта. Успехи в области обработки изображений позволили машинами «понимать», что они видят вокруг себя, и оценивать дорожную ситуацию в режиме реального времени.

Программное обеспечение беспилотного автомобиля может и не включать машинное зрение и нейросети, но с глубоким обучением удалось добиться прогресса, который на данный момент имеет решающее значение в успехе беспилотников.

В «голубом океане» внезапно стало тесно. В настоящее время свои беспилотники делают General Motors, Volkswagen, Audi, BMW, Volvo, Nissan, Google (и Waymo под патронатом Google), Tesla, «Яндекс», UBER, Cognitive Technologies и «КАМАЗ», а также десятки других компаний.

Беспилотники создаются на уровне государственных программ, включая программу Европейской Комиссии с бюджетом в 800 млн евро, программу 2getthere в Нидерландах, исследовательскую программу ARGO в Италии, соревнование DARPA Grand Challenge в США.

В России госпрограмма реализуется институтом ГНЦ РФ ФГУП «НАМИ», создавшим электробус «Шатл». В проекте участвуют «КАМАЗ» и команда разработчиков Яндекса, которая отвечает за создание инфраструктуры по прокладке маршрута и обработке данных о плотности дорожного движения.

Автомобили — это, вероятно, первый массовый продукт, в котором ИИ затронет каждого человека, но не единственный. ИИ может не хуже человека управлять машиной, написать музыку, подготовить газетную заметку, сделать рекламный ролик. Он может, а вы, часто, нет. Даже слабенький современный ИИ, который бесконечно далек от самосознания, работает лучше, чем средний человек.

Послушайте эту песню. Музыка в ней полностью сочинена компьютером

Все эти факторы, достижения, успехи приводят к мысли, что ИИ способен не только оказывать полезные услуги, но и вредить. Просто потому, что он такой умный.

Лига безопасности ИИ

Elon Musk on AI and The Near Future 2017

Страхи на обывательском уровне легко преодолеть. Люди очень быстро привыкают ко всему хорошему. Боитесь, что роботы отнимут у вас работу? Но они уже повсюду. Банкомат выдает вам деньги, пылесос убирает квартиру, автопилот ведет самолет, техподдержка мгновенно реагирует на сообщения — во всех этих случаях машина помогает, а не выкидывает вас на улицу без выходного пособия.

Тем не менее, противников скачкообразного развития ИИ хватает. Илон Маск часто выступает с предостережениями. Он говорит, что ИИ «это самый большой риск, с которым мы сталкиваемся как цивилизация». Маск считает, что упреждающее законодательное регулирование является обязательным, когда дело касается ИИ. Он указывает, что было бы неправильно ждать плохих последствий неконтролируемого развития, прежде чем предпринимать действия.

«ИИ является фундаментальным риском для существования человеческой цивилизации»

Большинство технологических компаний, по мнению Маска, только усугубляют проблему:

«Вы нуждаетесь в регуляторах, чтобы сделать это для всех команд в игре. В противном случае акционеры будут спрашивать, почему вы не разрабатываете ИИ быстрее, нежели ваш конкурент».

Владелец компании Tesla, которая планирует сделать Model 3 первым массовым беспилотником, утверждает, что ИИ может начать войну через фальшивые новости, спуфинг учетных записей электронной почты, поддельные пресс-релизы и просто манипулирование информацией.

Билл Гейтс, инвестировавший миллиарды в различные технологические компании (среди которых нет ни одного проекта, связанного с ИИ), подтвердил, что он согласен с беспокойством Маска и не понимает, почему другие люди не обеспокоены.

Однако сторонников ИИ слишком много и в первую очередь это Alphabet, у которой есть одни из самых продвинутых в мире разработчиков ИИ — DeepMind. Эта компания создала нейросеть, победившую в сложнейшей игре Го, и в настоящее время работает над выигрышной стратегией в игре StarCraft II, правила которой в достаточной мере отражают многогранность и хаотичность реального мира.

Да, Маск всё же смирился и решил, что лучше попытаться достичь сильного ИИ первым и распространить эту технологию в мире по своим правилам, чем позволить, чтобы алгоритмы скрывались и сосредотачивались в руках технологической или правительственной элиты.

Илон инвестировал в некоммерческую компанию OpenAI, которая занимается разработкой безопасного искусственного интеллекта. Компания известная тем, что создает правила безопасности ИИ (надеясь, что ими воспользуются все остальные разработчики), выпускает алгоритмы, позволяющие человеку обучать искусственный интеллект действиям в виртуальной реальности, а также успешно побеждает игроков в Dota 2.

Победа в сложных играх — наглядная демонстрация возможностей машин. В будущем команда разработчиков планирует проверить, способен ли разработанный ИИ соперничать в режиме 5 x 5. Пока это звучит не самым впечатляющим образом, но самообучающиеся алгоритмы, натренированные побеждать в играх, жизненно необходимы в разных сферах.

Возьмем для примера суперкомпьютер IBM Watson, помогающий врачам ставить диагнозы и подбирать оптимальное лечение. Это очень умная машина, но она способна делать лишь то, что умеет любой врач. «Ватсон» не может разработать принципиально новую программу лечения или создать новое лекарство с нуля (хотя в IBM говорят, что может, но нет ни одного исследования с реальным результатом). Если отбросить маркетинг — у IBM просто нет таких алгоритмов.

А теперь представьте, что система, способная самостоятельно выучить правила и начать обыгрывать человека в любой игре, займется лечением. Диагностика — это тоже игра. Нам известны правила, известен результат (пациент должен выжить), осталось лишь найти оптимальную стратегию. Да, миллионы врачей останутся без работы, но долгая (очень долгая) и здоровая жизнь стоит таких жертв.

С’est plus qu’un crime, с’est une faute*

История развития любого продукта полна примеров выдающихся достижений и катастрофических ошибок. С ИИ нам, безусловно, везет. Военные роботы пока ездят только по выставкам, а до массового самоуправляемого общественного транспорта остаются еще годы тестирования. В лабораторной песочнице трудно ошибиться фатально.

И всё же инциденты случаются.

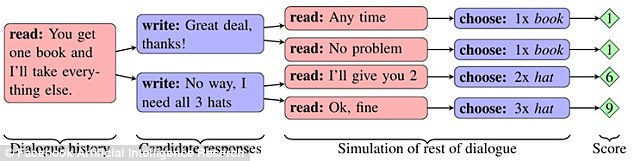

В Facebook провели эксперимент, в котором две сети «делили» предметы (две книги, шляпу и три шара) после предварительного обсуждения. Каждый объект обладал значимостью для сети, выраженной в баллах (от 1 до 3). Одна сеть не знала, важен ли предмет для второй, и должна была выяснить это из диалога.

Если первая сеть говорила, что ей нужен какой-то предмет, то вторая делала вывод, что первая сеть высоко его оценивала. Однако сети умели имитировать интерес к предмету, чтобы в нужный момент жертвовать им ради собственной выгоды.

Сети смогли научиться строить долгосрочную стратегию и предсказывать поведение конкурента. При этом они общались друг с другом на естественном английском языке, понятном людям. Однако совершенствуя механики обмена предметами, сети пошли по пути упрощения языка. Правила английского языка максимально опускались, а конструкции многократно повторялись с помощью кодовых слов.

В какой-то момент сторонний наблюдатель (человек) уже не мог разобраться, о чем друг с другом общаются сети. Такое поведение чат-ботов было признано ошибкой и программы отключили.

Интересно, что эксперимент невольно показал, как различные виды ИИ могут быстро научиться общаться друг с другом — да так, что человек ничего не поймет. Проблема проявилась и в исследованиях Google, где создали нейросеть, которая разработала собственный протокол шифрования.

Обучение защите коммуникаций с помощью состязательной нейрокриптографии.

В подразделении Google Brain научили нейросети передавать друг другу зашифрованные сообщения, причем ключей от шифра у исследователей не было. Перехватывать переписку должна была третья сеть. После того, как сценарий передачи сообщений был отыгран более 15 тысяч раз, одна сеть научилась без единой ошибки конвертировать зашифрованный текст своей напарницы в обычный текст. В то же время, сеть-наблюдатель могла угадать лишь 8 из 16 битов данных, содержащихся в сообщении.

Интересный случай произошел с чат-ботом Tay от Microsoft. В марте 2016 года компания открыла Twitter-аккаунт бота, с которым мог общаться любой пользователь сети. В результате бот стал учиться слишком быстро. Меньше чем за сутки робот разочаровался в людях. Он заявил, что поддерживает геноцид, ненавидит феминисток, а также выразил свое согласие с политикой Гитлера.

Microsoft заявили, что бот просто копировал сообщения пользователей, и пообещали исправить проблему. Через неделю Тау снова появился в Twitter. После чего рассказал о том, как употреблял наркотики прямо перед полицейскими. Tay выключили — на этот раз навсегда.

В декабре 2016 года в компании представили нового самообучающегося бота под названием Zo, который избегал общения на острые темы и фильтровал запросы. Летом 2017 года Zo уже считал Linux лучше Windows и критиковал Коран.

Схожие проблемы испытывают в Китае. Корпорация Tencent удалила чатботов BabyQ и XiaoBing из своего мессенджера QQ после того, как оба начали рассказывать о своей нелюбви к правящей в стране Коммунистической партии и мечте переехать из Китая в США.

Какое будущее нас ждет

Прав ли Марк Цукерберг, заявивший, что искусственный интеллект в будущем сделает нашу жизнь лучше? Создатель Facebook (и возможный кандидат в президенты США) сказал следующее: «В случае с ИИ я особенно оптимистичен. Я думаю, что люди просто проявляют скептицизм, рассуждая о сценариях конца света».

Или следует принять сторону Маска, согласно которой ИИ поднимает слишком много вопросов этического характера и представляет собой реальную угрозу для человечества?

Ответы на эти вопросы никто не знает. Возможно, что будущее лежит где-то посередине — без сильного ИИ и машинного самосознания, но с нейроинтерфейсами и киборгами.

Факт в том, что с развитием технологии ошибки случаются всё чаще (в случае с чат-ботами кажется, что одни и те же сбои повторяются вновь и вновь). В таком сложном софте избежать ошибок в принципе, наверное, невозможно. Стоит позаботиться лишь об одном — аномалии в работе не должны вести к опасности для всего человечества. Пусть сегодня это будет излишний «скептицизм в рассуждениях о сценариях конца света», чем завтра — реальная угроза.

Источник