Предприниматель Илон Маск, возглавляющий многие известные технологические компании, известен своей точкой зрения об опасности искусственного интеллекта. Конечно, он знаменит далеко не только благодаря этому мнению. Тем не менее, он выступает против создания сильной формы ИИ с 2014-го года. Тогда он в первый раз публично заявил о том, что искусственный разум может быть опасен. С ним согласен Стивен Хокинг и многие другие ученые, футурологи, специалисты по ИТ. Есть мнение о том, что все человечество может пасть жертвой технологической сингулярности.

Самой опасной, по мнению Маска, является тенденция создания автономного «умного» оружия. По словам предпринимателя, риск появления «роботов-убийц» очень высок, так что необходимо отнестись к этому вопросу со всем возможным тщанием. «Третья революция в вооружениях» уже близка, убеждены специалисты, а автономные «роботы-убийцы» — это своеобразный ящик Пандоры. Времени для решения проблемы остается очень мало.

Примерно неделю назад Маск вместе с 115 видными специалистами, представляющих различные сферы науки и техники подписал открытое письмо, авторы которого просят ООН заняться указанной проблему, причем как можно быстрее.

Письмо было подписано на мероприятии International Joint Conference on Artificial Intelligence (IJCAI 2017), которое проходило в Мельбурне. Кстати, в числе подписавшихся — и основатель DeepMind Мустафа Сулейман, а также Джером Монсе, глава компании Aldebaran Robotics, разработавшей робота Pepper. Если уж руководители компаний, стоящих во главе технологического прогресса, подписывают это письмо, то наверное, над проблемой действительно стоит задуматься.

В письме, в частности, говорится о том, что ИИ и робототехника развиваются такими быстрыми темпами, что возможность ведения войны при помощи автономного оружия, включая роботов, становится все более вероятной. Причем это вопрос ближайших лет, а вовсе не десятилетий, как считалось ранее. Так что уже сейчас необходимо задуматься над тем, каким образом технологии могут повлиять на судьбу человечества. И думать об этом должны, в первую очередь, руководители государств, где технологии развиваются максимально активно.

Сюда можно еще добавить угрозу попадания технологий такого рода в руки террористов и автократов, которые без всяких угрызений совести будут направлять смертоносные инструменты против обычных людей. Даже, если этого удастся избежать, остается еще угроза взлома систем, причем вовсе ненулевая. Хакеры неоднократно доказывали то, что взломать можно практически все, как бы хорошо это «все» ни было бы защищено.

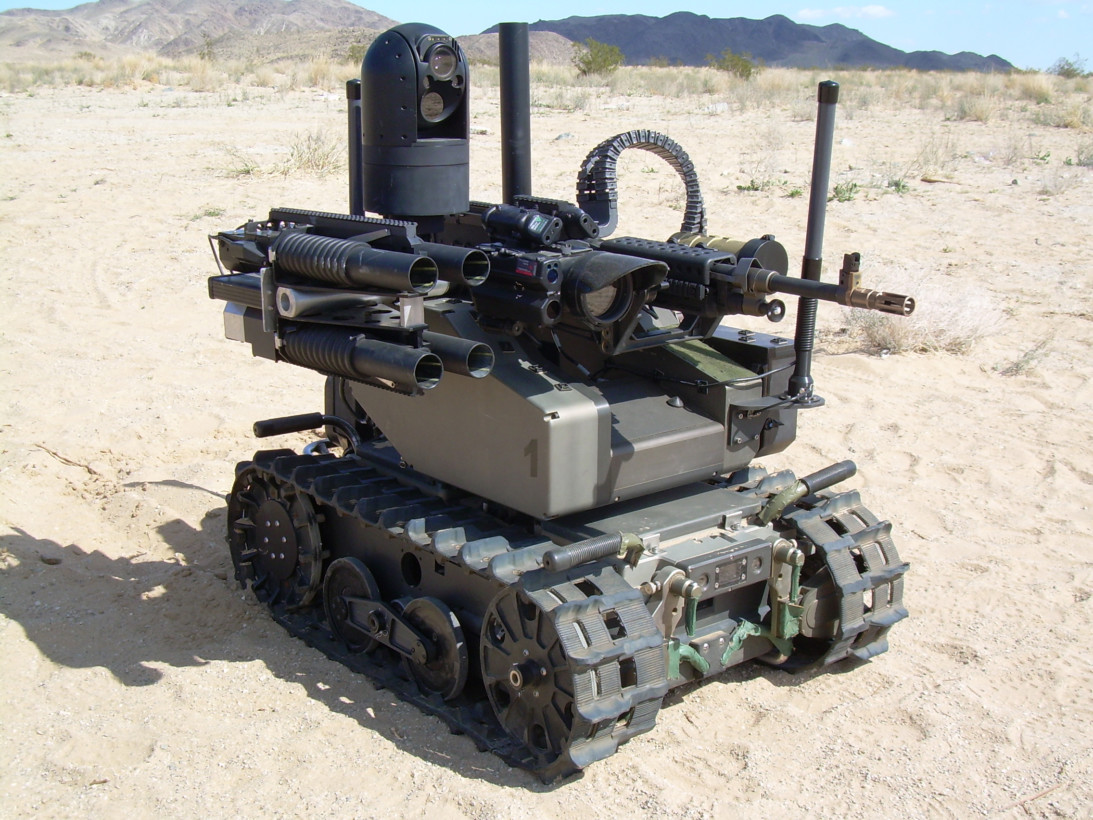

Уже сейчас существуют разработки смертоносного оружия, работающего в автономном или полуавтономном режиме. В числе прочих это вот такой аппарат.

Фото приведено просто для демонстрации того, каким оружием могут быть оснащены роботы на войнах будущего. А ведь уже сейчас в небе летают дроны, способные работать в автоматическом режиме. А корабли оснащаются автоматическими пушками, которые самостоятельно отслеживают возможную угрозу.

Правительства различных стран не согласны с точкой зрения ученых и технологов по разным причинам. Основная — для государств автономное вооружение — это выгодно. Оно способно увеличить эффективность защиты границ или снизить число смертей солдат в случае возникновения локальных или региональных конфликтов. Так, в 2015 году правительство Великобритании выступило против запрещения автономного летального оружия. Более того, разработки вооружения такого типа ведутся здесь очень активно.

Ну а точка зрения ученых, выступающих против автономных «роботов-убийц» хорошо иллюстрируется заявлением основателя Element AI Йошуа Бенджио: «Я подписал открытое письмо, поскольку использование ИИ в автономных системах вооружения противоречит моему пониманию этики, все это может привести к очень опасной эскалации, затронуть всю сферу разработки ИИ. Ситуация должна быть взята под контроль международным сообщества, подобно тому, как это сделано с другими типами вооружений (биологического, химического, ядерного)».

«Создание смертоносного автономного оружия позволяет увеличить масштабы войн до небывалых масштабов, которые даже сложно представить», — говорится в письме. И, вероятно, авторы письма действительно правы.

Источник