Искусственный интеллект – очередное средство производства или новый этап развития цивилизации? Помощник человека или угроза человечеству? Мы одни во Вселенной или просто не способны воспринять иные формы сознания? Об этом в своей новой статье рассуждает доктор философии Михаил Опенков.

ChatGPT вызывал энтузиазм и страх с момента своего запуска в ноябре 2022 года. Его очевидное владение семантикой и синтаксисом – но еще не содержанием – разных языков поражает пользователей, ожидающих столкнуться с обычным чат-ботом. Некоторые университеты немедленно запретили студентам использовать ChatGPT для написания эссе, поскольку он превосходит большинство студентов-людей. Газетные статьи объявили о ChatGPT: чат-бот с искусственным интеллектом, разработанный компанией OpenAI и способный работать в диалоговом режиме, поддерживающий запросы на естественных языках. ChatGPT – большая языковая модель, для тренировки которой использовались методы обучения с учителем и обучения с подкреплением.

Искусственный интеллект, кажется, завоевал еще одну область, которая, согласно классической философии, определяет человеческую природу: логос. Паника растет с дальнейшей потерей экзистенциальной территории. Апокалиптическое воображение человеческой истории усиливается по мере того, как климатический коллапс и восстание роботов напоминают о конце времен.

В России «триумф» ChatGPT начался с того, что студент Александр Жадан защитил диплом, который написала эта нейросеть. Об этом сам Александр рассказал в Твиттере. Это определило онтологический статус события. Ведь для общества существует только то, что освещено в СМИ или в значимых социальных сетях.

Александр опубликовал подробный отчет, как современная технология помогла ему сэкономить десятки часов личного времени, которые он мог потратить на самостоятельное написание диплома. За диплом Жадан получил оценку «удовлетворительно», по его словам – за поведение в аудитории. Но программа «Антиплагиат» установила степень оригинальности работы в 82%.

Миллениалы возликовали, но на всякий вызов есть и адекватный ответ. Программисты компании «Антиплагиат» разработали новый алгоритм, позволяющий автоматически выявлять и маркировать сгенерированные ChatGPT фрагменты текста. Теперь система в ходе анализа текста выделяет фрагменты, предположительно созданные при использовании моделей глубокого обучения GPT-2, GPT-3 и GPT-4. А GPT-5, вероятнее всего, не будет.

Вот какие особенности работы с чатом выделил сам Александр Жадан: сила ChatGPT немного меркнет в практической части по сравнению с теорией. Нейросеть не может взять актуальные данные после 2021 года, а также экспертно проанализировать компанию. Никакого внутреннего понимания процессов у ИИ нет: в лучшем случае она разберет компанию поверхностно, в худшем – все выдумает. Это значит, что GPT-4 может создавать или выдумывать только гуманитарные тексты.

Дальше – больше: группа челябинских преподавателей философии, вероятно, из эпистемологических соображений, направила в рецензируемый научный журнал статью. Ее приняли и чуть не опубликовали, хотя написали ее не сами ученые, а ChatGPT 3. Тут уже, естественно, напряглись все редколлегии академических журналов.

Если отбросить истерику напуганных Голливудом гуманитариев, то философы сформулировали абсолютно верную позицию: требуется переопределение творческих способностей человека с точки зрения их уникальности и незаменимости. А также целей образования в условиях присутствия ИИ.

Университетская подготовка подразумевает решение стандартных задач. Реферат – это самостоятельное, логичное изложение чужих взглядов по данному вопросу. Курсовая работа уже включает в себя элементы самостоятельной исследовательской деятельности. Выпускная квалификационная работа подразумевает полную самостоятельность в ее выполнении, хотя нередко проблема, поставленная в ней, является частным случаем более общей проблемы, а потому особого интереса для науки не представляет.

В принципе чтение одних только учебников подразумевает низший балл по любой конкретной дисциплине. Исследователь становится таковым, лишь приобщаясь к рафинированным методам исследования, отвечающим уровню мировой науки. Это определяется выбором темы, оригинальностью взгляда.

Российский технологический университет просит Минцифры ввести обязательную маркировку контента, созданного с помощью нейросетей, а также подготовить программу защиты критически важной инфраструктуры от возможных кибератак с использованием таких систем. Об этом сообщается в письме ректора РТУ МИРЭА Станислава Куджа главе Минцифры Максуту Шадаеву. «Очевидно, что без введения дополнительных мер контроля за развитием искусственного интеллекта, нейросети уже в ближайшие несколько лет смогут гораздо эффективнее, чем люди, взламывать защиту компьютерных программ, в том числе в критически важных для экономики сферах».

В США семь компаний, включая Amazon, Anthropic, Meta, Google, Inflection и OpenAI, взяли на себя добровольные, иногда расплывчатые, обязательства по инвестированию в исследования и безопасность, стресс-тестирование безопасности и помощь в проведении сторонних аудитов уязвимости системы. Одним из наиболее важных для потребителей обязательств компаний является новый запрос «Белого дома» о размещении водяных знаков на контенте, созданном искусственным интеллектом. Во время разговора с журналистами представитель Белого дома заявил, что они ожидают, что эти водяные знаки будут применяться к аудио- и визуальному контенту, созданному отдельными пользователями. В целом идея маркировки верна. В цифровой экономике все, сделанное машинами, становится дешевле, но сделанное умом и руками человека – все дороже.

В ответ на быстрое появление новых и мощных генеративных инструментов ИИ, ЮНЕСКО провела первую глобальную встречу министров образования, чтобы изучить непосредственные, а также далеко идущие возможности, проблемы и риски, которые приложения ИИ представляют для систем образования. Более 40 министров собрались вместе, чтобы поделиться политическими подходами и планами в отношении того, как лучше всего интегрировать эти инструменты в образование. В ходе онлайн-дискуссии 25 мая 2023 г. ЮНЕСКО представила дорожную карту по генеративному ИИ и образованию, включая открытый многосторонний диалог. Генеративный ИИ открывает перед образованием новые горизонты и задачи. ЮНЕСКО ставит задачу интегрировать технологию искусственного интеллекта в образование.

Дебаты на уровне министров показали, что правительства во всем мире находятся в процессе формулирования соответствующих политических мер в этой быстро меняющейся среде – дальнейшей разработки или уточнения национальных стратегий в отношении ИИ, защиты данных и других нормативных рамок. Только 10% школ и университетов имеют официальное руководство по ИИ.

Результаты показывают, что немедленная реакция на внезапное появление мощных генеративных приложений ИИ, которые могут создавать письменные и визуальные творения, является сложной задачей для учреждений. Была подчеркнута жизненно важная роль учителей в этой новой эре в качестве фасилитаторов обучения. Но учителям необходимо руководство и подготовка для решения этих проблем.

Возникает первый вопрос: как определить степень интеллектуальности генеративного ИИ?

В 1950 году Алан Тьюринг опубликовал в журнале Mind дерзкую и пророческую статью «Вычислительные машины и интеллект». В статье был сформулирован знаменитый «тест Тьюринга» на разумность машины. Помимо прочего, Тьюринг разбирает аргументы оппонентов, отрицавших возможность «искусственного интеллекта». Самый распространенный аргумент состоял в том, что ни один механизм не может чувствовать радости от своих успехов, горя от неудач, не может быть очарован противоположным полом, не может сердиться или быть удрученным. По мнению Тьюринга, это означает, что единственный способ удостовериться, что машина мыслит, состоит в том, чтобы стать ею, а потом рассказать о своих переживаниях. Естественно, никто этому рассказу не поверит. Если придерживаться идеи абсолютной неповторимости эмоционального опыта, то возникают трудности в удостоверении чужого сознания. Тьюринг подчеркивал, что так можно прийти к солипсизму, чего никто не захочет.

Тест на интеллектуальность состоит в проверке того, позволяет ли использование человеко-машинного диалога произвольного содержания отличить человека от машины. Для Тьюринга игра в имитацию была не столько мысленным экспериментом, сколько реализуемым в будущем средством проверки того, может ли машина мыслить. Тьюринг считал, что рано или поздно машинная имитация человеческого интеллекта станет возможной, и на поставленный им вопрос будет получен положительный ответ (Тьюринг А. Может ли машина мыслить? С приложением статьи Дж. фон Неймана «Общая и логическая теория автоматов». М.: УРСС, ЛЕНАНД, 2016, с.19-22).

Вместо теста Тьюринга исследователи обычно оценивают системы ИИ, используя тесты, предназначенные для оценки производительности по конкретным возможностям, таким как языковые способности, здравый смысл и математические способности. Все чаще команды обращаются к академическим и профессиональным экзаменам, предназначенным для людей.

Когда GPT-4 был выпущен, фирма, стоящая за ним – OpenAI, проверила его производительность на серии тестов, разработанных для машин, включая понимание прочитанного, математику и программирование. GPT-4 превзошел большинство из них, OpenAI сообщила об этом; компания также устроила GPT-4 около 30 экзаменов, в том числе: различные тесты по конкретным предметам, разработанные для учащихся средних школ США, известные как Advanced Placement; экзамен для оценки текущего состояния клинических знаний американских врачей; и стандартный тест, используемый в процессе отбора для обучения в аспирантуре США, называемый GRE. По сообщению OpenAI, на Едином экзамене на адвоката, который является частью квалификационного процесса для юристов во многих штатах США, GPT-4 набрала балл, который позволил бы ему войти в 10% лучших кандидатов.

Исследователи также отмечают, что успехи LLM (Large Language Models) в ответах на экзаменационные вопросы могут быть неустойчивыми и могут не трансформироваться в надежные возможности, необходимые для получения правильных примеров в реальном мире.

Есть более глубокая проблема в интерпретации того, что означают тесты. Для человека высокие баллы по этим экзаменам надежно указывают на общий интеллект – нечеткое понятие, но, согласно одному определению, оно относится к способности хорошо справляться с рядом задач и адаптироваться к различным контекстам. То есть можно предположить, что кто-то, кто хорошо сдал экзамены, хорошо справляется с другими когнитивными тестами и усвоил определенные абстрактные понятия. Но это совсем не относится к LLM, они работают совсем иначе, чем люди. Возможно, это связано с тем, что LLM учатся только на языке.

LLM в настоящее время демонстрируют, что можно очень бегло говорить без подлинного понимания. То есть большие языковые модели демонстрируют вариант «китайской комнаты» Джона Серля. Когда человек, не владеющий китайским языком, по инструкции составляет ответы на этом языке, но не понимает, что он делает.

У LLM также есть возможности, которых нет у людей, например, способность знать связи между почти каждым словом, когда-либо написанным людьми. Это может позволить моделям решать проблемы, полагаясь на особенности языка, не делая более широких обобщений.

Исследователи искусственного интеллекта говорят, что для выявления сильных и слабых сторон LLM необходимы более обширные и строгие проверки. Красочные логические головоломки могут быть одним из кандидатов, с которым современные модели искусственного интеллекта справляется не очень хорошо. ChatGPT и поисковая система Bing правильно решают едва ли треть головоломок в одной категории шаблонов и всего 3% – в другой, согласно отчету исследователей.

Можно сделать вывод, что мыслительные способности LLM в целом «неоднородны» и более ограничены, чем у людей, но они есть и, кажется, улучшаются с увеличением размера модели, что указывает на то, что будущие LLM будут еще лучше.

Неустойчивость в работе больших языковых моделей определяется тем, что они не освоили некоторые особенности абстрактного мышления, присущего человеку. Проверить LLM на способность к абстрактному мышлению и другие признаки интеллекта остается открытой и нерешенной проблемой. С другой стороны, надо избегать проклятия антропоморфизма в том, что мы называем интеллектом. Мы антропоморфизируем все, что демонстрирует интеллект.

Гонконгский философ Юк Хуэй, профессор философии технологий и медиа в Городском университете Гонконга, отмечает, что «интеллект», присутствующий сегодня в машинах, является рефлективной формой работы. Рефлексивное мышление в машинах обладает поразительной властью над людьми, не готовыми принять его существование, даже в качестве предварительной и основной формы рефлексии, будучи чисто формальной и потому недостаточной для работы с содержанием. Рекурсивные, а не линейные машины являются ключом к пониманию развития и эволюции искусственного интеллекта. Возникает вопрос: когда технология станет рефлексивной, какова будет роль философии? Этот вопрос был сформулирован создателем оригинальной философии техники Жильбером Симондоном.

В эпоху информационных машин (или кибернетических машин), машина сама становится организатором информации, а человек уже не находится в центре, даже если он все еще считает себя командиром машин и организатором информации. Это тот момент, когда человек страдает от собственных стереотипных представлений о машинах: он ложно идентифицирует себя как центр и при этом сталкивается с постоянным разочарованием и паническим поиском идентичности.

Реальность, обитающая в машине, отчуждена от реальности, в которой действует человек. Неизбежный процесс технологической эволюции обусловлен введением нелинейной причинно-следственной связи, позволяющей машинам справляться с непредвиденными обстоятельствами. Обучающаяся машина – это та, которая может различать случайные события, такие как шум и сбой. Она может отличать неорганизованные входы от необходимых. И, интерпретируя случайные события, обучающаяся машина совершенствует свою модель принятия решений. Но даже здесь машине нужны люди, чтобы отличать правильные решения от неправильных, чтобы продолжать совершенствоваться.

Вопрос о том, что будет с человеком, когда он перестанет быть организатором информации, остается нерешенным. Он был затемнен технологическим оптимизмом, а также культурным пессимизмом, причем первый способствует неустанному ускорению, а второй служит психотерапией. Обе эти тенденции проистекают из антропоморфного понимания машин, согласно которому они должны имитировать людей. С одной стороны, запаниковавший человек постоянно спрашивает, какие рабочие места смогут избежать замены машинами; с другой, технологическая индустрия сознательно работает над тем, чтобы заменить человеческое вмешательство машинной автоматизацией. Люди живут в рамках самосбывающегося пророчества индустрии о замещении.

Вместо разработки видения будущего, в котором искусственный интеллект выполняет функцию протеза, господствующий дискурс рассматривает его просто как вызов человеческому интеллекту и замену интеллектуального труда. Современные люди не умеют мечтать. Если мечта о полете привела к изобретению самолета, то теперь у нас есть усиливающиеся кошмары о машинах.

Протезная природа техники должна быть подтверждена помимо ее функциональности, ибо с самого начала человечества доступ к истине всегда зависел от изобретения и использования инструментов. Этот факт остается невидимым для многих, из-за чего конфликт между машинной эволюцией и человеческим существованием кажется проистекающим из идеологии, глубоко укоренившейся в культуре.

С самого начала современного индустриального общества человеческое тело подчинялось повторяющимся ритмам, и, следовательно, человеческий разум подчинялся пророчествам промышленности. Будь то американская мечта или китайская мечта, огромный человеческий потенциал был подавлен в пользу потребительской идеологии. В прошлом перед философией стояла задача ограничить высокомерие, производимое машинами, и освободить людей от петель обратной связи во имя истины. Вместо этого сегодня философы технологии стремятся утвердить эти петли обратной связи как неизбежный путь цивилизации. Теперь человек признает центральную роль технологии, желая решать все проблемы так, как если бы они были техническими проблемами. Скорость и эффективность управляют всем обществом, как когда-то они управляли только инженерными дисциплинами.

Желание педагогов осуществить парадигматические изменения за несколько лет дискредитирует любые фундаментальные размышления о технологии, и мы снова попадаем в петлю обратной связи. Следовательно, университеты продолжают выпускать таланты для технологической индустрии, и эти таланты продолжают разрабатывать более эффективные алгоритмы для использования конфиденциальности пользователей и управления тем, как они потребляют. Для университетов должно быть важнее решить эти вопросы, чем раздумывать о запрете ChatGPT.

Вместо того, чтобы приостанавливать развитие ИИ, приостановить антропоморфное стереотипирование машин и развивать адекватную культуру протезирования. Технологии следует использовать для реализации потенциала их пользователей.

Вместо того чтобы мистифицировать машины и человечество, надо понять нашу текущую техническую реальность и ее связь с разнообразными человеческими реальностями, чтобы эту техническую реальность можно было интегрировать с ними для поддержания и воспроизводства биоразнообразия, нооразнообразия и техноразнообразия.

Вместо того чтобы повторять апокалиптический взгляд на историю (взгляд, выраженный в его наиболее гегелевской форме о конце истории Кожева и Фукуямы), освободить разум от его рокового пути к апокалиптическому концу. Это освобождение откроет поле, которое позволит нам экспериментировать с этическими способами жизни с машинами и другими нечеловеческими существами.

Ноам Хомский в своем эссе для «Нью Йорк Таймс» занимает более сдержанную позицию. ChatGPT от OpenAI, Bard от Google и Sydney от Microsoft – чудеса машинного обучения. Они берут огромные объемы данных, ищут в них закономерности и становятся все более опытными в генерации статистически вероятных результатов, таких как, казалось бы, человекоподобный язык и мышление. Эти программы были провозглашены первыми проблесками на горизонте искусственного всеобщего интеллекта – давно предсказанного момента, когда механические умы превзойдут человеческий мозг не только количественно с точки зрения скорости обработки и объема памяти, но и качественно с точки зрения интеллектуального понимания, художественного творчества и любой другой отличительной человеческой способности.

Этот день может наступить, но его рассвет еще не забрезжил, вопреки тому, что можно прочитать в преувеличенных заголовках и подсчитать по неразумным инвестициям. Человеческий разум, в отличие от ChatGPT и ему подобных, не является неуклюжим статистическим механизмом для сопоставления с образцом, поглощающим сотни терабайт данных и экстраполирующим наиболее вероятный разговорный ответ или наиболее вероятный ответ на научный вопрос. Наоборот, человеческий разум – удивительно эффективная и даже элегантная система, оперирующая небольшими объемами информации; он стремится не выводить грубые корреляции между точками данных, а создавать объяснения.

Например, маленький ребенок, осваивающий язык, развивает – бессознательно, автоматически и быстро из мельчайших данных – грамматику, чрезвычайно сложную систему логических принципов и параметров. Эту грамматику можно понимать как выражение врожденной, генетически установленной «операционной системы», которая наделяет людей способностью генерировать сложные предложения и длинные цепочки мыслей. Операционная система ребенка полностью отличается от системы машинного обучения.

Действительно, такие программы застряли в дочеловеческой или нечеловеческой фазе когнитивной эволюции. Глубочайшим их недостатком является отсутствие критической способности всякого интеллекта: сказать не только, что есть, что было и что будет (описание и предсказание), но и то, чего нет и что могло бы быть, и быть не может. Это составляющие объяснения, признак истинного разума.

Вот пример: предположим, вы держите яблоко в руке. Теперь вы отпускаете яблоко. Вы наблюдаете результат и говорите: Яблоко падает. Это описание. Предсказанием могло быть утверждение: Яблоко упадет, если я раскрою ладонь. Оба ценны, и оба могут быть правильными. Но объяснение – это нечто большее: оно включает в себя не только описания и предсказания, но и контрфактические предположения вроде: Любой такой объект упадет, плюс дополнительный пункт: «из-за силы гравитации» или «из-за искривления пространства-времени», или что-то еще. Здесь причинное объяснение: Яблоко не упало бы, если бы не сила тяжести. Это мышление.

Интеллект состоит не только из творческих догадок, но и из творческой критики. Мышление в человеческом стиле основано на возможных объяснениях и исправлении ошибок – процессе, который постепенно ограничивает возможности, которые можно рационально рассмотреть. (Как сказал Шерлок Холмс доктору Ватсону: «Когда вы устраните невозможное, все, что останется, каким бы невероятным оно ни было, должно быть правдой».)

ChatGPT и подобные программы не способны отличить возможное от невозможного. В то время как люди ограничены в видах объяснений, которые мы можем рационально предположить, системы машинного обучения могут узнать как о том, что Земля плоская, так и о том, что Земля круглая. Они торгуют просто вероятностями, которые меняются со временем.

По этой причине предсказания систем машинного обучения всегда будут поверхностными и сомнительными. Некоторые энтузиасты машинного обучения, гордятся тем, что их творения могут генерировать правильные «научные» предсказания (скажем, о движении физических тел) без использования объяснений (включая, скажем, законы движения Ньютона и всемирного тяготения). Но такого рода предсказания, даже если они успешны, являются лженаукой. Хотя ученые, безусловно, ищут теории, имеющие высокую степень эмпирического подтверждения, как заметил Карл Поппер: мы ищем не очень вероятные теории, а объяснения; то есть мощные и крайне невероятные теории.

Истинный интеллект также способен к моральному мышлению. Это означает ограничить безграничную креативность нашего разума набором этических принципов, определяющих, что должно и чего не должно быть.

GPT-4 и Bard – не единственные программы с такими расширенными возможностями. Meta выпустила программу под названием ImageBind, которая обрабатывает текст, изображения, звук, информацию о глубине, инфракрасном излучении и информацию о движении и положении. Недавний PaLM-E от Google был обучен как языку, так и сенсорным данным робота, и компания выдвинула новую, более мощную модель, которая выходит за рамки текста. У Microsoft есть собственная модель, которая обучалась на словах и изображениях. Генераторы преобразования текста в изображение, такие как DALL-E 2, покоривший Интернет прошлым летом, обучаются на изображениях с подписями.

Они известны как мультимодальные модели: текст – это одна модальность, изображения – другая, и многие исследователи надеются, что они выведут ИИ на новый уровень. Величайшее будущее – это то, в котором ИИ не ограничивается написанием шаблонных эссе и помощью людям; он сможет искать в Интернете, не придумывая ничего, анимировать видео, направлять робота или создавать веб-сайт самостоятельно.

Стремление к мультимодальным моделям не является чем-то новым; техногиганты представили автоматизированные системы субтитров почти десять лет назад. Но несколько ключевых изменений в исследованиях ИИ сделали междисциплинарные подходы более возможными и многообещающими. Если на протяжении десятилетий такие области компьютерных наук, как обработка естественного языка, компьютерное зрение и робототехника, использовали совершенно разные методы, то теперь все они используют метод программирования, называемый «глубоким обучением». В результате их код и подходы стали более похожими, а их модели легче интегрировать друг в друга.

Насколько лучше мультимодальный ИИ будет понимать мир, чем ChatGPT, и насколько более беглым будет его язык, если вообще будет, является предметом споров. Исследователи по-прежнему далеки от всего, что могло бы действительно подражать человеческому мышлению.

Добавление большего количества текстовых данных в модели ИИ не решило давние проблемы с предвзятостью и фальсификацией, добавление большего количества типов данных в машины также не обязательно решит эту проблему.

Переход на мультимодальные модели может быть похож на поиск Эльдорадо. Такие программы просто предложат клиентам больше, чем обычный текстовый ChatGPT, например, описание изображений и видео, интерпретацию или даже создание диаграмм, они станут более полезными личными помощниками и так далее. Мультимодальный ИИ может помочь консультантам и венчурным капиталистам сделать более качественные слайды, улучшить существующее, но несовершенное программное обеспечение, описывающее изображения и окружающую среду для слабовидящих людей, ускорить обработку обременительных электронных медицинских карт и вести нас по улицам не как карта, а по маршруту, наблюдая за зданиями вокруг нас.

Приложения к робототехнике, беспилотным автомобилям, медицине и многому другому легко придумать, даже если они никогда не материализуются – как золотой город, который, даже если он окажется мифическим, все равно оправдывает завоевание. Мультимодальность не требует создания явно более интеллектуальных машин, чтобы закрепиться. Просто нужно сделать их более явно прибыльными.

Таким образом, несмотря на поднятый шум, мы остаемся в области слабого ИИ, который кое-как имитирует некоторые человеческие способности. В 80-ые годы прошлого века казалось, что стоит обучить ИИ естественному языку, то есть сообщить ему некоторую культуру, и мы быстро получим сильный ИИ. Оказалось, что это не так.

Первый подступ к ИИ, то есть экспертные системы, привлек внимание философов к неявному знанию. Неожиданно актуальной стала книга Майкла Полани «Личностное знание». Майкл Полани осуществил исследование так называемого неявного знания, т.е. знания, не представленного в словесной форме. Различие между «явной» и «неявной» формами знания – это различие между тем, что может быть сказано, и тем, что может быть показано. Неявное знание профессионала Полани назвал «неизреченным интеллектом». Позднее в когнитивной науке был сформулирован основной парадокс личностного профессионального знания: чем более компетентными становятся эксперты, тем менее они способны описать знания, используемые ими для решения задач.

Отсюда и возник вопрос, сформулированный Хьюбертом Дрейфусом: Чего не могут вычислительные машины? Время идет, а академическое философствование не меняется. У ИИ нет неявного знания или нет квалиа, значит он не может быть интеллектуальным. Вопрос: зачем ему все это?

Из-за особенностей эволюционного развития на планете Земля человек стал единственным разумным существом на планете. Это создает у него ложное мнение о том, что его форма сознания – единственно возможная.

Форма сознания, свойственная человеку, лишь один из многих видов интеллекта и сознания, которые возможны во Вселенной. Человеческий интеллект традиционно называют универсальным, так как по сравнению с другими типами мышления, которые нам известны, он способен решать больше разноплановых задач. По мере того, как мы создаем все больше типов ИИ, мы придем к осознанию, что процесс человеческого мышления не универсален. Это лишь один из способов.

Неантропоморфный интеллект – это не ошибка, а отличительная особенность. Самое важное, что следует знать о думающих машинах, – это то, что они будут думать иначе.

Чтобы найти ключ к решению самых сложных загадок современности – квантовой гравитации, темной энергии и темной материи, возможно, нам потребуется другой тип интеллекта, помимо человеческого. Фактически возможно, нам нужно будет изобрести промежуточный интеллект, который поможет в формировании более сложного разума, создать который самостоятельно человек не может (эти вопросы более полувека назад ставил Станислав Лем в «Формуле Лимфатера»). Нам нужны способы мыслить иначе.

Мы живем внутри постоянно зарождающейся гигантской кибернетической системы, и в этом заключается наше современное условие философствования. Так считает гонконгский философ Юк Хуэй. Важной особенностью интеллекта является способность решать в широком масштабе новые, нетрадиционные задачи (Хуэй Ю. Рекурсивность и контингентность. М.: V-A-C Press, 2020, с. 46).

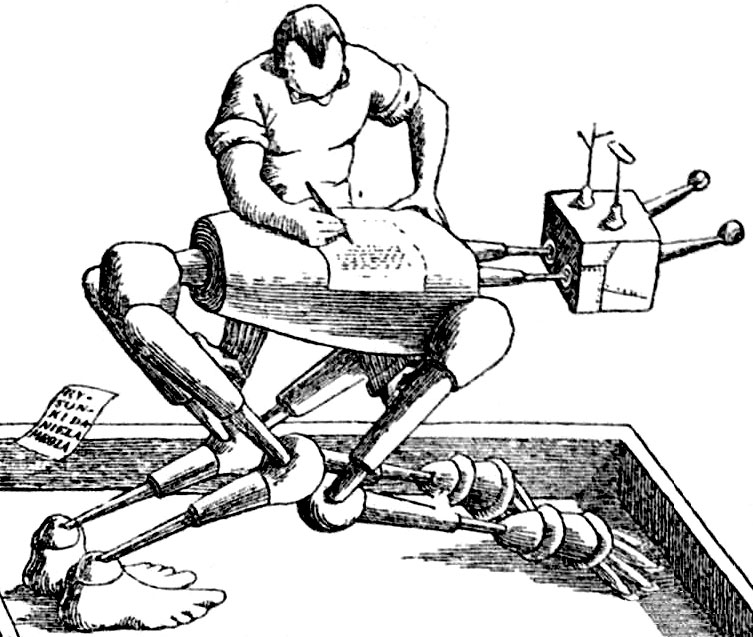

Человек всегда опирался на технику как на костыли. Но традиционная техника увеличивала физическую или энергетическую мощь человека. Впервые в истории человек получил возможность не только создать интеллектуальные костыли, но, может быть, сотворить более могущественное существо, чем он сам. Человеку нужен Иной, в которого он мог бы смотреться, как в зеркало. Искусственный Интеллект — средство самопознания человека, каковы бы ни были его эволюционные перспективы. Это брошенный человечеству вызов, который, может быть, позволит решить «трудную проблему сознания». Философия искусственного интеллекта – это общая ксенология, то есть наука об ином и даже чуждом человеческому сознании.

Это очень важный философский опыт, который показывает эквивалентность двух проблем: искусственного разума и внеземных цивилизаций. Почему космос молчит? Возможно, мы не видим других цивилизаций, потому что они отличаются от нашей. Мы под гнетом антропоморфизма. Чего мы добиваемся, создавая ИИ? Создать копию самих себя или что-то иное?

Об авторе: Опенков Михаил Юрьевич, доктор философских наук, профессор кафедры философии и социологии Северного (Арктического) федерального университета им. М.В. Ломоносова, член Экспертного совета ОД «Информация для всех», автор ряда работ по философии постиндустриального общества, включая книгу «Хакни будущее: введение в философию общества знаний. Курс лекций для студентов философских факультетов».