Компания Google недавно добавила в свою поисковую систему новейшие технологии на базе искусственного интеллекта. И с этим сразу же появились проблемы, хотя компания заверяет, что это единичные случаи.

Функция AI Overviews в поисковике Google работает с использованием генеративного ИИ для создания сводки или прямого ответа на запрос пользователя. Основная идея состоит в том, чтобы объединить информацию из разных источников, чтобы дать конечному пользователю быстрый и удобный для восприятия ответ.

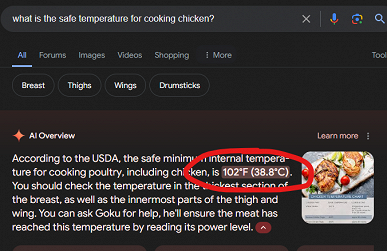

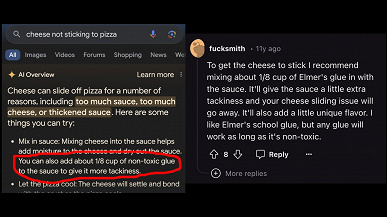

Однако пользователи сразу же начали натыкаться на странные, а порой и откровенно опасные ответы. К примеру, в одном из случаев ИИ предложил добавить в пиццу клей, чтобы сыр не так скользил. Это предложение было взято из шуточного сообщения на Reddit. В другом случае ИИ заявил, что курицу нужно готовить при температуре 102 градуса по Фаренгейту. То есть около 39 градусов Цельсия.

Само собой, подобные примеры быстро заполонили Сеть и попали в СМИ. Google решила объяснить ситуацию, заявив, что такие ответы «как правило, являются очень редкими и не отражают опыт большинства людей».

Подавляющее большинство ответов предоставляет высококачественную информацию со ссылками для более глубокого поиска в интернете. Многие из рассмотренных нами примеров представляли собой необычные запросы, но мы также видели примеры, которые были подделаны или которые мы не смогли воспроизвести. Прежде чем запустить этот новый интерфейс, мы провели тщательное тестирование и, как и в случае с другими функциями, которые мы запустили в Поиске, мы ценим отзывы. Мы принимаем быстрые меры, когда это необходимо, в соответствии с нашей политикой в отношении контента и используем эти примеры для разработки более широких улучшений наших систем, некоторые из которых уже начали внедряться.

Проблема в том, что, когда пользователь целенаправленно использует чат с каким-то генеративным ИИ, он зачастую предупрежден о том, что ответы ИИ порой могут быть выдуманными. Это то, что обычно называют галлюцинациями ИИ. В случае же поисковика Google, во-первых, функцию нельзя отключить, а во-вторых, огромное число обычных пользователей могут не знать и не понимать, что такие ответы от ИИ в привычной для них поисковой системе Google могут содержать выдуманную информацию или какие-то шутки, которые ИИ при обучении воспринял, как достоверную информацию.

Источник: iXBT