Редакция Оксфордского словаря выбрала слово «постправда» (post-truth) почетным «словом 2016 года». Термин этот описывает обстоятельства, в которых объективные факты менее важны для формирования общественного мнения, чем обращение к эмоциям и личным убеждениям.

Особенно высокая частота использования этого слова наблюдалась в англоязычных публикациях после президентских выборов в США в связи с распространением большого количества фейковых новостей, после которых сама истина большого значения не имела.

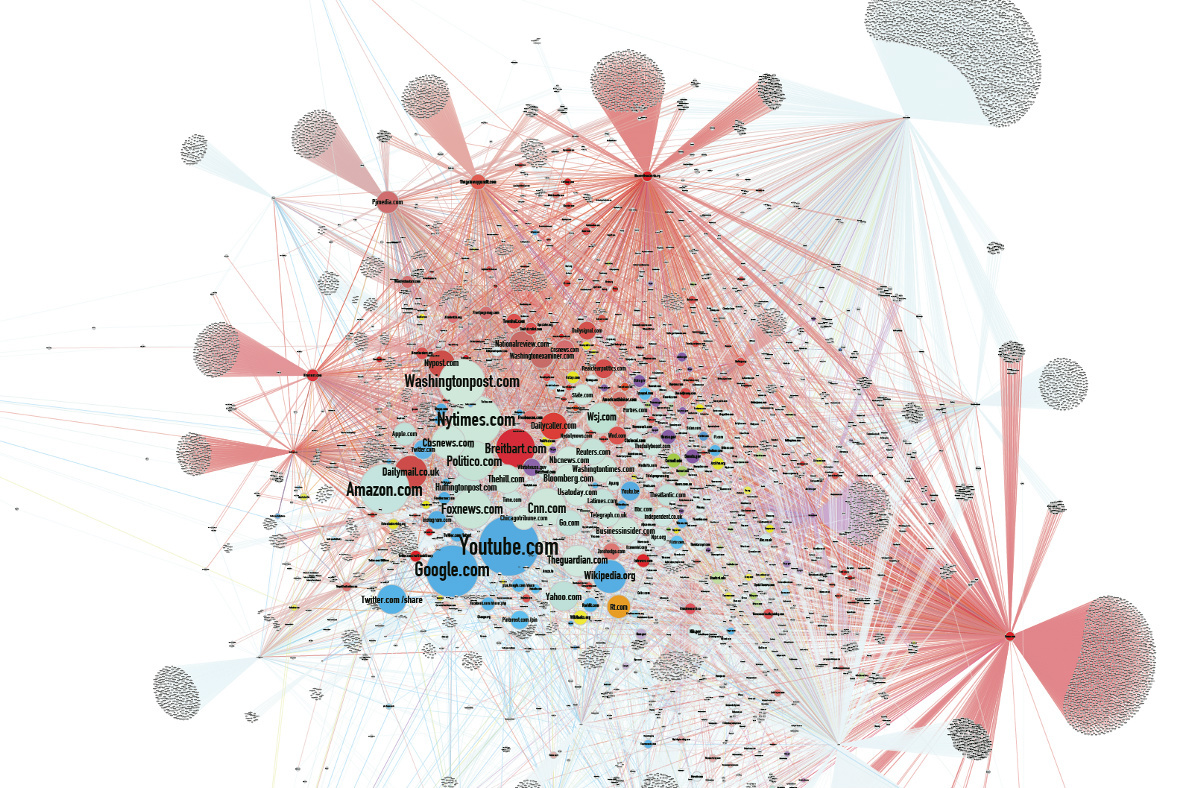

По мнению ряда аналитиков, распространение фальшивых дискредитирующих новостей стало одной из причин поражения Хилари Клинтон на выборах. Одним из главных источников ложных новостей стала алгоритмическая лента Facebook.

На этом фоне почти незамеченными остались новости, поступающие от разработчиков в сфере искусственного интеллекта. Мы уже привыкли, что нейросети рисуют картины, создают фото человека по его словесному описанию, генерируют музыку. Они делают всё больше, и с каждым разом у них получается всё лучше. Но самое интересное в том, что машины научились создавать фейки.

Влияние фейков

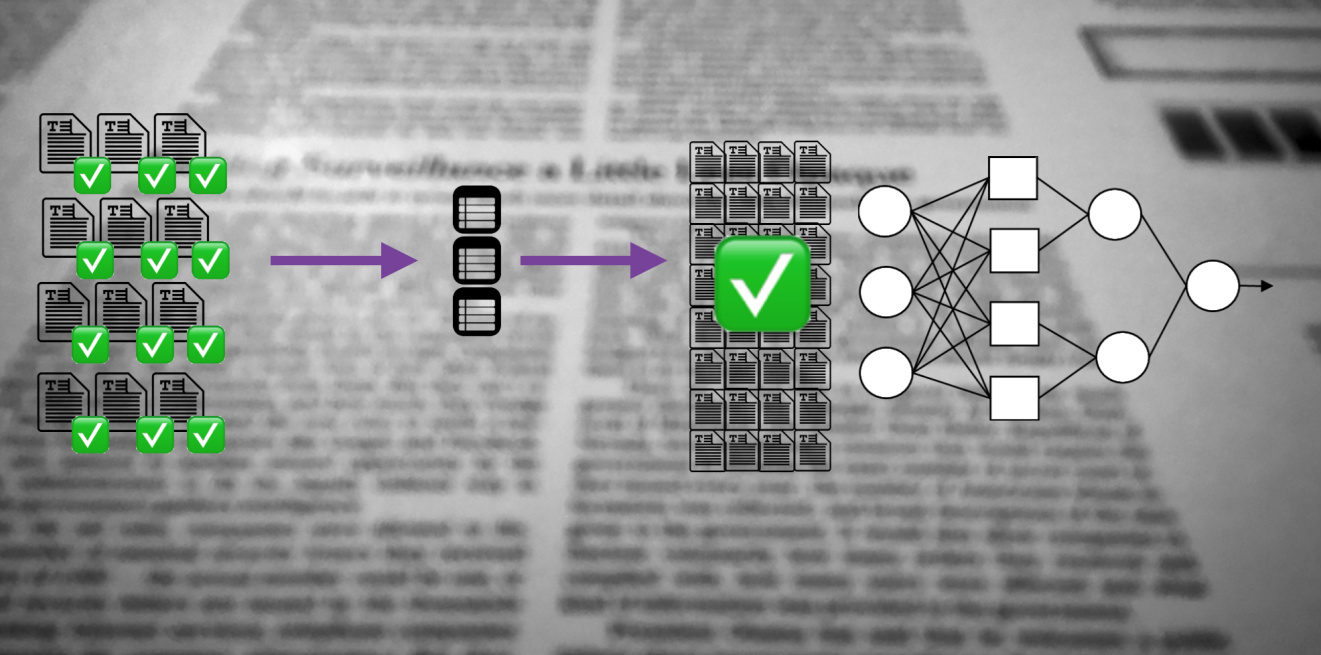

Во время предвыборной гонки в США количество репостов фальшивых новостей в соцсетях превышало количество перепостов правдивых сообщений, потому что фальшивки больше соответствовали ожиданиям или оказывались более захватывающими. После выборов компания Facebook наняла независимых факт-чекеров, которые стали помечать непроверенные сообщения для предупреждения пользователей.

Сочетание повышенной политической поляризацией общества и склонности к прочтению главным образом заголовков, даёт кумулятивный эффект. Поддельные новости также часто распространяются посредством поддельных новостных сайтов, информация с которых часто попадает в главные СМИ, которые гонятся за привлечением пользовательского трафика. А ничто не привлекает трафик так, как броский заголовок.

Но на самом деле одной лишь политической сферой воздействие фейков не ограничивается. Есть множество примеров, демонстрирующих влияние лживых новостей на общество.

Австралийская компания, занимающаяся производством видео, два года выпускала фейковые вирусные ролики, которые набирали сотни миллионов просмотров.

В продуманный фейк про Сталина, лик которого якобы появился в московском метро, поверили даже 1-го апреля.

Миллионер Илья Медков в 1992 году начал платить крупным информагентствам России и СНГ (включая «РИА Новости», «Интерфакс», «ИТАР-ТАСС»). «ИТАР-ТАСС» пустило в СМИ ложное сообщение об аварии на Ленинградской АЭС в январе 1993 года. В результате акции ведущих скандинавских компаний упали в цене, и до появления опровержения в СМИ агенты Медкова скупали самые выгодные акции шведских, финских, и норвежских компаний.

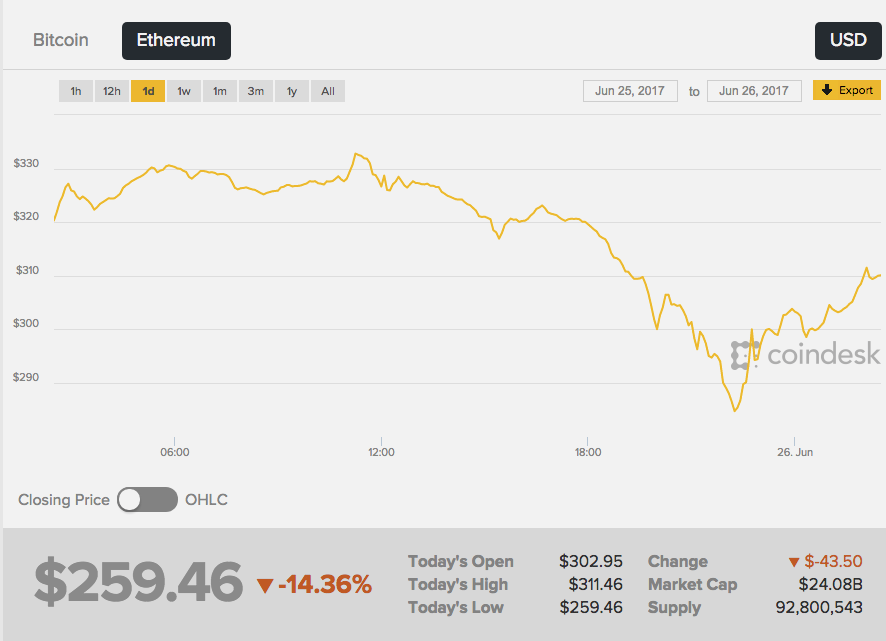

26 июня 2017 года курс второй по капитализации криптовалюты Ethereum резко пошел вниз — биржа отреагировала на появившиеся в сети слухи о трагической смерти создателя Эфира Виталия Бутерина. Причем первая «срочная новость» появилась на анонимной имиджборде 4chan — а это источник, прямо скажем, не самый надежный.

В Википедии написали, что «Виталик был русским программистом», а затем и жёлтая пресса подхватила новость. В результате курс эфира упал на 13%, примерно с 289 до 252 долларов. Курс стал расти сразу после опровержения новости со стороны самого Виталия.

Нет никаких доказательств того, что кто-то сознательно создал фейк для получения прибыли на разнице курсов криптовалюты. Неоспоримо лишь то, что выдуманная новость без единого подтвержденного факта оказывает мощнейшее воздействие на людей.

Имитация реальности

Французская певица Франсуаза Арди в видео повторят речь Келлиэнн Конуэй — советницы президента США Дональда Трампа, получившей известность после высказывания об «альтернативных фактах». Интересно здесь то, что на самом деле Арди 73 года, а в видео она выглядит как двадцатилетняя.

Ролик Alternative Face v1.1 создал немецкий художник-акционист Марио Клингеман. Он взял аудио интервью Конуэй и старые музыкальные клипы Арди. А затем применил генеративную нейронную сеть (GAN), которая сделала уникальный видеоконтент из множества кадров разных клипов певицы, а поверх наложила аудиодорожку с комментариями Конуэй.

В данном случае подделку легко распознать, но можно пойти дальше — внести изменения в файл аудио. Изображению и звуковой записи люди поверят с большей охотой, чем просто тексту. Но как подделать сам звук человеческого голоса?

GAN-системы способны изучить статистические характеристики аудиозаписи, а затем воспроизвести их в другом контексте с точностью до миллисекунды. Достаточно ввести текст, который нейросеть должна воспроизвести, и получится правдоподобное выступление.

Канадский стартап Lyrebird опубликовал свои алгоритмы, которые могут сымитировать голос любого человека на основе звукового файла длиной в одну минуту. Для демонстрации возможностей компания выложила беседу между Обамой, Трампом и Клинтон — все герои, разумеется, были фейками.

DeepMind, Институт глубокого обучения Baidu и Монреальский институт изучения алгоритмов (MILA) уже занимаются вопросами высокореалистичных алгоритмов преобразования текста в речь.

Результат пока не идеален, можно быстро отличить воссозданный голос от оригинального, но схожесть чувствуется. Кроме того, в голосе сеть меняет эмоции, добавляет злости или грусти в зависимости от ситуации.

Генерирование изображений

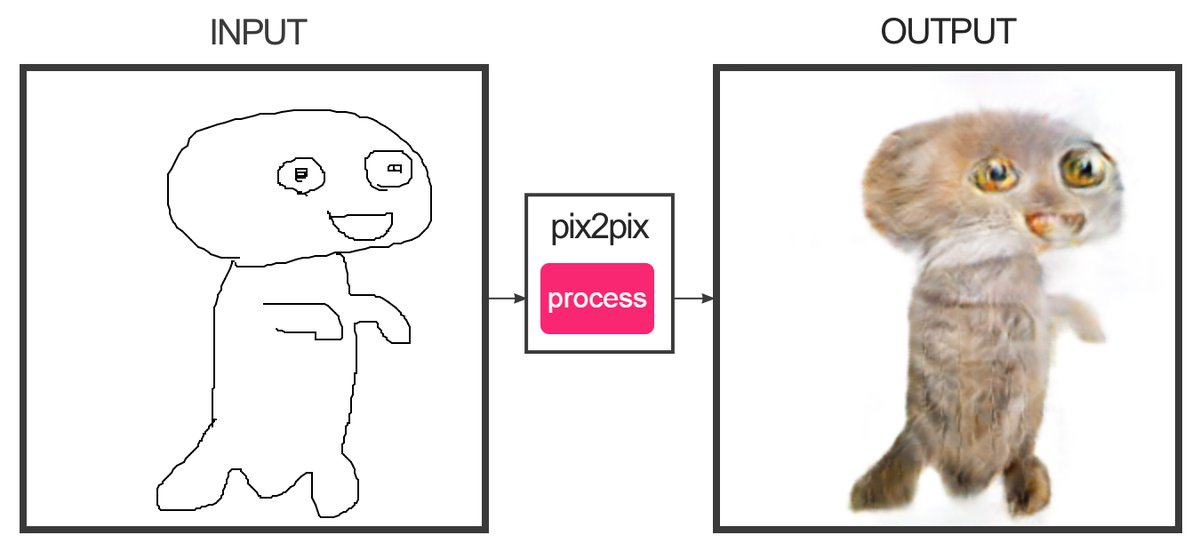

Разработчик Кристофер Гессе создал сервис, который с помощью машинного обучения может «дорисовывать» наброски, состоящие из нескольких линий, до цветных фотографий. Да, это тот самый сайт, который рисует котиков. Котики получаются так себе — трудно перепутать их с настоящими.

Программист Алекса Джоликёр-Мартино смог сделать котов, которые точь-в-точь как настоящие. Для этого он использовал DCGAN — Deep Convolutional Generative Adversarial Networks (глубокие генеративные свёрточные состязательные сети). DCGAN способны создавать уникальные фотореалистичные изображения с помощью сочетания двух глубоких нейросетей, которые состязаются друг с другом.

Первая сеть (генерирующая) получает на входе значения переменных, а на выходе выдает значения функции от этих переменных, которые должны «убедить» вторую сеть (различающую, или дискриминирующую) в том, что результаты работы первой сети неотличимы от эталона. В качестве образцов в работе Джоликера-Мартино использовалась база данных из десяти тысяч кошачьих портретов.

Использование методов DCGAN позволяет создавать фальшивые изображения, которые невозможно без другой нейросети объективно признать фейковыми.

Сочетания контента

В Университете Вашингтона разработали алгоритм, позволяющий накладывать аудио на видео выступления человека с точной синхронизацией губ. Алгоритм обучался на 17 часах видеообращений Барака Обамы. Нейронную сеть обучили имитировать движения губ Обамы таким образом, чтобы исправлять их движения, имитируя произношение нужных слов. Пока что можно генерировать только видео со словами, которые человек действительно говорил.

А теперь посмотрите на работу алгоритма, который позволяет на лету менять мимику другого человека на свою собственную мимику. На видео с Трампом (ещё есть демонстрация на Буше, Путине и Обаме) накладывают кривляния человека в студии, и получается кривляющийся Трамп. Алгоритм используется в программе Face2Face. Созданная технология похожа по принципу работы на бота Smile Vector, который на фотографиях добавляют людям улыбку.

Таким образом уже сейчас возможно создать реалистичное видео, в котором известный человек говорит выдуманные факты. Речь можно нарезать из предыдущих выступлений так, чтобы составить любое послание. Но в скором времени даже такие ухищрения окажутся лишними — любой текст сеть вложит в уста фейковому персонажу идеально точно.

Последствия

С практической точки зрения все эти технологии позволяют делать много хорошего. Например, можно улучшить качество видеоконференций, синтезируя недостающие кадры, если они выпадают из видеопотока. И даже синтезировать целые пропущенные слова, обеспечивая отличную связь в местах с любым уровнем сигнала.

Можно будет полностью «оцифровать» актёра и добавить его реалистичную копию в фильмы и игры.

Но что же будет с новостями?

Вполне вероятно, что в ближайшие годы генерирование фальшивок выйдет на новый уровень. Появляются и новые способы борьбы. Например, если соотнести фотографию с известными условиями на местности (скорость ветра, наклон теней, уровень освещённости и т.д.), то эти данные помогут выявить фейк.

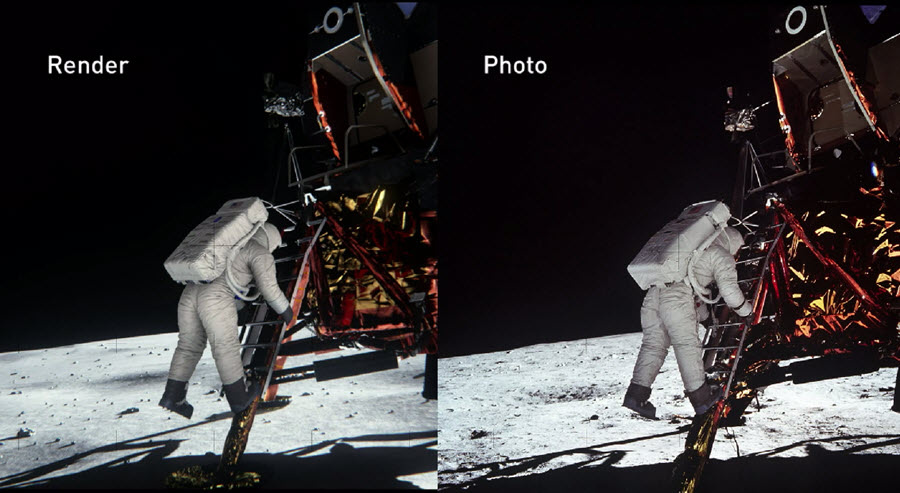

В 2014 году инженеры NVIDIA реконструировали сцену высадки на Луну настолько точно, насколько могли, основываясь на документальных сведениях, сохранившихся с того времени. При этом учитывались все физические и оптические свойства предметов, чтобы выяснить, как свет отражается от различных материалов и ведет себя в условиях реального времени. В результате они смогли достоверно подтвердить подлинность фотографий NASA.

NVIDIA подтвердили, что при должной подготовке можно доказать подлинность (или опровергнуть) даже самой сложной фотоработы, созданной десятилетия назад.

В прошлом году Агентство по перспективным оборонным научно-исследовательским разработкам США (DARPA) запустило четырехлетний проект по созданию открытой системы Media Forensic, которая сможет выявлять фотографии, которые были так или иначе обработаны или искажены.

Нейросети смогут не только менять оригинальный контент, но и выявлять самые качественные фейки. Кто в итоге выиграет в этой гонке технологий — покажет время.

Источник