В рубрике «Выдающиеся программисты 21 века» уже была статья про гения программирования Джона Кармака, создателя движков для Doom, Quake и других культовых игр. Потом он занялся разработкой ракет (они в Armadillo Aerospace реализовали вертикальную посадку раньше SpaceX), а затем — систем VR, софта для Oculus Rift и других устройств. Сейчас началась четвёртая фаза в его карьере.

В интервью изданию Dallas Innovates 52-летний Кармак рассказал о новом проекте — системе сильного ИИ (AGI), над которым он работает самостоятельно, без участия больших корпораций, как отшельник в своём особняке в Далласе.

Сильный ИИ общего назначения не будет уступать среднему человеку в понимании происходящего и решении проблем. По оценке Кармака, с вероятностью 60% такая система (альфа-версия) будет создана до 2030 года, с вероятностью 95% — до 2050 года. Это самая важная и интересная задача, которая сейчас стоит перед человечеством.

Ещё будучи техническим директором Oculus VR (в составе Meta*) Джон Кармак назвал ИИ одним из самых важных направлений в технологическом развитии. Практически никто не сомневается, что системы AGI появятся в ближайшее время. Вопрос в том, кто первый добьётся прорыва: сейчас в этой области работают и компьютерные корпорации, и лучшие учёные из академических кругов.

В августе 2022 года Кармак основал AGI-стартап Keen Technologies, который привлёк $20 млн внешнего финансирования. Хотя Джон мог сам себе выписать чек на эту сумму, по его словам, привлечение внешних инвесторов поможет ему работать более дисциплинированно. Деньги нужны для приглашения нескольких талантливых инженеров (уже сделано) и сооружения небольшого локального вычислительного кластера, хотя, по словам Джона, большие вычисления выгоднее загружать в облако, но и без локальных серверов тоже трудно обсчитывать все текущие модели.

Среди прочего Джон Кармак поведал, как он погрузился в эту новую область. Нужно было с чего-то начать. Что делать, когда ваши представления о предметной области отрывочные и неупорядоченные?

«Я попросил список литературы у Ильи Суцкевера, ведущего научного сотрудника OpenAI. Он дал примерно 40 научных работ и сказал: „Если ты действительно усвоишь эти статьи, то будешь знать 90% всего, что сегодня актуально“. Я прочёл их — и знания в голове начали упорядочиваться».

Наверняка некоторым читателям захотелось сделать то же самое… К сожалению, письмо от Суцкевера к Кармаку не пережило политику двухлетнего автоудаления всех писем в компании Meta*, поэтому оригинал утерян.

Список литературы по ИИ. Самое основное

Пользователи HN в комментариях и отдельных тредах составили предположительный перечень этих фундаментальных научных работ. Его можно рекомендовать всякому, кто хочет начать обучение или работу в области ИИ, чтобы максимально быстро разобраться в теме. Если сконцентрировать свои интеллектуальные ресурсы, то при наличии фундаментального образования можно усвоить материал из научных работ всего за несколько месяцев или даже недель. В любом случае, это гораздо быстрее, чем несколько лет обучения по специальности «Искусственный интеллект».

Итак, список.

Глубокое обучение:

- ImageNet Classification with Deep Convolutional Neural Networks (Университет Торонто)

- Generative Adversarial Networks (GAN, 2014, Монреальский университет)

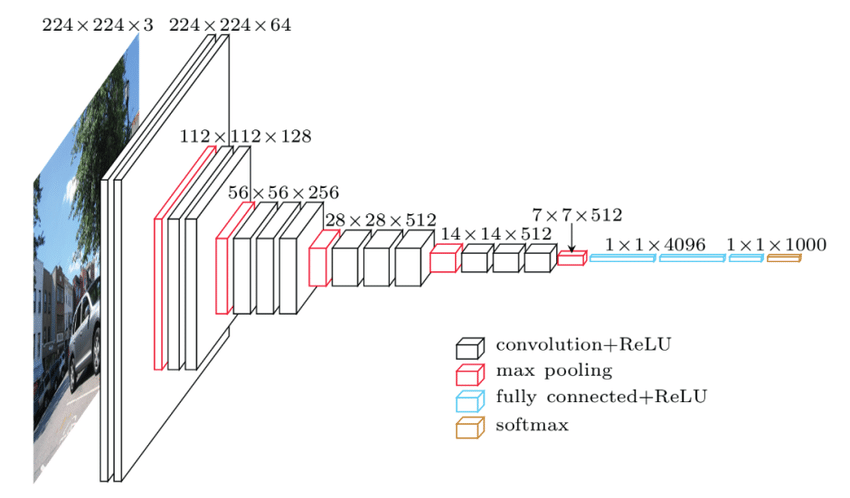

- Very Deep Convolutional Networks for Large-Scale Image Recognition (VGGNet, 2014)

VGGNet

VGGNet

- Deep Residual Learning for Image Recognition (ResNet, 2015)

- Going Deeper with Convolutions (GoogleNet, 2015)

- Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks (2016, Монреальский университет)

- Dynamic Routing Between Capsules (2017, Google Brain)

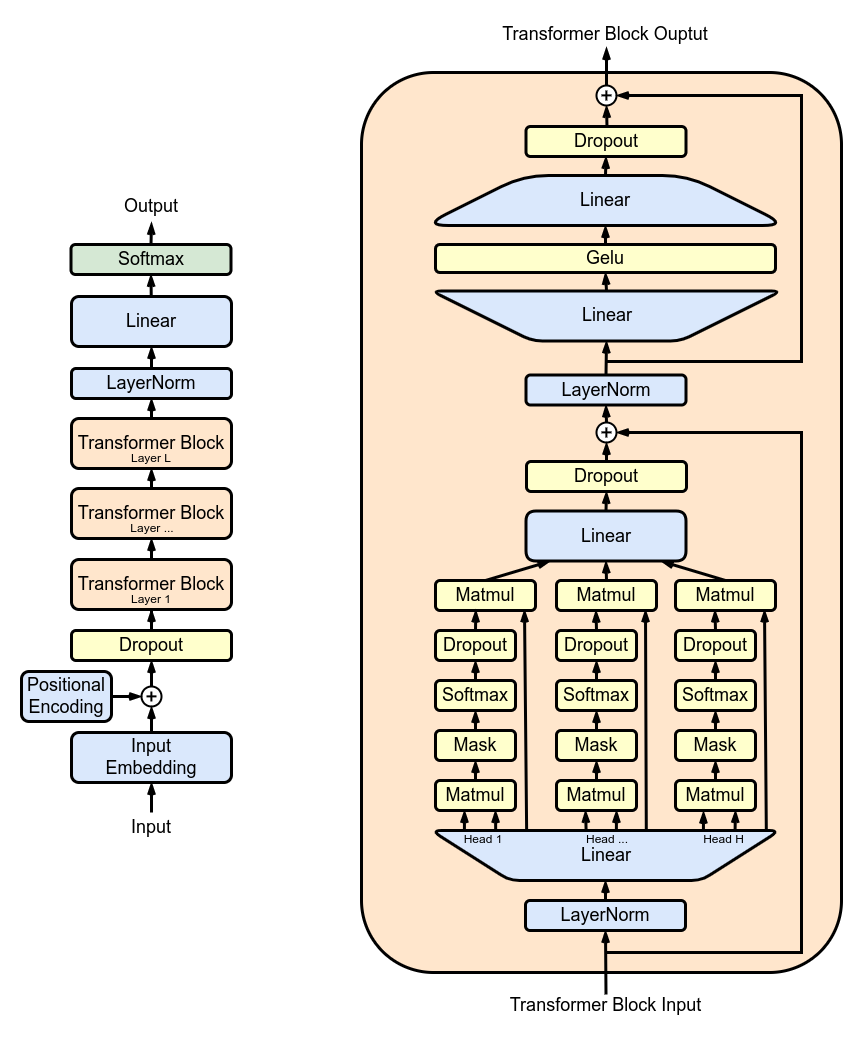

- Transformer (2017). Легендарная статья Attention is all you need с описанием архитектуры Transformer. С неё началось развитие больших языковых моделей, в том числе чат-бота ChatGPT (ноябрь 2022), который стал вирусным мегахитом неожиданно даже для своих создателей (на самом деле в нём нет никаких технических нововведений, кроме удобного интерфейса взаимодействия с пользователями через браузер)

Обработка естественного языка:

- Efficient Estimation of Word Representations in Vector Space (Word2Vec, Mikolov et al., 2013)

- GLUE: A Multi-Task Benchmark and Analysis Platform for Natural Language Understanding (Wang et al., 2018)

- ELMo (Peters et al., 2018, Allen Institute for Artificial Intelligence)

- Improving Language Understanding by Generative Pre-Training (GPT-1, Radford et al., 2018)

GPT-1 (Generative Pre-trained Transformer 1) - BERT (Devlin et al., 2018, Google)

- RoBERTa: A Robustly Optimized BERT Pretraining Approach (2019, Facebook AI)

- Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context (2019, Google AI Language)

- XLNet: Generalized Autoregressive Pretraining for Language Understanding (2019, Google AI Language)

- GPT-2 (2019, OpenAI)

- T5: Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer (2020, Google Research)

- GPT-3 (2020, OpenAI)

- An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale (2020, Vision Transformer, ViT)

- Language Models are Few-Shot Learners (2021, OpenAI)

Обучение с подкреплением:

- Q-Learning (Watkins & Dayan, 1992)

- SARSA (R. S. Sutton & Barto, 1998)

- DQN (Mnih et al., 2013)

- A3C (Mnih et al., 2016)

- PPO (Schulman et al., 2017)

Эксперты предлагают добавить в этот список WaveNet (генеративная модель для звука), Seq2Seq, несколько статей по оптимизаторам (например, Adam), диффузионным моделям и некоторым последним вариантам архитектуры Transformer.

В принципе получился очень лаконичный, качественный и вполне исчерпывающий список научных работ для хорошего погружения в тему. Как говорил Илья Суцкевер, вы получите представление о 90% того, что нужно знать (хотя оставшиеся 10% могут быть сложнее, чем первые 90%).

Все научные работы доступны бесплатно на arXiv или через Sci-hub. Некоторые специалисты рекомендуют погружаться в новую научную область с самых ранних статей в хронологическом порядке. Эти работы легче всего воспринимаются и знакомят с базовыми концепциями. А затем уже по пути исторического развития научной дисциплины — всё новое и новое. За один-два месяца можно усвоить десятилетие развития ИИ, например, 2006–2015 гг., и пойти дальше, вплоть до 2023 г. А затем подумать о том, что ещё никто в мире не реализовал. Наверное, такой алгоритм действий у Кармака.

Более полный список источников по ИИ см. здесь. Там перечислены посты в блогах, видеолекции, ценные подкасты, даже несколько фильмов и научно-популярных книг, которые не только разъясняют теоретические исследования, но и разжигают интерес к ним. Например, мало кто смотрел документальный фильм AlphaGo (2017) про историю компании Deep Mind (сейчас в составе Google) и её создателя — вундеркинда Демиса Хассабиса, который купил первый компьютер в 8 лет на призовые от выигранного шахматного турнира. Затем посвятил жизнь разработке компьютерных программ, которые обыграют человека в любую игру (смысл в том, что жизнь — это тоже игра, только с открытым миром, сложными правилами, множеством встроенных мини-игр типа романтических отношений, квестов и пасхалок).

Почти все современные системы работают на модели Transformer (см. вышеупомянутую научную статью Attention is all you need). В принципе, этого достаточно для практической разработки. Для общего развития желательно также ознакомиться с архитектурой RNN/LSTM, хотя трансформеры по факту могут быть эффективнее во всех практических задачах. Также для фундаментальной подготовки рекомендуют изучить разные MANN (дополненные памятью нейросети, Memory-Augmented Neural Network), в том числе Neural Turing Machine и последующие.

Хорошо бы разобрать отличие архитектур и посмотреть на оригинальные статьи с описанием каждой из них: простые языковые модели (GPT) и оригинальный Transformer упомянуты выше. Но есть ещё CTC, гибридные HMM-NN и преобразователи (RNN-T). Относительно недавно появились диффузионные модели.

Главные темы последнего времени

Для знакомства с последними исследованиями см. топ-100 самых цитируемых работ в ИИ за 2022 год. Там же есть список топ-5 за 2020, 2021 и 2022 годы, чтобы получить общее впечатление о том, какие открытия имеют наибольшее значение. Четыре главные темы последних лет: новые модели трансформеров, система для предсказания фолдинга белков AlphaFold (предсказание свойств новых химических структур, в том числе новых лекарств или принципиально новых токсинов), языковые модели, а также метод CLIP (обучение парами текст+картинка).

▍ Топ-5 за 2022 год

- AlphaFold Protein Structure Database: massively expanding the structural coverage of protein-sequence space with high-accuracy models → (от DeepMind, 1372 цитирований). Применение AlphaFold для расширения покрытия баз протеиновых структур.

- ColabFold: making protein folding accessible to all → (авторы из нескольких организаций, 1162 цитирований). Эффективная опенсорсная модель фолдинга белков.

- Hierarchical Text-Conditional Image Generation with CLIP Latents → (от OpenAI, 718 цитирований). Модель DALL·E 2 с генерацией изображений на основе текстового ввода.

- A ConvNet for the 2020s → (от Meta и UC Berkeley, 690 цитирований). Успешная модернизация CNN на фоне буме применения трансформеров в компьютерном зрении.

- PaLM: Scaling Language Modeling with Pathways → (от Google, 452 цитирований). Гигантская языковая модель от Google с 540 млрд параметров (ChatGPT тихо курит в сторонке), новая инфраструктура MLOps и как она работает.

Остаётся только предполагать, какое направление выберет Кармак. Мы называем это разными словами — нейроны, трансформеры, обратное распространение ошибки… Но всё это математика. А сейчас такое время, что тут можно совершить настоящую революцию за счёт на первый взгляд небольшой оптимизации.

Самые известные современные системы ИИ — GPT-3, Imagen, AlphaFold — состоят всего из нескольких тысяч строк кода основной логики, говорит Кармак, так что написание революционной программы вполне под силу одному человеку.

Джон Кармак считает, что ИИ не произведёт глобальных изменений в обществе, а плавно впишется в жизнь, как облачные сервисы вписались в компьютерную инфраструктуру. Вы просто сможете заказать на любую человеческую задачу нужное количество ИИ-работников (пять Алексеев и десять Марин), как сейчас заказываете инстансы в облаке и серверы на хостинге. Просто дешёвая замена наёмному персоналу, но ничего революционного или принципиально нового для человечества. Чисто вопрос удобства и цены.

Жизнь поменяется незаметно, быстро и органично, как с появлением смартфонов. Через несколько лет никто и не вспомнит, как мы жили без сильного ИИ, словно он всегда был с нами. Это будет банальная и скучная история, которая напоминает энциклопедическую статью о MMAcevedo, наиболее раннем исполняемом образе человеческого мозга.

Такое видение сильно отличается от апокалиптических сценариев адептов сингулярности Элиезера Юдковского и Ника Бострома. Первый разработал для человечества стратегию «смерти с достоинством», а второй предлагает людям отказаться от «полуанархического технологического развития» с передачей власти Мировому правительству.

Предыдущие статьи серии

*Meta признана в России экстремистской организацией и запрещена.