Однако в другом письме, подписанном более чем 90 учёными, говорится, что польза от искусственного интеллекта для биологии превысит любой потенциальный вред.

В прошлом году Дарио Амодей, руководитель известной компании Anthropic, занимающейся разработкой искусственного интеллекта, заявил в Конгрессе, что новые технологии искусственного интеллекта могут вскоре помочь неумелым, но злонамеренным людям проводить крупномасштабные биологические атаки, например, создавать и выпускать вирусы или токсичные вещества, которые вызовут массовые заболевания и смерть.

Сенаторы от обеих партий были встревожены, а исследователи ИИ в промышленности и научных кругах обсуждали, насколько серьёзной может быть эта угроза.

Теперь более 90 биологов и других учёных, специализирующихся на технологиях искусственного интеллекта, используемых для разработки новых белков — микроскопических сущностей, являющихся основой всей биологии, — подписали соглашение, призванное гарантировать, что их исследования с помощью искусственного интеллекта будут продвигаться вперёд, не подвергая мир серьёзному риску.

Биологи, среди которых есть нобелевский лауреат Фрэнсис Арнольд, представляющие лаборатории в США и других странах, также заявили, что новейшие технологии принесут гораздо больше пользы, чем вреда — например, новые вакцины и лекарства.

«Как учёные, занимающиеся этой работой, мы считаем, что преимущества нынешних технологий искусственного интеллекта для конструирования белков значительно превосходят потенциальный вред, и мы хотели бы, чтобы наши исследования оставались полезными для всех в будущем», — говорится в соглашении.

Соглашение не направлено на подавление разработки или распространения технологий ИИ. Вместо этого биологи стремятся регулировать использование оборудования, необходимого для производства нового генетического материала.

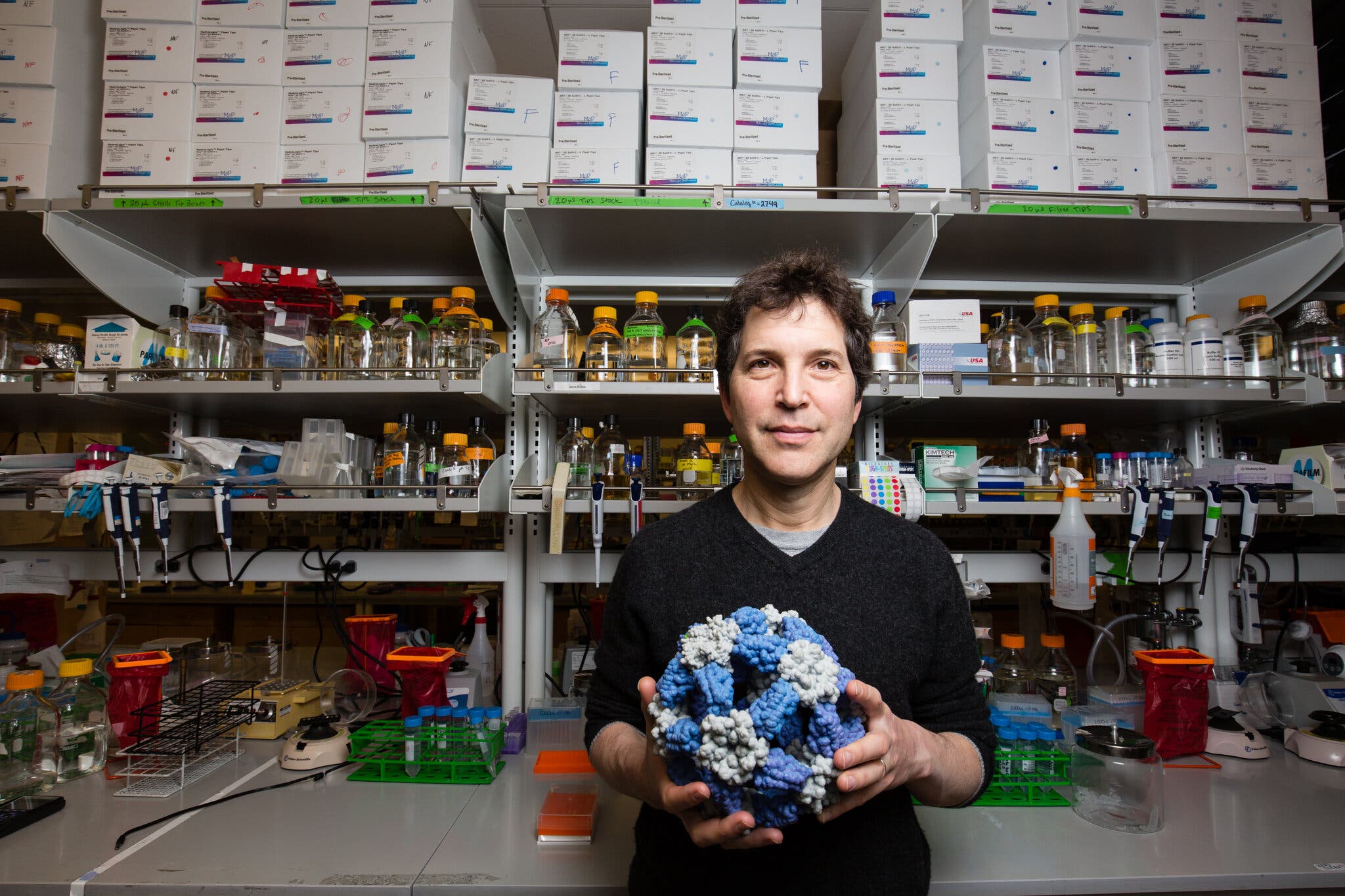

По словам Дэвида Бейкера, директора Института дизайна белков при Вашингтонском университете, который помогал в подготовке соглашения, оборудование для производства ДНК в конечном итоге позволяет разрабатывать биооружие.

«Дизайн белков — это только первый шаг в создании синтетических белков», — сказал он в интервью. «Затем необходимо синтезировать ДНК и перенести дизайн из компьютера в реальный мир — и вот это уже подходящее место для регулирования».

Это соглашение — одна из многих попыток взвесить риски, связанные с применением искусственных интеллектов, и возможные преимущества. Поскольку некоторые эксперты предупреждают, что технологии ИИ могут помочь распространить дезинформацию, заменить рабочие места с необычайной скоростью и, возможно, даже уничтожить человечество, технологические компании, академические лаборатории, регулирующие органы и законодатели пытаются понять эти риски и найти способы их устранения.

Компания доктора Амодея, Anthropic, занимается созданием больших языковых моделей, или БЯМ, — нового вида технологий, которые управляют онлайн-чатботами. Выступая перед Конгрессом, он утверждал, что эта технология вскоре может помочь злоумышленникам создать новое биооружие.

Однако он признал, что сегодня это невозможно. Компания Anthropic недавно провела подробное исследование, показавшее, что если кто-то пытается приобрести или разработать биологическое оружие, то БЯМ-боты оказываются ненамного полезнее, чем обычная поисковая система в Интернете.

Доктор Амодей и другие специалисты опасаются, что по мере того, как компании будут совершенствовать БЯМ и комбинировать их с другими технологиями, возникнет серьёзная угроза. Он заявил Конгрессу, что до этого осталось всего два-три года.

Компания OpenAI, создатель онлайн-чатбота ChatGPT, позже провела аналогичное исследование, которое показало, что БЯМ не намного опаснее поисковых систем. Александр Мондри, профессор информатики Массачусетского технологического института и руководитель отдела готовности OpenAI, сказал, что, по его мнению, исследователи продолжат совершенствовать эти системы, но пока он не видел никаких доказательств того, что они смогут создавать новое биооружие.

Современные БЯМ создаются путём анализа огромных объёмов цифровых текстов, собранных со всего интернета. Это означает, что они перерабатывают или рекомбинируют то, что уже доступно в сети, включая существующую информацию о биологических атаках. (Газета New York Times подала в суд на OpenAI и её партнёра, компанию Microsoft, обвинив их в нарушении авторских прав в ходе этого процесса).

Но в попытке ускорить разработку новых лекарств, вакцин и других полезных биологических материалов исследователи начинают создавать подобные системы искусственного интеллекта, которые могут генерировать новые белковые конструкции. Биологи говорят, что подобная технология также может помочь злоумышленникам в разработке биологического оружия, однако они отмечают, что для создания такого оружия потребуется многомиллионная лаборатория, включая оборудование для производства ДНК.

«Существует определённый риск, который не требует миллионов долларов на инфраструктуру, но эти риски существуют уже давно и не связаны с ИИ», — сказал Эндрю Уайт, соучредитель некоммерческой организации Future House и один из биологов, подписавших соглашение.

Биологи призвали разработать меры безопасности, которые не позволят использовать оборудование для производства ДНК с вредными материалами, хотя неясно, как эти меры будут работать. Они также призвали проверять безопасность и надёжность новых моделей искусственных интеллектов перед их выпуском.

«Этими технологиями не должно владеть лишь небольшое число людей или организаций», — сказал Рама Ранганатан, профессор биохимии и молекулярной биологии Чикагского университета, который также подписал соглашение. «Сообщество учёных должно иметь возможность свободно изучать их и вносить в них свой вклад».