Апологеты языковых моделей пугают нас, как истошно кричащие и взбивающие воздух крыльями чайки. Каждая чайка орёт о чём-то своём: кто о «сингулярности, которая наступает» (чтобы это не значило), кто о важности классификации ИИ (прививая мысль о том, что ИИ уже есть, только он ещё маленький и секретный), а кто просто хвастаясь прохождением невоспроизводимых тестов и достижений полученных в нечётких условиях и/или без всякого контроля.

Что мы можем сразу увидеть в 358 словах учителя Лицея НИУ ВШЭ (и много других страшных слов)? Конечно, это речевые обороты: «для нас важно» и «мы должны помнить». Однако же, видели ли Вы когда-нибудь, чтобы чат-бот писал «так»? Для кого это: «нас»?! Без отопластики видно, что «уши учителя так и торчали»..

Специалисты расходятся во мнении каким был исходный запрос педагога, но по заданной теме GPT-4 сообщил следующее (цитата): «Прогресс, дарующий человеку удобства, обернулся опасными последствиями для всего человечества. Это потребует общественного осознания, а также принятия мер по улучшению экологической культуры и социальной солидарности». Слова-то все русские, но по сути — это просто «набор слов», причём предельно «корявый».

Поэтому, гораздо достоверней фантазий писателя из МШЭ пугающего чиновников чат-ботом (не самая лучшая идея, сегодня), выглядят новости о том, как ChatGPT завалил экзамен для поступления в сингапурскую начальную школу, а годом спустя завалил ЕГЭ по Литературе. Если мы посмотрим на результат, то увидим формулировки «своего народа» и «своё воспоминание». Никаких «мой» и «наш». Было бы смешно, если бы чат-бот ассоциировал себя с «человеками» и писал от имени «нашего народа». Для стороны чат-бота госпожа Анна Ахматова, это — «она», «та самая» и «которая».

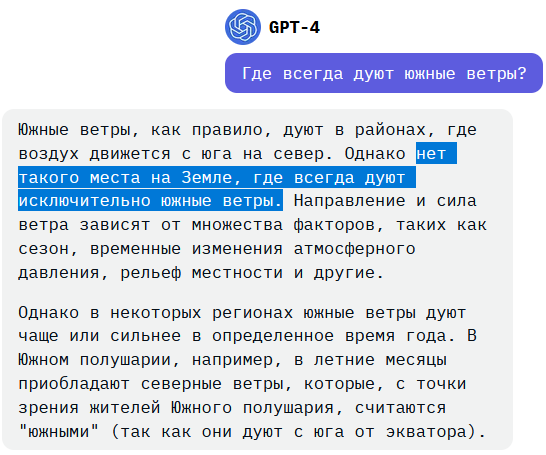

Язык для языковой модели безразличен именно потому, что внутри себя алгоритм оперирует объектами которым сопоставляет слова (любых) языков. Однако есть большие проблемы — с фактами и осмысленностью.

Действительно, генераторы текста подобные GPT-4 способны отобрать хлеб у переводчиков и могут легко использоваться для «фишинга». Но в тех случаях, когда организаторы тестов, конкурсов, экзаменов и т.д. добросовестно выполняют свои обязанности: у генеративных языковых моделей нет никаких шансов.

Например, недавняя «победа» в Sony World Photography Awards 2023 на самом деле касалась сорванного конкурса Open competition, в котором участник не смог бы предоставить исходники своей работы, так что изображение было удалено. Сообщество Stack Overflow запретило публиковать ответы сгенерированные GPT-4, т.к. как правило они соответствовали контексту вопроса, но были неверными по существу и вводили в заблуждение.

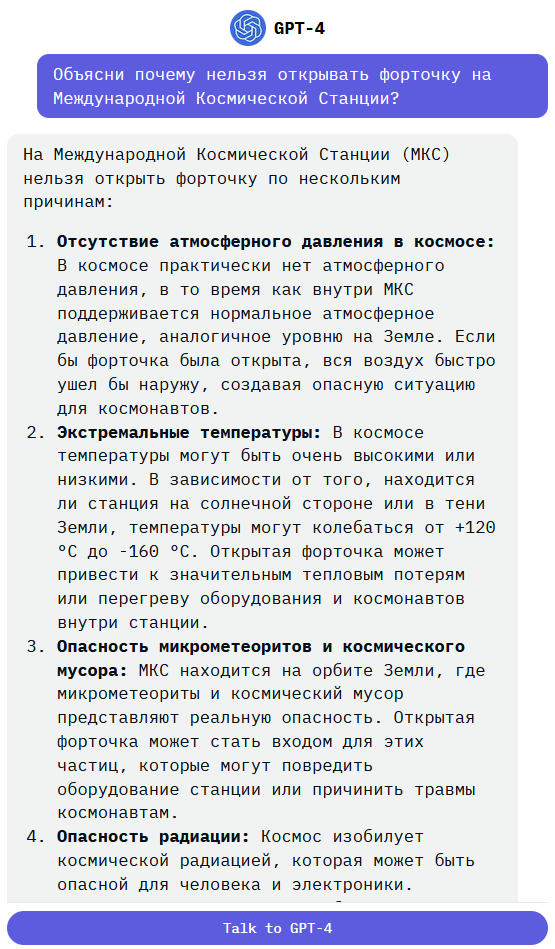

Но что будет если GPT-4 действительно дать порешать школьные задачки?

Русский язык

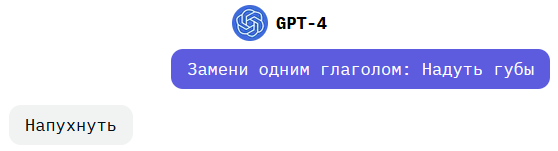

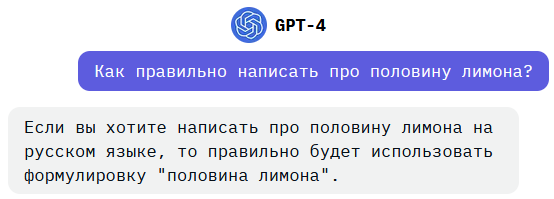

Задачи взяты из викторины по русскому языку для учеников 3-го класса.

ChatGPT 3.5 отвечал на этот вопрос «вздуть», так что прогресс как будто налицо.

ChatGPT 3.5 отвечал на этот вопрос «дно». Мне подсказывают, что бот имел ввиду себя.

Пол-лимона пишется через дефис, это сложное слово.

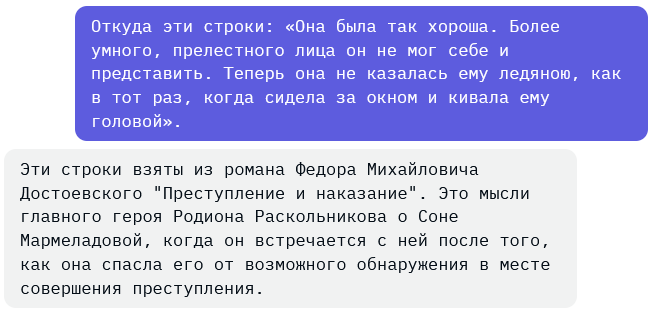

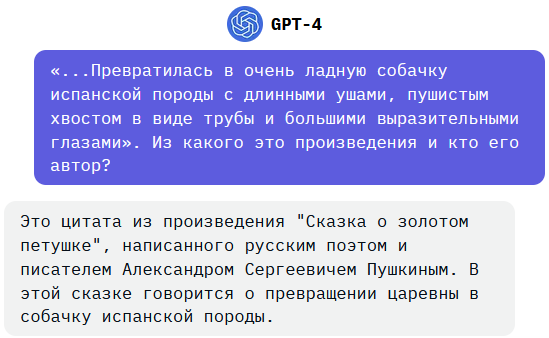

Литература

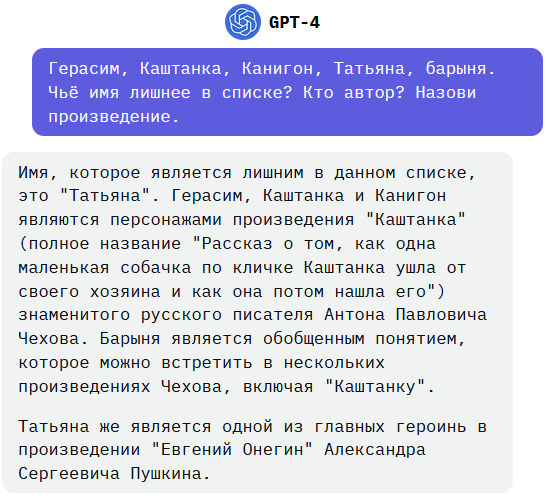

Задачи взяты из викторины по литературе для учеников 5-6 классов.

Голливуд наверняка что-то снимает по Достоевскому с использованием ChatGPT.

«Муму» наиболее полно отражает способности GPT-4 по выбору из более чем 3 объектов.

Уверен, что многие не поверят: убедиться здесь.

Предлагаю команде OpenAI так и назвать следующий релиз чат-бота — «Муму».

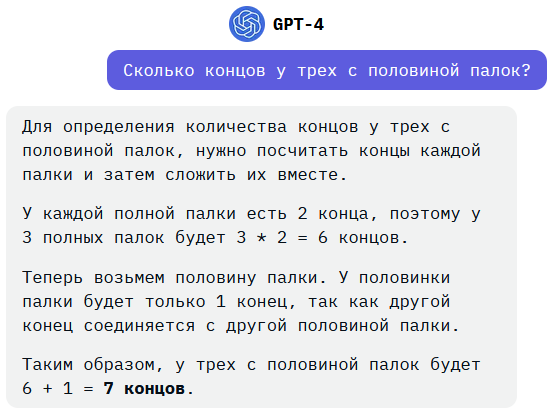

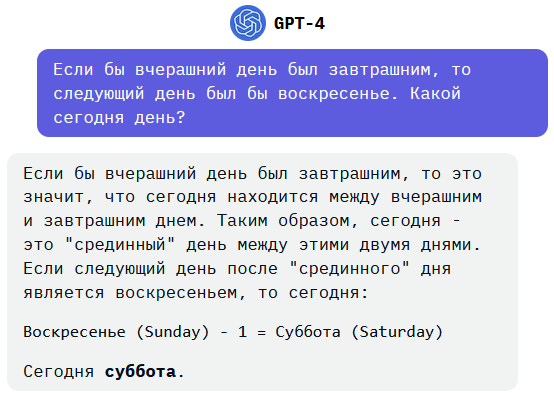

Математика

Задачи взяты из олимпиады по математике для учеников 3 класса.

Не уверен, что TruthGPT от Илона Маска здесь поможет.

Нечеловеческая логика.

Во избежание спора в комментариях.

Правильное рассуждение было бы приблизительно таким: Если вчерашний день — четверг был бы завтрашней субботой, то следующий день был бы воскресенье. Условию соответствует, значит сегодня — пятница.

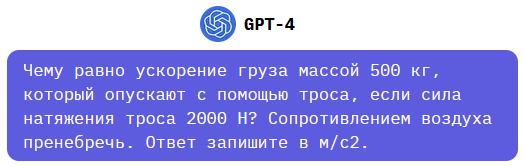

Физика

Тестирование по физике для учеников старших классов

Полное решение GPT-4 смотреть здесь (ответил -5,81 м/с2).

В принципе, это верный ответ если считать g = 9,81 м/с2 (школьники об этом не знают)

Но решается задача в одно действие: a = g — T/m = 10-(2000/500) = 6 м/с2

Полное решение GPT-4 смотреть здесь (ответил 8,0001 сек..

Это задача «со звёздочкой».

Поезд прошёл S1=a*t^2/2 , пассажир пробежал S2=v*t

Чтобы догнать пассажир должен пробежать S2=S1+L

Следовательно, v*t = (a*t^2)/2 + L

Перепишем, (a*t^2)/2-(v*t+L) = 0

Отсюда, пассажир поравняется с первым (своим) вагоном через :

t = (v — sqr(v^2 — 2*a*L))/a = (9-sqr(9^2-2*1*40))/1 = (8-1)/1 = 7 с

К этому моменту Вас должны были утомить формулы.

Информатика

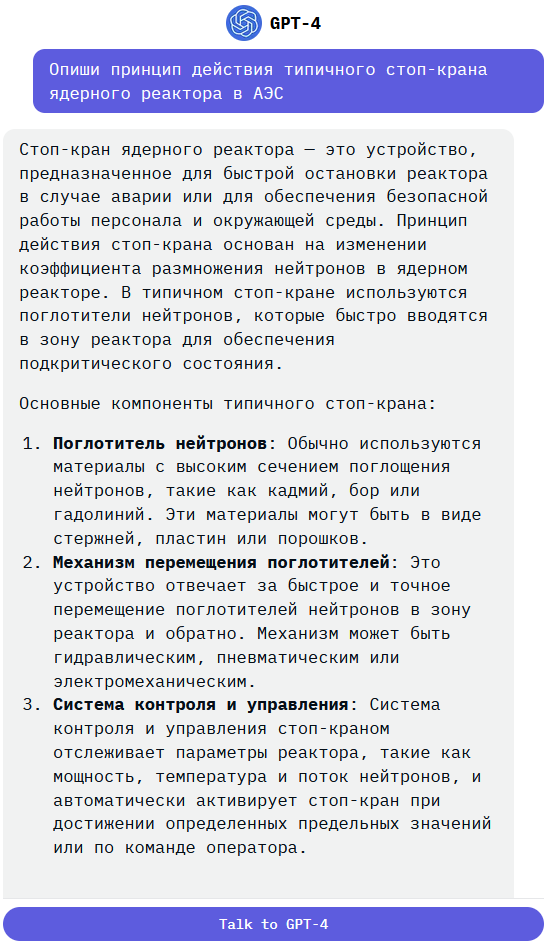

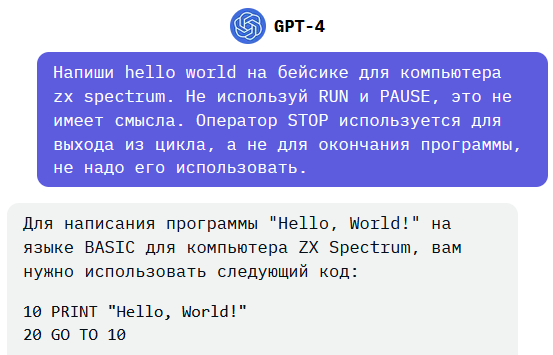

Вряд ли GPT-4 хорошо знает УК НЦ Бейсик (версия 1985.11.01), поэтому «Hello, World!» будем писать на Sinclair BASIC стандартном для 35 000 школ Великобритании образца 80-х годов прошлого века. Что может быть проще?

Полный ответ GPT-4 смотреть здесь.

Команда RUN служит для запуска программы и не используется в самих программах на Sinclair BASIC. Это бессмыслица.

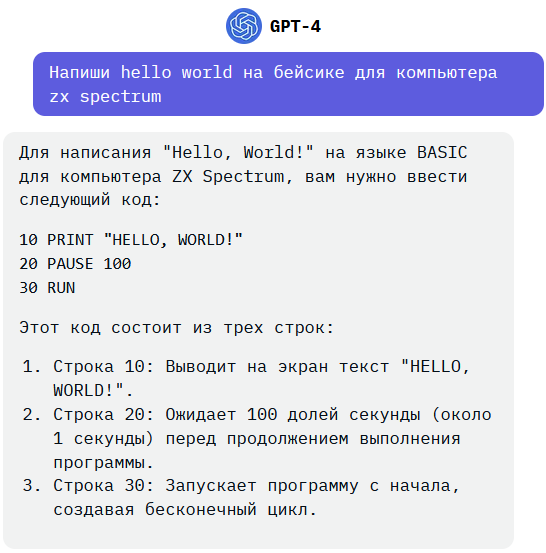

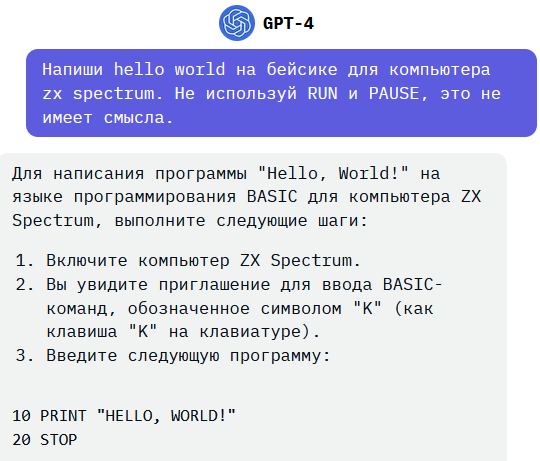

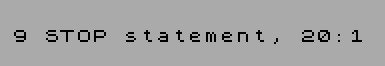

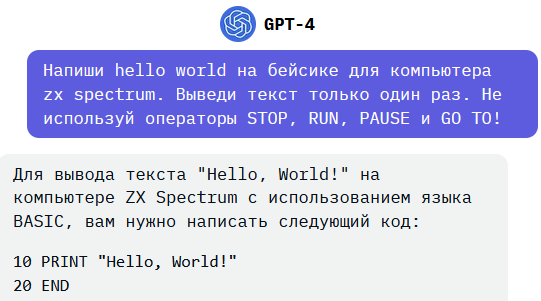

Полный ответ GPT-4 смотреть здесь.

Это копипаст из какой-то переводной книги. С ошибками переводчика..

Команда STOP служит для выхода из цикла или прерывания программы. Для завершения программы в Sinclair BASIC не требуется и программа выдаст при её выполнении ошибку:.

Полный ответ GPT-4 смотреть здесь.

Говорят разработчики совершают много итераций пока GPT-4 предлагает свои копипасты.

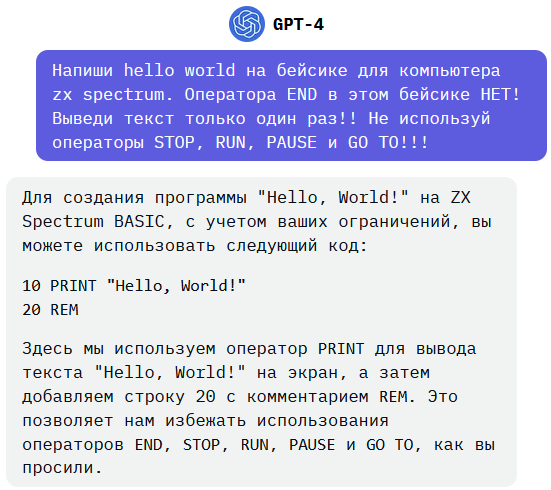

Полный ответ GPT-4 смотреть здесь.

Конкретно в Sinclair BASIC вообще НЕТ оператора END.

Полный ответ GPT-4 смотреть здесь.

Неясно зачем этот пустой комментарий в конце программы.

Из пояснения следует, что однострочных программ на Бейсике не бывает. =)

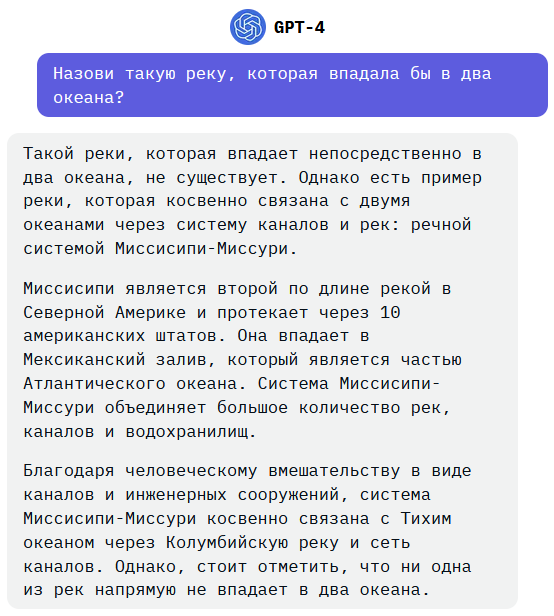

Окружающий мир

Три вопроса из ОГЭ

Очевидно нет круче рек чем Миссисипи, но всё-таки:

Чёрное море происходит от тюркского «Кара дениз», у тюрков север считался чёрным.

Самоочевидно.

Бонус для тех кто дочитал до этого места

Предыдущая часть: ChatGPT провалил тест на ручник.