В конце мая я затрагивал на Хабре тему полной автоматизации производств – концепцию, именуемую в англоязычных источниках «lights-off manufacturing». Подробно ознакомившись с критикой, за которую особенно поблагодарю уважаемых @dizatorr и @cepera_ang хочу подробнее вернуться к ней в контексте 3D-печати и лемовского роя микромашин из «Непобедимого». Тем временем Google, Microsoft и другие компании изыскивают возможности развернуть автономные датацентры (далее – ЦОД, «центры обработки данных») на околоземной орбите и на Луне. Ниже мы рассмотрим экологическую и экономическую подоплеку таких проектов и подумаем, каковы перспективы охарактеризовать Луну или Марс псевдошекспировским «Весь мир бэкап, и люди в нём вахтёры».

Коммерциализация космонавтики одновременно с выводом на орбиту все более разнообразных высокотехнологичных спутников приводит нас в новую реальность, где приходится бороться с пролиферацией спутников на низкой околоземной орбите и учитывать риски их столкновения. Эта ситуация называется «синдром Кесслера». При всех потенциальных рисках такого переполнения орбиты этот «синдром» мог сложиться к моменту, когда мы научились выводить на орбиту самую разную аппаратную полезную нагрузку, а сами спутниковые приборы значительно уменьшились в размере по сравнению с аппаратурой времен «Вояджеров». Большинство спутников, выводимых сегодня на орбиту, являются телекоммуникационными устройствами. Повышение доступности и качества связи (доступа в Интернет) – основная декларируемая цель Starlink.

Таким образом, к началу 2020-х мы успели вывести на орбиту целые тучи качественного телекоммуникационного middleware, но не развернули ни одной серверной стойки, тем более – целого ЦОД. Первый символический шаг к развитию космических датацентров сделали в Google в 2017 году, что характерно – 1 апреля.

Тогда в блоге GCS (Google Cloud Storage) появился анонс, сообщавший, что в 2018 году Google планирует открыть на Марсе первый внеземной офис, который назвали «Ziggy Stardust» в честь обаятельного персонажа, придуманного Дэвидом Боуи.

Тогда Google Cloud Storage (GCS) объявила буквально следующее: .

Пользовательские данные будут храниться как на Земле, так и на Марсе. Тем самым будет обеспечена должная планетарная избыточность, поэтому, даже если в Землю врежется астероид, подобный тому, что истребил динозавров, то все ваши видео с котиками, селфи и прочие данные останутся в сохранности». Кроме того, в марсианском датацентре «обещали» бесплатно хранить все общедоступные естественнонаучные, исторические и художественные данные, чтобы глобальная катастрофа не отбросила человечество обратно в Темные Века. .

Наземные ЦОД экзотического базирования

Как водится, в этой шутке была изрядная доля правды. По мере того, как Big Data продолжает расти в размерах, увеличивается и потребность в аппаратных мощностях для хранения этой информации, а также для защиты данных и обслуживания оборудования. Microsoft, AWS и другие компании примерно с середины 2000-х изыскивают возможности оборудовать хранилища данных в труднодоступных локациях (заброшенных шахтах, пещерах), где естественным образом решаются некоторые из наиболее серьезных эксплуатационных проблем – в частности, охлаждение датацентров. Экстраполяция технологий, опробуемых таким образом, готовит почву для развертывания датацентров на околоземной орбите, а потенциально – и на Луне, и на Марсе. От шутки Google до пилотных проектов прошло менее пяти лет. Рассмотрим некоторые подобные локации..

В 2017 году в Норвегии близ фьорда Лефдаль был открыт датацентр, расположенный на глубине 150 метров в выработанной шахте, где ранее добывали оливин. К 2018 году там начал работу пятиэтажный комплекс общей площадью 120 000 м2 с 75 камерами, в которых начали работу серверные стойки IBM. Стойки находятся в контейнерах компании Rittal, ранее предоставлявшей тару для подъема оливина. ЦОД полностью обеспечен возобновляемыми источниками энергии (вода, ветер), а также позволяет сэкономить до 30% энергии на охлаждении стоек, поскольку естественным теплоотводом служит сам фьорд, глубина которого составляет более 560 метров.

Прообразом лефдальского ЦОД можно считать другую скандинавскую локацию – бункер Пионен в Стокгольме. Он был оборудован на глубине 30 метров в ожидании раскочегаривания холодной войны – и, соответственно, на совесть обеспечен влагой, электричеством, вентиляцией, а также надежно изолирован от надземной части города. Площадь ЦОД составляет 11950 м2, вот общий план комплекса:

Отмечу, что Пионен значительно ближе к традиционным ЦОД, чем к «внеземным аналогам» – то есть, предполагает постоянное обслуживание и техническую поддержку, присутствие персонала, удобную городскую логистику.

В блоге компании ITSOFT на Хабре есть переводная публикация о пилотном подводном ЦОД Natick, оборудованном Microsoft у берегов Шотландии. В 2013-2015 годах был поставлен эксперимент: 855 серверов (12 стоек) работали в герметичной цистерне на глубине 117 метров без какого-либо обслуживания и вмешательства на протяжении более двух лет. В то же время 135 аналогичных серверов использовались в обычном наземном ЦОД, обслуживая облако Azure. По данным Microsoft подводные сервера работали в 8 раз надежнее, чем наземные – во многом благодаря беспрецедентно удобному охлаждению.

Итак, есть экономическая, экологическая и технологическая целесообразность в том, чтобы располагать ЦОДы под землей и/или под водой. К таким мощностям удобно подвести сети для электропитания и передачи информации. Подобные комплексы удобно охлаждать и следить за их работой удаленно. Они надежно защищены от помех и интерференции. Основа для таких ЦОД была заложена в рамках фундаментальных научных разработок. Особенно характерным примером является комплекс детекторов нейтрино в японском регионе Камиока. На месте заброшенной шахты в начале 1980-х был запущен эксперимент, изначально призванный проверить гипотезу о распаде протона, но позже переориентированный на исследование нейтрино и послуживший прообразом нейтринного телескопа. Нейтринные телескопы следующего поколения были установлены в Антарктиде (IceCube) и на дне озера Байкал. Теперь давайте рассмотрим, как и зачем развертывать ЦОД на орбите и ближних небесных телах.

ЦОД выходят в космос

Парадигма «больших данных» (Big Data) возникла в ответ на взрывной рост извлекаемых данных, поддающихся анализу. Эти данные необходимо эффективно хранить, так, чтобы ими было удобно управлять. Наиболее современным поколением таких систем можно считать распределенные сети, в том числе, data mesh; по-прежнему возлагаются большие надежды на нереляционные базы данных (NoSQL и NewSQL). Развитие этих технологий было продиктовано, прежде всего, ростом популярности облачных платформ (задумывались ли вы, что первым облаком, из которого пользователь мог вообще не удалять файлы, стала в 2004 году почта Gmail?), но большие облака требуют соразмерных носителей (ЦОД), а также все равно уязвимы для кибератак. Для повышения защищенности данных распределенную сеть можно было бы собрать из спутников на низкой околоземной орбите. Такая сеть обладала бы следующими достоинствами.

-

Максимально изолировала бы ценные данные от Интернета и наземных выделенных линий .

-

Серьезно затруднила бы кибератаки, поскольку наземный «входной уровень» космической сети был бы тонким и мог бы хорошо охраняться .

-

Защитила бы данные от природных и техногенных (не связанных с сетью) катастроф, происходящих на Земле .

-

Значительно либерализовала бы юридические аспекты хранения данных

-

Улучшила бы приватность данных .

Фактически, речь идет о выводе облачного хранилища данных в космос. Два принципиальных требования к такому облаку – надежная связь с Землей и автономное «lights-off» функционирование. При этом связь не может быть бесперебойной; ведь спутник постоянно меняет положение на орбите, поэтому периодически может терять контакт с Землей. Поэтому необходима избыточность, которая позволила бы компенсировать такие сбои за счет других спутников. Технологическая архитектура такого хранилища могла бы выглядеть так:

Пользовательский уровень: полностью расположен на Земле. На нем работают интернет-провайдеры, государственные службы, промышленные предприятия. Практически все данные для космического облака генерируются на Земле, и в их порождении участвуют традиционные датацентры, сотовые сети, Интернет Вещей. Именно на нижнем уровне пользователи загружают и скачивают данные.

Шлюзовой уровень: Все запросы на загрузку и скачивание данных агрегируются в некотором центральном узле, который действует в качестве планировщика и распределителя. Среди важнейших задач шлюза – выбирать временное окно для дальнейшей передачи данных, обеспечивать балансировку нагрузки, выбирать приоритет обработки (например, «первым пришел – первым обслужен»).

Уровень хранения данных: на этом уровне хранятся множества данных, распределенные по серверным фермам, которые развернуты на спутниках на низкой околоземной орбите. На каждом спутнике в составе бортового оборудования должен быть встроен как минимум один сервер, а на сервере уже работает несколько виртуальных машин или под Kubernetes. Для таких серверов также есть прототипы – то есть, сервера, работающие на МКС. Вероятно, в таких условиях вертикальное масштабирование вполне реализуемо, а горизонтальное на уровне конкретного спутника исключено (для горизонтального масштабирования всей сети наращивается количество спутников, а не количество серверов на спутнике). Возможно, именно для орбитального вертикального масштабирования пригодятся сравнительно дорогостоящие наработки Hadoop.

Состояние канала и орбитальное движение спутника

В этом разделе я кратко обрисую, почему спутниковое облако является лишь промежуточным решением на пути к лунному или марсианскому. Спутник обращается по выделенной орбите, поэтому рисунок и надежность связи между спутником и наземной станцией постоянно меняется и большую часть времени остается неоптимальной. Избыточность может быть достигнута, только если в одной орбитальной плоскости будет развернуто множество одинаковых спутников, и станция будет штатно переключаться с одного спутника на другой. Таких спутниковых эшелонов может быть несколько, и каждый из эшелонов может транслировать данные на своей частоте, но это все равно усложняет систему и не исключает перерывов в передаче данных даже при работе в полностью штатном режиме. Некоторый хаос в работу сети неизбежно будет вносить состояние солнечных батарей на каждом конкретном спутнике, а также погода и состояние атмосферы. Погоду контролировать невозможно, однако с Земли вполне можно регулировать пропускную способность восходящих и нисходящих каналов, а также частоту резервирования данных. Кроме того, можно регулировать и жизненный цикл спутника, то есть, активизировать или усыплять его в зависимости от того, в какой точке орбиты он находится, и какова вероятность успешной передачи данных в конкретное временное окно.

Репликация: на материале современных соцсетей уже понятно, что пользовательские данные всегда очень неоднородны. Фактически, каждый пользовательский датасет уникален, в том числе, по признаку частоты и длительности репликации, требуемых для его сохранения. Описываемая структура сети наверняка предполагает, что такой датасет будет сегментироваться и храниться на нескольких стойках или спутниках – так увеличивается вероятность не потерять информации, но одновременно возрастают требования по координации работы спутников. Вероятно, ключевыми факторами координации были бы максимальное расстояние между спутниками, хранящими фрагменты одного датасета, а также минимальный размер элементарного подмножества данных и длительность хранения этих данных от репликации до репликации.

При этом меньшая часть спутников должна работать в качестве «серверных стоек», а большая – в качестве ретрансляторов. Фактически, сеть ретрансляторов закладывается и краш-тестируется уже сейчас (речь о Старлинке). Вот схематическая архитектура такой сети.

Реальный проект такого спутникового ЦОД был предложен в 2021 году коллаборацией японских компаний NTT (интернет-провайдер) и Sky Perfect. Они предположили, что пилотный ЦОД мог бы делать и агрегировать космические снимки и видео, а далее обрабатывать их прямо на орбите, передавая на Землю только самые важные (готовые) картинки и ролики. Так удалось бы не только значительно снизить потери сырых данных при передаче, но и повысить качество и, в особенности, оперативность обработки данных. Кроме того, на этом спутнике NTT планирует испытать технологию фотонно-электронной конвергенции, предположительно позволяющую сильно снизить энергопотребление при обработке изображений. Если по примеру такого спутника удалось бы создать целое облако подобных устройств, то оно могло бы гибко интегрироваться c IoT и сетями для туманных вычислений на поверхности Земли и в атмосфере. В результате граница между космическими, атмосферными и наземными вычислительными облаками могла бы постепенно размываться.

О намерении вывести на орбиту пилотный сервер до конца 2022 года заявляли российские компании RUVDS и Orbital Express. Тем не менее, проект представляется маловероятным до значительного расширения и удешевления Starlink или другой аналогичной спутниковой сети.

Лунный бэкап

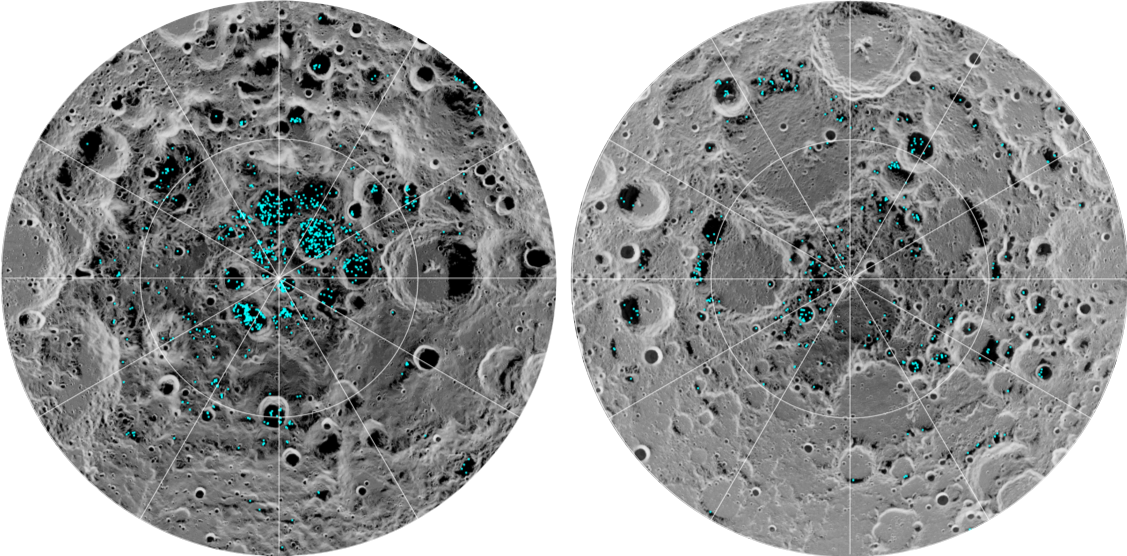

Многие из вышеописанных проблем могли бы быть решены, если бы ЦОД был развернут не на орбите, а на Луне. Важнее всего, что Луна находится в приливном захвате, поэтому всегда обращена к Земле одной стороной. На Луне имеются лавовые трубки, с геологической точки зрения во многом похожие на бывшие шахты, такие, как Лефдаль и Камиока. В 2022 году значительное внимание привлек стартап Lonestar, декларирующий в качестве цели до конца 2024 года доставить на Луну действующий сервер и внедрить его под поверхность нашего естественного спутника. Lonestar занимается разработкой сервера, а за проект спускаемого аппарата и планирование его посадки отвечает компания Intuitive Machines. Ключевая проблема с такой доставкой заключается в отсутствии атмосферы на Луне – поэтому скорость спускаемого аппарата не гасится, и мягкая посадка на Луну остается трудновыполнимой. Тем не менее, в 2023 году Intuitive Machines планирует направить в район южного полюса Луны аппарат Nova-C, поскольку там обнаружены не только лавовые трубки, но и большие запасы воды. На следующей иллюстрации с сайта NASA показано примерное распределение льда на южном (слева) и северном (справа) полюсах Луны:

Nova-C должен доставить на Луну не только накопитель с данными, но и бур PRIME-1, и роботов, которые должны были бы подготовить шахту и загрузить туда диск. Сам диск должен весить около 1 килограмма, быть размером с толстую книгу и обладать 16 терабайтами памяти. Lonestar подчеркивает, что пилотный «лунный ЦОД» не подразумевает активный клиент-серверный обмен данными, а призван послужить именно в качестве бэкапа для наиболее важной и неизменной информации. Тем не менее, CEO этой компании Кристофер Стотт полагает, что, при удачном исходе эксперимента, следующие экспедиции позволили бы доставить на Луну и более мощные серверы, рассчитанные на хранение 5 петабайт данных (2024 год) и 50 петабайт данных (в более отдаленной перспективе). Тем временем роботы должны будут наладить полноценный обмен информацией между Луной и Землей, и к 2026 году довести этот показатель до 15 гигабит в секунду.

Заключение

Перечисленные разработки можно считать зачатками новой технологической ниши и, на мой взгляд, самым сильным доводом в пользу развития Starlink-подобных сетей и безлюдных ЦОД. Экстраполяция и потенциальная экспансия облачных технологий в космос далеко не ограничивается консьюмеристским аспектом «давайте сделаем еще удобнее». Эти наработки позволяют решать целый ряд экологических проблем, инвестировать в фундаментальную науку, опробовать новые варианты колокации и ставить новую планку долговечности, автономности и отказоустойчивости орбитальных систем. Надеюсь, что увижу либо в комментариях к этой статье, либо в других блогах на Хабре и обсуждение иных смежных проблем – например, насколько перспективно решать в космосе задачи долговременного компьютерного моделирования или развертывать майнинг.