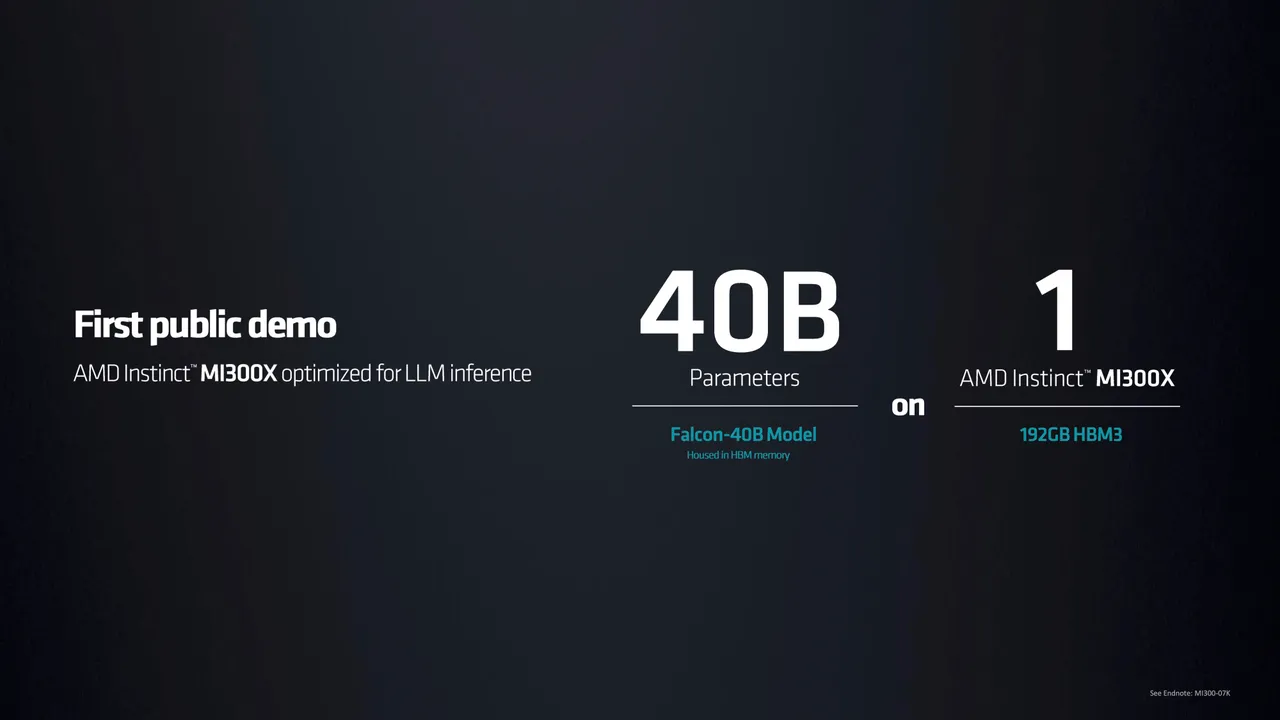

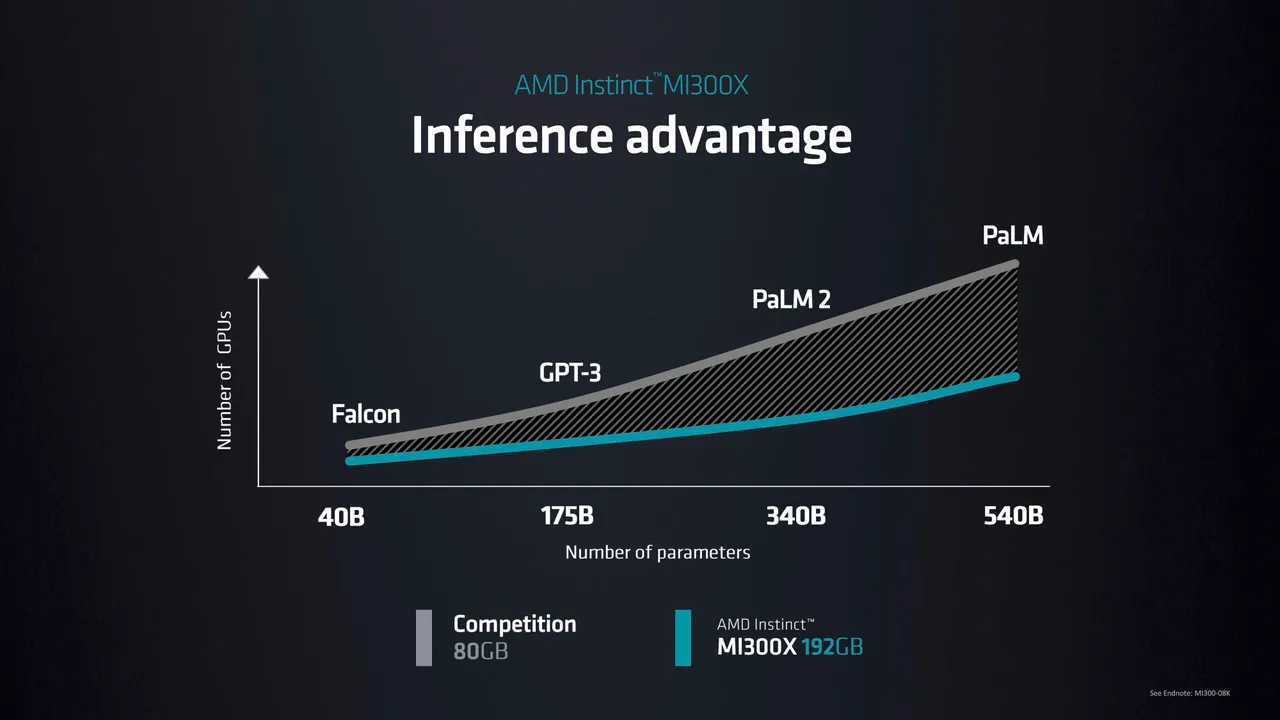

Генеральный директор Advanced Micro Devices Лиза Су утверждает, что возможность запускать всю модель с 40 миллиардами параметров в памяти фактически уменьшает количество необходимых графических процессоров.

13 июня в Сан-Франциско Лиза Су представила чип, который уже стал центральным элементом стратегии компании в области вычислений для искусственного интеллекта. Его главное преимущество — это огромная память и пропускная способность данных для генеративных задач ИИ, таких как большие языковые модели.

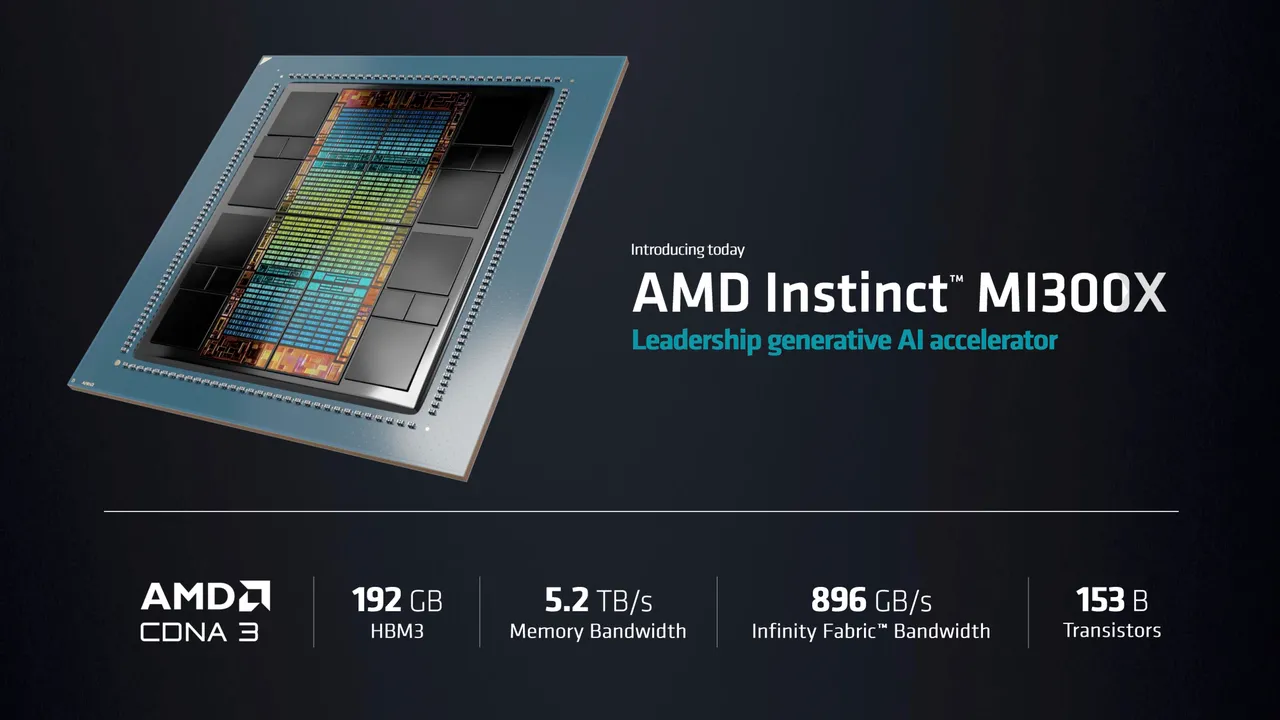

Чип Instinct MI300X стал продолжением ранее анонсированного MI300A. В действительности он представляет собой комбинацию нескольких «чиплетов» — отдельных чипов, объединенных в единый пакет с помощью общей памяти и сетевых соединений.

Су, выступая перед приглашенной аудиторией в отеле Fairmont, назвала эту модель «генеративным ускорителем ИИ» и сказала, что содержащиеся в ней чипсеты GPU, семейство которых известно как CDNA 3, разработаны специально для ИИ и HPC рабочих нагрузок.

MI300X — это версия детали «только для GPU», она представляет собой комбинацию трех чиплетов CPU Zen4 с несколькими чипсетами GPU. Но в MI300X процессоры заменены на две дополнительные микросхемы CDNA 3.

В MI300X количество транзисторов увеличено со 146 миллиардов до 153 миллиардов, а общая память DRAM увеличена со 128 гигабайт в MI300A до 192 гигабайт. Пропускная способность памяти увеличена с 800 гигабайт в секунду до 5,2 терабайт.

|

Specification |

AMD Instinct MI300X |

AMD Instinct MI300A |

AMD Instinct MI250X |

|

GPU Architecture |

CDNA 3 |

CDNA 3 |

CDNA 2 |

|

Dedicated Memory Size |

192 GB |

128 GB |

128 GB |

|

Dedicated Memory Type |

HBM3 |

HBM2e |

HBM2e |

|

Peak Memory Bandwidth |

5.2TB/s |

800GB/s |

Up to 3276.8 GB/s |

«Использование чиплетов в этом продукте является стратегическим, — сказала Су, — поскольку мы можем смешивать и сочетать различные виды вычислений, меняя местами CPU или GPU».

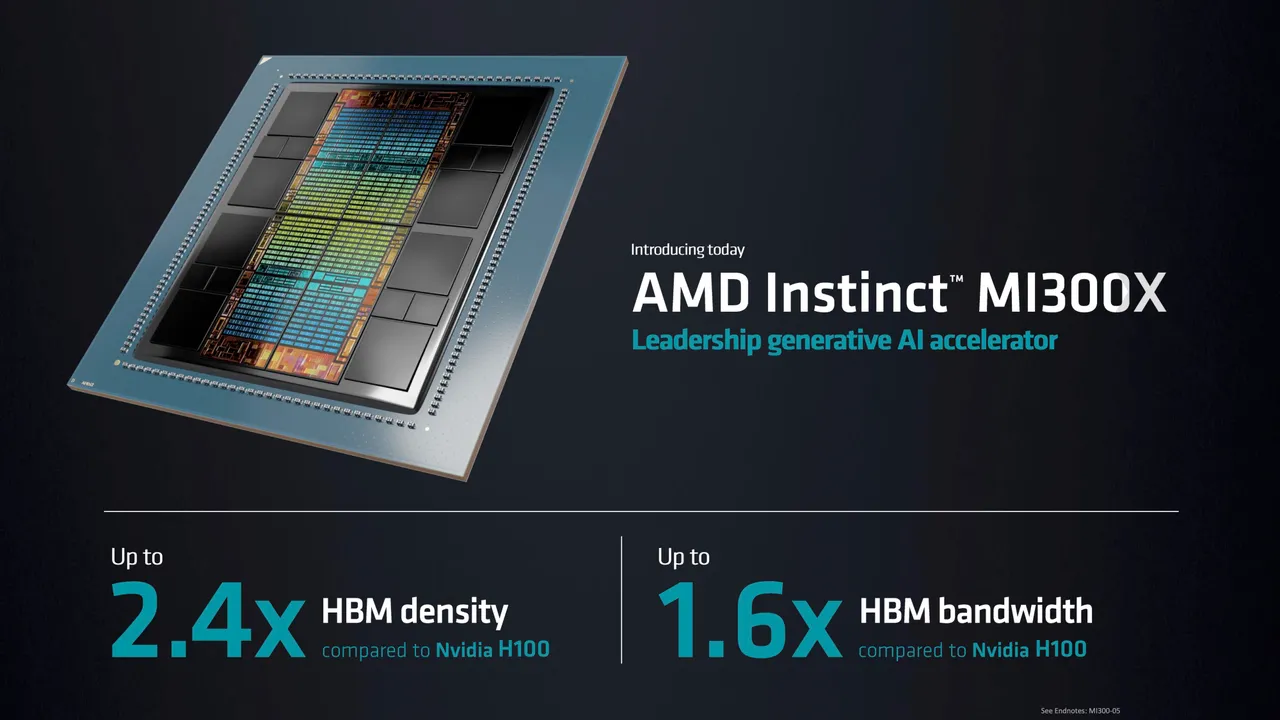

Су сказала, что MI300X будет обеспечивать в 2,4 раза большую плотность памяти, чем GPU H100 «Hopper» от Nvidia, и в 1,6 раза большую пропускную способность памяти.

«Генеративный ИИ, большие языковые модели изменили ландшафт, — говорит Су. — Потребность в больших вычислениях растет экспоненциально, говорите ли вы об обучении или о выводах».

Чтобы продемонстрировать потребность в мощных вычислениях, Су показала часть, работающую над самой популярной большой языковой моделью на данный момент — Falcon-40B с открытым исходным кодом. Языковые модели требуют все больше вычислений, поскольку они строятся с большим количеством «параметров» нейронной сети. Модель Falcon-40B состоит из 40 миллиардов параметров.

По ее словам, MI300X — это первый чип, который достаточно мощный, чтобы запустить нейронную сеть такого размера полностью в памяти, а не перемещать данные во внешнюю память и обратно. Су продемонстрировала, как MI300X создает поэму о Сан-Франциско с помощью Falcon-40B. Предполагается, что один MI300X может запускать в памяти модели примерно до 80 миллиардов параметров.

Благодаря большему объему памяти, большей пропускной способности памяти и меньшему количеству необходимых GPU можно будет выполнять больше заданий по выводу на GPU, чем раньше. По словам Су, это снизит общую стоимость владения большими языковыми моделями и сделает технологию более доступной.

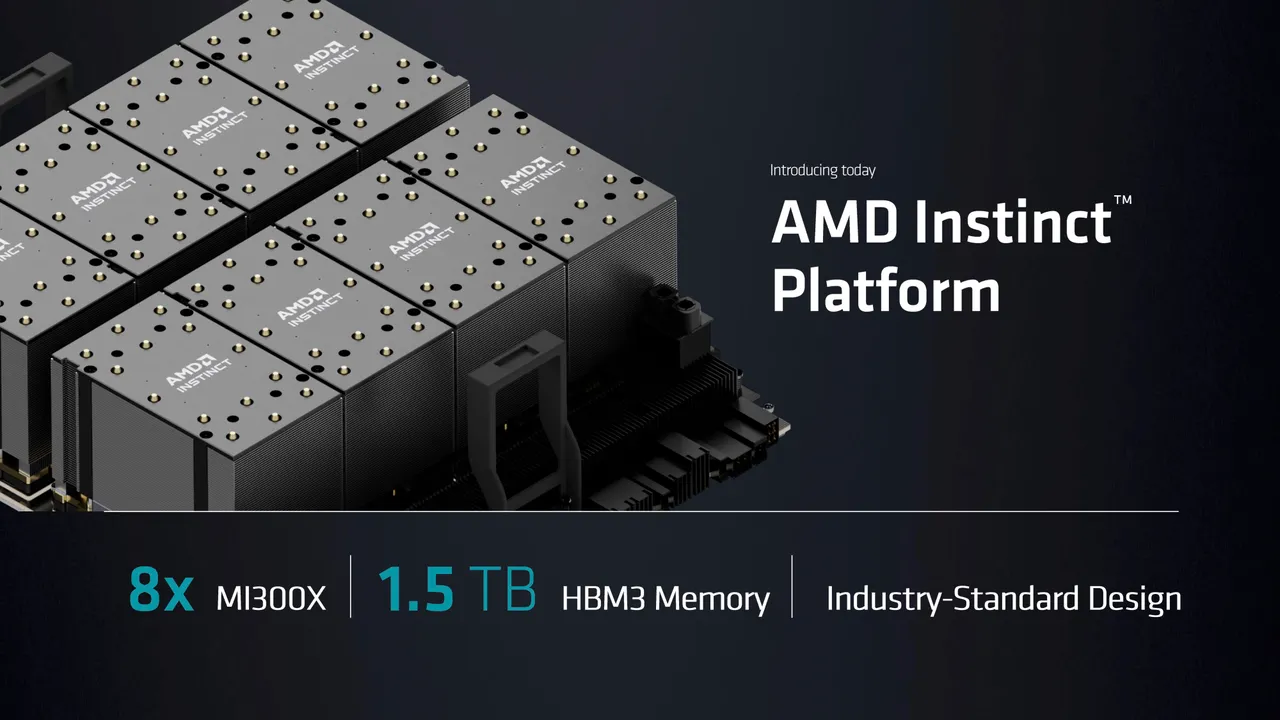

Чтобы конкурировать с системами DGX от Nvidia, компания представила семейство компьютеров ИИ «Платформа AMD Instinct». Первый экземпляр будет объединять восемь MI300X с 1,5 терабайтами памяти HMB3. Сервер соответствует отраслевому стандарту Open Compute Platform spec.

«Клиенты смогут использовать все эти вычислительные возможности ИИ в памяти на стандартной платформе, которая встраивается в существующую инфраструктуру», — сказала Су.

В отличие от MI300X, который является только GPU, существующий MI300A будет противостоять комбо-чипу Grace Hopper от Nvidia, который использует процессор Nvidia Grace CPU и GPU Hopper, о полном производстве которого компания объявила в прошлом месяце.

«MI300A встраивается в суперкомпьютер El Capitan, который строят в Национальной лаборатории имени Лоуренса Ливермора Министерства энергетики», — отметила Су.

В настоящее время MI300A демонстрируется в качестве образца. В третьем квартале 2023 года MI300X начнут поставлять клиентам, а серийное производство обеих моделей начнется в четвертом квартале.