Сегодняшняя новость, касающаяся NVIDIA, архитектуры Pascal и всего, что с этим связано, не претендует на главное место в ленте, да и относится она к категории слухов. Однако слухи эти довольно любопытны. Если ранее считалось, что NVIDIA использует ядро GP104 в двух конфигурациях для выпуска GeForce GTX 1080 и 1070, то теперь зарубежные источники полагают, что таких карт будет три. В этом есть определённая логика, особенно если верны предположения о 2560 ядрах CUDA в GP104, и «третий» в данном случае отнюдь не лишний, но вот информации о нём на данный момент практически нет.

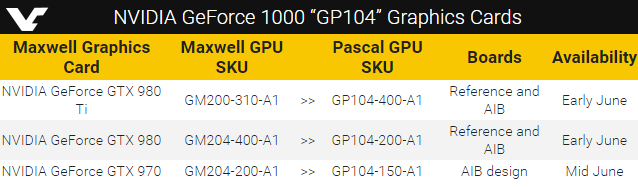

Никаких данных о количестве активных процессоров CUDA или иных функциональных блоков они не приводят ни для одной из трёх конфигураций. Утверждается лишь, что GeForce GTX 1080 и GeForce GTX 1070 увидят свет, как и говорилось ранее, в начале июня и будут укомплектованы чипами с маркировками GP104-400-A1 и GP104-200-A1. Но к ним добавилась ещё одна карта, графический процессор которой имеет маркировку GP104-150-A1. В отличие от первых двух моделей, срок появления на рынке загадочной третьей карты указан как «середина июня».

Если первые два варианта будут выпускаться как на базе эталонных печатных плат NVIDIA, так и на основе собственных разработок крупных компаний, таких как ASUS, GIGABYTE или MSI, то третий, последний в списке, не получит эталонного дизайна от NVIDIA. В этом случае разработчикам союзников NVIDIA дана полная свобода. Уровень производительности у этой карты называют как «близкий у GeForce GTX 970». Что это, GeForce GTX 1060? Отрыв GP104 от GP106 столь велик, что для выпуска карты, стоящей ступенькой ниже GeForce GTX 1070, последний не подходит по мощности? Или просто у NVIDIA уже скопилось достаточно дефектных чипов GP104, которые, тем не менее, можно как-то использовать с пользой для себя? Пока ответы на эти вопросы остаются загадкой.

Источники: