Вообще, пока я не написал, то заголовок в моей голове оно звучало довольно остроумно. Но да ладно. Давайте сразу определимся — это не «обычное» сравнение видеокарт из топа 2023. Я не буду вам рассказывать про самую дорогую видеокарту RTX 4090 и её противостоянию с RX 7900. Это было бы банально. Как и любое другое сравнение видеокарт на ютубе, IXBT, TechnicakCity. собственно предварительное сравнение видеокарт и рейтинг видеокарт я смотрю там. Очень удобный сервис, чтобы быстро прикинуть «на глаз», по технологиям, портам, и примерной производительности.

Объективно, Steam нам говорит, что лучшая видеокарта Nvidia Geforce RTX 3060. Потом идет RTX 2060. Почему?

Все просто:

-

Дешево.

-

Лучи.

-

DLSS.

-

?…

-

PROFIT.

На крайний случай Geforce GTX 1060 — желательно 6 гиговая. А на Radeon судя по данным стим, вообще никто не играет… видимо только майнят!

Но не зря же, в заголовке я написал про «сборщика ведер»? А значит время переходить к введению.

О чем будет статья:

-

О сборке ведер из жести и мусора.

-

О сравнении видеокарт, найденных среди жести и мусора.

-

О главном разочаровании, которое удалось подержать в руках.

-

О неожиданных выводах, того, какая карта самая лучшая.

И помните, это не абсолютный топ производительности. И ваше мнение может отличаться от моего…

Сборка ведер

Для начала определимся. Я не геймер. И не профессиональный сборщик. Не зарабатываю на этом деньги, иногда собираю компьютеры себе, родственникам, причем компьютеры которые решают свои задачи.

При этом, я люблю эксперименты. И вот некоторые из них:

-

Запустить Witcher 3, на GTX 560 в FHD (i5 3450), словить 3 BSOD. Перегрев. Чуть не спалить ПК. А потом догадаться заандервольтить карту, и пройти игру без каких-либо проблем в 70-74 градусках видеокарты (даже не на минималках, кстати).

Как я на самом деле андервольтил gtx 560 (шутка) -

Завести 7-ку на Pentium 3 и 640 MB RAM из списанных ПК, потому что других ПК в офисе нет, а таскать туда с собой ноутбук было лень.

-

Купить ноутбук с гибридной видеокартой от AMD (R8 M365DX). А потом сокрушаться, что они перестали её поддерживать, и выпускать новые дрова.

-

Обрадоваться OEMному блоку от HP. А потом удивляться, почему там блок питания несъемный, и почему туда gtx 680 не входит?

-

Собрать железку на P106-100, просто потому что она была паянная-чиненная, и досталась за бутылку пива? Люблю. Умею. Практикую.

И я молчу про всякую банальщину вроде собрать Xeon на DDR2, докинуть туда 12 оперативы, вкинуть карточку заглушку, и отдать любимой Тещё. А потом удивляться, почему БП не вывез Xeon процессор, и унес за собой всё.

Ну в общем шутки, шутками, а большая часть собранных компьютеров — реальные вёдра. Но они работают, задачи выполняют, и обошлись сильно дешевле чем любое имеющееся на момент сборки решение.

Но вдруг…

В общем… Не вдаваясь в подробности, понадобилось новое «Ведро». Да такое, чтобы и в игры поиграть (на около минимальных в FHD, но так чтобы не только игры прошлого, но и будущего). И денег не сильно много стоило, и простояло достаточно долго.

И первое, во что уперся — видеокарта… Казалось бы очевидный ответ «бушная geforce gtx 1060». Да, такая карта обошлась бы дешево… НО:

-

Ей много лет.

-

Много вариантов после майнинга.

-

Кушает много электричества.

-

Не в каждый корпус влезет.

А самое главное у неё нет DLSS. Т.е. да, вариант хороший. Но для нового ведра, не хотелось.

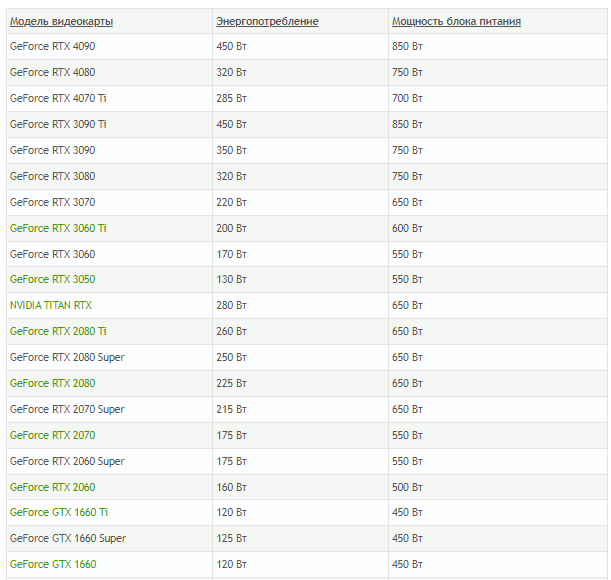

По той же причине отпали и карты 30-й серии. Для «ведра» дорого. Да и почему-то, более новые ПЕЧи кушают ещё больше электричества, хотя казалось бы «техпроцесс-прогресс-все-дела».

В общем, раз самый очевидный вариант не подходит — время заняться сравнением видеокарт, и подбором лучшей исходя из потребностей.

Критерии лучшей видеокарты по мнению сборщика ведер!

Критерии для кандидата на роль лучшей видеокарты в ведре были следующие:

-

Недорого стоит.

-

Относительно новая.

-

Запускает все, что вышло и выйдет в ближайший год-два, на минималках или чуть выше, без риска угореть. (FHD)

-

Малое энергопотребление. Чтобы не тратить деньги на блок питания.

-

Так, чтобы влезла в маленький корпус без нормального охлаждения…

И… Звра… Ще… НЕц… скажете вы. И будете правы. Но железку хочется. Хочется. На БП/Мать/проц тратиться не хочется? Не хочется.

Ну в общем, время было брать в руки кружку кофе. На одном мониторе открывать Technical city. На втором. Доску объявлений. А на третьем… Ах стоп… нет у меня третьего монитора. В общем, а на оставшееся смотреть реальные тесты и обзоры.

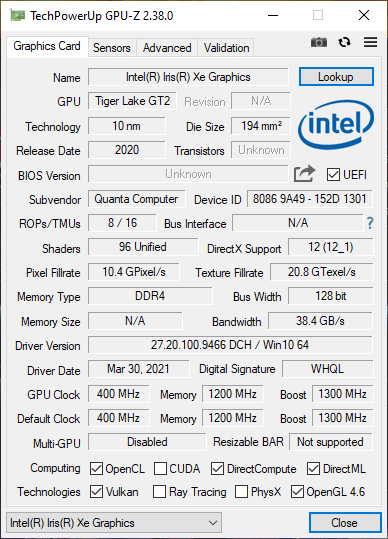

Кандидат №1: Самый очевидный… Iris XE Graphics

Казалось бы, встройка от Интела. Просто идеальный вариант. Слегка не дотягивает по производительности до того, что хотелось. Но я себе думал, что ведь у меня есть хорошая база игр выходящих вплоть до 2018-го года, а уж их то Iris XE должен потянуть.

С другой стороны. Это встройка. А значит можем смело экономить на блоке питания. И даже попытаться ужаться в 350-400 Ватт. Ещё и с процессором задумываться не нужно.

Я просмотрел тесты. Всё. Нужно брать. А потом вспомнил, что:

— у встройки будет один разъем. Дай бог тот.

— для встройки нужна хорошая память.

— Хорошие процессоры c Iris XE, стоят как три старых «Рязани».

-

А ещё встройки любят гореть…

И при этом, все равно недобор с производительностью. Ведь это не дискретная видеокарта.

Хотя признаться честно, я в целом был приятно удивлен мощностью современных встроек. Технически, если нужно собрать компьютер, а видеокарту докупать потом. Вполне достойное решение.

Но всё-же, Iris я оставил как запасной вариант, и продолжил поиски.

Конечно, всегда можно взять блок питания помощней, и поставить на него какой-нибудь GTX780 за 10 копеек, и закрыть вопрос. Но хотелось что-нибудь, тихое, холодное и производительное.

Кандидат №2: Казалось бы, вот она Radeon RX 6400

Закончив со встройками от Intel. Я решил обратить внимание на Radeon, но не на amd radeon r7, а на самое свежее и бюджетное среди игровых, и игровое среди бюджетных решение. Честно говоря, с детства питаю необъяснимую неприязнь к «красным», а ноутбук с «R8» на борту, только усиливает её.

Да, визуально все было хорошо. Все тесты. Не нужно доп питания. Низкий профиль. 150 долларов новая. 4 гигабайта. Но только она раскрывается исключительно в PCIe 4.0. А мы, напоминаю, собираем… Ведро!

Дешевых матерей на Pcie 4.0. ещё поискать. А ещё крайне смущают «6нм» при довольно высоком энергопотреблении (как для такого низкого техпроцесса).

А ещё порезанная шина памяти. А ещё цена. На БУ рынке этой карты нет. А новая такая стоит порядка $250-280 (да, я знаю, что рекомендованная цена у неё 150, но факт есть факт)

В общем. Карточка, действительно неплохая. Она может посоревноваться с GTX 1650. И даже в каких-то вещах её обойти. НО!

У неё есть одна большая проблема. Для максимального раскрытия, она требует к себе хорошего остального железа. А в этом случае, ну уж лучше пересидеть на IRIS XE, и уже потом докупить что-то классом по выше.

В общем, как вы поняли… Всеми фибрами души я сопротивлялся базовому решению от AMD, и искал что-то… что-то дешевле, сопоставимое по мощности, более энергоэффективное. И все ещё помним про запас на будущее.

И вот я понял. Мне нужна RTX 2050. Карточка, пускай с не самой высокой производительностью, но зато тензорные ядра и DLSS позволят продлить ей жизнь надолго. Но оказалась одна маленькая проблема. RTX 2050 — не существует!

Кандидат №3: Победа… но есть нюанс

Итак, вот она рыба моей мечты, видеокарта, которая просто идеально подходит под все мои задачи…

Просьба прерваться для небольшого дисклеймера. В момент, когда я смотрел обзоры, характеристики и примеривался к этой видеокарточке, мной руководило следующее заблуждение. Если Карточка, на архитектуре TU106, поддерживает RTX и DLSS, то почему, карточка на архитектуре TU117, не должна его поддерживать? Да, Да, внимательность не мой конек.

Итак, представьте…

-

40 ватт. Против 75 у большинства видеокарт.

-

128 бит шина памяти.

-

4GB GDDR6.

-

Пропускная способность в 160.0 гб/с.

-

12 Нм технический процесс.

-

Середина 2021-го года выпуска. Но при этом БУ рынок переполнен ею, за цену сильно дешевле рекомендованной.

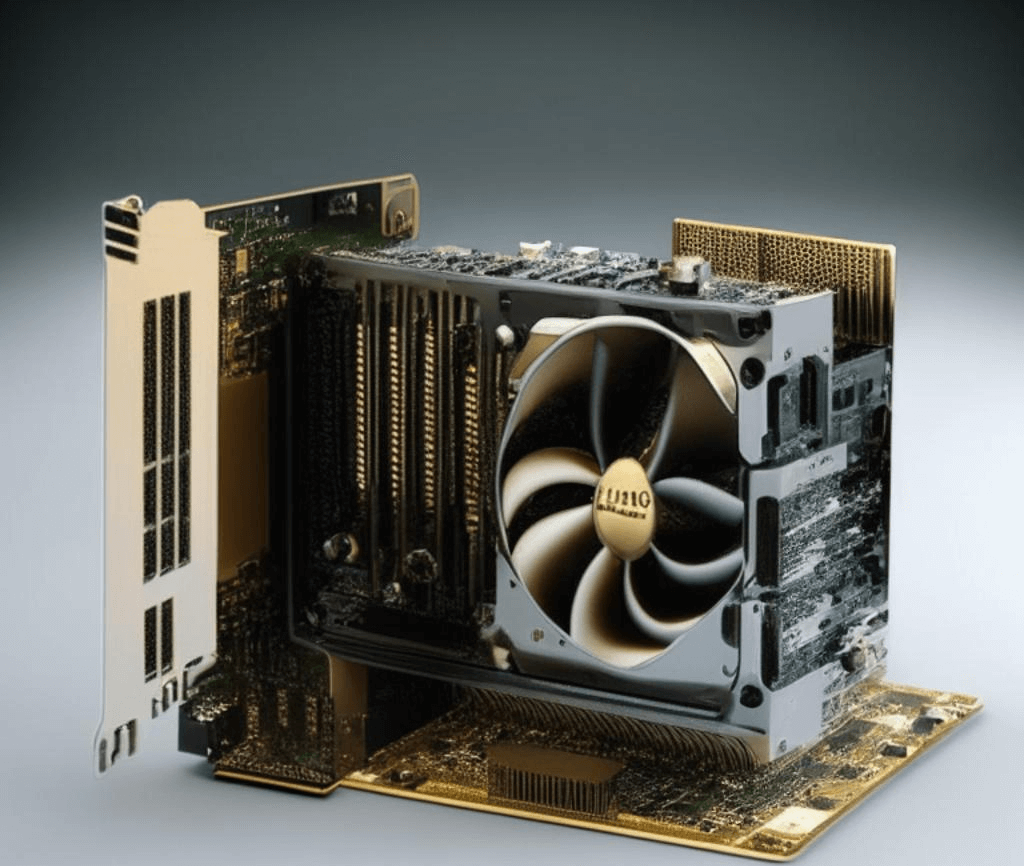

Низкопрофильная. Маленькая. Аккуратная. Разве это карта? Это мечта! Естественно речь пойдет о T600…

А ведь, я дурак, думал, что она ещё и в DLSS с лучами умеет. И это при том, что меня ну ни капли не смутило отсутствие тензорных ядер в спецификациях.

Nvidia они такие. Умельцы с бубном прикручивали к старым видеокартам RTX voice. Так, почему бы T600 не уметь в DLSS?

А ведь именно DLSS это тот параметр, который способен максимально продлить жизнь видеокарте, особенно если вы готовы мириться с какими-то компромиссами в графике, за возможность поиграть в свежие игры на ведре!

Кстати, а по мощности, она не сильно уступает той же RX 6400. В общем, даже несмотря на последующее разочарование с отсутствием DLSS (которое в играх то есть, но на фпс не влияет), мы получаем хорошую карту за вменяемые деньги.

Решаем проблему с DLSS

Ну что, приехала карточка. Распаковал. Установил. Запустил. Обрадовался. Немного огорчили температуры в стрессах (примерно такие же как у geforce gtx 1050 ti), но ничего. Андервольтинг ещё никто не отменял (в разумных пределах).

Запускаю я Cyberpunk. Радостно щелкаю на DLSS. Смотрю на ФПС… И ничего не поменялось.

Ну дальше думаю не стоит объяснять. Полез, сообразил что нет тензорных ядер. И подумал, а не лучшим ли вариантом был все тот же RX 6400?

Но потом сравнил цену на видеокарту. Сравнил теплопакет. Прикинул производительность, и вспомнил о волшебном FSR 2.0.

Но ведь FSR мылит. И вообще он не айс. А ещё не всеми играми поддерживается, в отличие от DLSS. Да и посадить его можно на любую карту начиная с 10-ой серии ПЕЧей.

Ну, здесь все предельно просто. Берем DLSS Unlocker (который на самом деле, отнюдь не DLSS, он просто позволяет использовать те технологии, которые NVidia использует для обсчитывания векторов в движении), и при помощи такой маленькой утилитки, подключаем FSR 2.0. там, где его нативно нет.

Профит? Профит!

На что ещё обратить внимание

Все это хорошо, и покупал я видеокарту на БУ. Но если вы по какой-то причине, захотите собрать игровое ведро и купить видеокарту T600, помните о следующих вещах:

-

Они отличаются по заглушкам. Есть заглушки для тонких ПК, есть для полноценных. Мелочь, но если не угадали, или не спросили у продавца, придется побегать за заглушкой.

-

Сама карта оснащена только miniDisplay портами. Есть магазинные версии с переходниками. Есть без. Будьте внимательны. Порт на стороне может обойтись в дополнительные $5-10, что несколько нивелирует низкую стоимость T600.

-

Не все переходники работают с 144hz мониторами. Странная претензия, но держите в голове.

-

Видеокарта, не хочет заводится с материнскими платами Asus. Тестировал на B560+. Ни в какую. Только при переключении BIOS на Legacy режим.

Просто изображение «спасительного» переходника. Вообще их море. они разные. Нужно искать про 144 HZ.

Если хотите выжать из карты максимум. Придётся колхозить дополнительное охлаждение. Обычного направленного вентилятора хватит. Все дело, в крайне неудачной системе с кулером, который гонит весь теплый воздух не туда, куда нужно…

На что в итоге посадил видеокарту?

С видеокартой разобрались. Помним, что собираем ведро. Так в итоге на что я посадил её?

Посадил я её в итоге на HP ProDesk 600 G3 TWR. Да, да на очередную OEM железку. Почему? Потому что мощности 4-х ядерных процессоров до сих пор хватает для запуска современных игр (пускай и на минималках). А OEM компьютеры на БУ рынке, традиционно стоят ну «неприлично дешево»

В итоге получилась крайне занимательная железка с:

-

I7-7700 на борту.

-

16 RAM ddr-4 (доставлял свою).

-

БП на 320 Ватт (это потолок, того что дают HP Prodesk. Обычно вообще 250 ватт).

-

Nvidia T600 (4GB).

Да, я собрал очередное ведро. Которое при этом уместилось в 300 Ватт. И при этом его вполне можно использовать для FHD гейминга.

T600 выбирался, как карточка, которая умеет в FSR (хотя я и надеялся на DLSS). А учитывая что при помощи всяких DLSS unlockеров, можно FSR прикрутить и там, где его официально нет? И главное — это не видеокарта для майнинга!

В итоге мы получили:

Лучшую видеокарту 2023 года. Энергоэффективная. Достаточно производительная. Подойдет не только для игр, но и для работы. И вы можете не бояться брать её на БУ рынке. А учитывая, что у нас кажись, приближается новый Майнинг бум — это довольно хорошее преимущество!

Эта карта мощней «привычных» затычек. И за свои 40 ватт, обеспечивает достаточную производительность. Разве это не делает её идеальной?

Конечно, можно бросать в меня тапки, и говорить, что и процессор можно было бы i3 последнего поколения взять. И на Ryzen посмотреть какой-нибудь 5 1600. И возможно, вы даже знаете лучшую видеокарту (вон тот-же Rx 6400, вообще не хуже).

Но я всего лишь «собиратель вёдер из жести», и это решение оказалось достаточным для запуска всех современных игр. И самым дешевым из возможных. При этом я уверен, что карта не была в майнинге, что она не отвалится от старости, и что при желании, я могу её вставить в любой, даже очень тонкий ОЕМный корпус.

П.С. возможно, кого-то расстроило отсутствие тестов лоб-в-лоб. Ну так, из всех трех карточек (включая встройку) в руках я подержал только t600. А посмотреть на её производительность можно и в YouTube. И на TechnicalCity (сервис по сравнению видеокарт онлайн). И даже на IXBT. Там подробно. На 20 страниц, с тестами, скриншотами. Да и я когда её выбирал. Руководствовался именно общедоступными материалами. Они будут лучше, чем мой пересказ, или скрины с ФПСами.